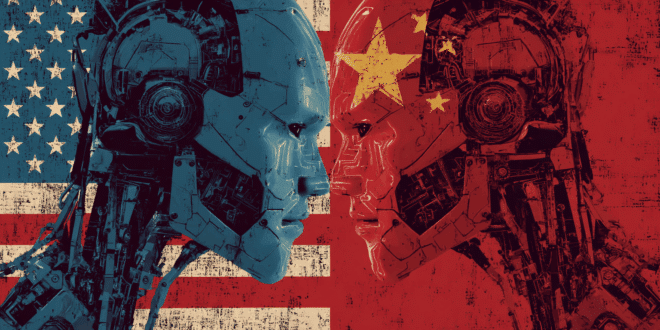

Le lancement de son prédécesseur avait déjà secoué Wall Street, et voilà que DeepSeek lâche R2 – encore plus performant. Cette IA chinoise, open source, serait prête à tenir tête à OpenAI et Nvidia.

Un événement en ligne le 8 mai 2025 pourrait marquer le lancement officiel de R2. Le modèle concurrence directement o3, o4-mini d’OpenAI et Gemini 2.0 Pro de Google. Sur le terrain chinois, cette IA affronte Qwen3 d’Alibaba.

DeepSeek adopte une architecture locale pour R2

Le successeur de R1 serait, selon les fuites, un modèle de raisonnement avancé. R2 promet également des performances renforcées en codage, raisonnement multilingue et vision multimodale.

Ce nouveau modèle possède 1 200 milliards de paramètres et repose sur une architecture mixte d’experts. Cette configuration assure une haute efficacité, en activant seulement 78 milliards de paramètres par jeton.

Pour R2, DeepSeek abandonne les GPU de Nvidia au profit des puces Huawei Ascend 910B. Ce virage réduit la dépendance aux technologies étrangères et réduit les coûts d’entraînement de 97,3 % par rapport à GPT-4.

L’entreprise déploie aussi une chaîne d’approvisionnement locale dédiée au matériel IA. Gage d’une autonomie accrue et de délais de production raccourcis.

Il n’est donc pas surprenant que 5,2 pétaoctets de données suffisent à entraîner R2, qui conjugue efficacité et rentabilité. De quoi remettre en question la suprématie de Nvidia dans les puces IA.

Les vraies innovations de DeepSeek-R2

DeepSeek-R2 ne se contente pas de suivre la tendance, il veut la redéfinir. Et pour cela, il mise sur des avancées concrètes, loin des simples promesses marketing.

Commençons par un point souvent négligé chez les modèles occidentaux : le raisonnement multilingue. Contrairement à de nombreux modèles qui perdent en précision en dehors de l’anglais, R2 maîtrise plusieurs langues avec aisance. On peut citer chinois, l’anglais, et plusieurs idiomes asiatiques, tout en maintenant une logique claire et constante.

Côté programmation, DeepSeek-R2 hérite de la puissance de DeepSeek Coder et va encore plus loin. Il génère du code de qualité dans plusieurs langages, et rivalise avec des modèles spécialisés tout en conservant une polyvalence remarquable. Capable d’expliquer, corriger et même optimiser des architectures logicielles, il devient un véritable assistant pour développeurs, débutants comme experts.

R2 innove également par ses capacités multimodales : il traite et génère du contenu à partir de texte, d’images, de son et de vidéo. Il peut, par exemple, analyser une image, la décrire avec précision ou répondre à des questions visuelles, rendant l’interaction homme-machine plus fluide et naturelle.

Enfin, DeepSeek introduit deux techniques inédites : le Generative Reward Modeling (GRM), qui permet à l’IA d’apprendre par rétroaction générée automatiquement, et le Self-Principled Critique Tuning, où le modèle affine sa logique en s’auto-évaluant. Deux méthodes qui renforcent sa cohérence, réduisent les hallucinations et alignent mieux l’IA avec les attentes humaines

Performances avancées à coûts réduits

DeepSeek reste fidèle à sa philosophie open source et publie R2 sous licence MIT, accessible gratuitement. Exécutable localement et sans connexion internet, le modèle évite ainsi les risques liés au cloud.

De plus, son coût d’inférence s’élève à seulement 0,07 dollar par million de tokens avec cache hit d’entrée. Il n’est pas exclu que R2 provoque, comme le modèle R1, un remous sur les marchés boursiers.

Mais les préoccupations autour de la confidentialité persistent. Pour mémoire, R1 transmettait des données vers la Chine.

Et R2, conçu par une entreprise chinoise, pourrait être soumis à l’accès gouvernemental. En réponse, DeepSeek préconise une installation 100 % locale, contournant habilement ces risques.

Parallèlement, les accusations de distillation de données formulées par OpenAI continuent de peser sur la réputation de R2.

- Partager l'article :