L’intelligence artificielle se trouve une fois de plus au cœur d’une affaire farfelue. La police a placé en garde à vue cinq jeunes Espagnols après qu’ils ont utilisé l’IA pour créer des photos de filles nues.

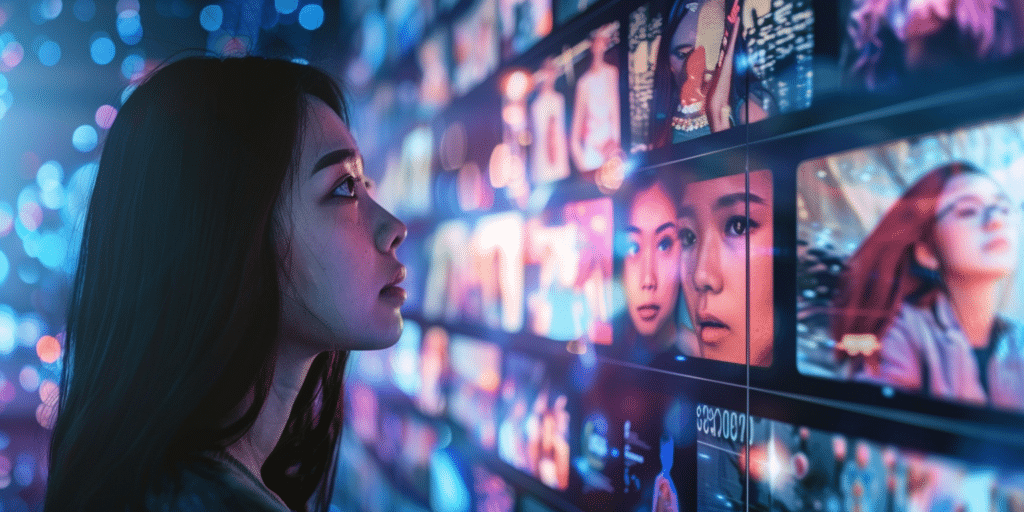

On présente souvent l’intelligence artificielle comme la technologie du futur. Mais aujourd’hui, elle montre un visage plus sombre. En Espagne, à Séville, la Garde civile a interpellé cinq jeunes hommes, composés de mineurs et majeurs. Ces derniers ont mis au point un stratagème des plus machiavéliques. Ils ont partagé de fausses photos nues de 20 jeunes filles. Ce lundi 5 août, la Garde civile a donc ouvert une enquête pour pédopornographie et atteinte à la vie privée.

Des photos de jeunes filles nues : l’IA au service de la manipulation

Utilisant des outils d’IA, ces jeunes Espagnols ont créé des photos nues de leurs victimes. Celles-ci ne sont autres que des jeunes filles qu’ils connaissent personnellement. Ces malfrats ont ensuite publié ces images truquées dans des groupes de discussions en ligne. Cela a causé un préjudice psychologique considérable aux victimes. Ce sont les parents d’une de ces dernières qui ont signalé l’incident.

Dans un communiqué de presse qui parle du « préjudice émotionnel et social important » des victimes, la Garde civile a expliqué que « les photographies avaient été modifiées grâce à un logiciel d’intelligence artificielle et diffusées grâce à une application de messagerie instantanée« .

Le danger de l’hypertrucage pornographique

Ces jeunes Espagnols ont exploité les capacités de l’IA pour créer des images d’une qualité telle qu’il était quasiment impossible de les distinguer de photographies authentiques. « Le réalisme des images rendait très difficiles de faire la différence entre celles qui étaient authentiques et celles qui avaient été modifiées« , ajoute la Garde civile.

Par ailleurs, cette affaire n’est pas isolée. Une étude réalisée en 2019 par Sensity, la société néerlandaise, révélait que 96% des fausses vidéos en lignes étaient de la pornographie “non consensuelle”. En plus précis, on utilise des images de femmes, souvent des stars, sans leur consentement. Ces pratiques inquiètent vraiment quant à l’utilisation malveillante de l’IA d’une part et des conséquences sur la vie privée et la réputation des individus d’autre part.

Quelles sont les conséquences d’un tel acte ?

Les victimes de ce harcèlement en ligne ont subi de graves préjudices psychologiques. Les fausses photos nues d’elles ont entaché leur réputation et ont eu un impact important sur leur vie sociale. Cela peut causer des dégâts durables, surtout sur leur santé mentale.

Cette affaire de photos nues devrait donc nous inciter à réfléchir sur les dangers de l’IA et sur la nécessité de réguler son utilisation. C’est vrai que cette technologie offre de nombreuses opportunités, mais sachez que certains peuvent toujours l’utiliser pour des fins malveillantes. Il est donc urgent de mettre en place des garde-fous pour prévenir ces deepfakes.

Et vous, qu’en pensez-vous ? L’IA est-elle une menace pour notre société ? Partagez votre avis en commentaire.

- Partager l'article :

C’est de la pédopornographie. Si cela n’est pas le cas c’est une blague de mauvais goût de la part de petits c**s. Dans tous les cas, cette représentation de nu d’une femme n’est en rien d’autre qu’un phantasme. Encore uen stupidité sociale dont ces fameux réseaux sociaux sont le vecteurs d’un wokisme ridicule . Merci les GAFAM.