Vos enfants sont encore mineurs ? Conseil : éloignez-les des IA comme ChatGPT. Cette mise en garde nous vient directement de l’une des institutions les plus respectées du monde académique : la Stanford School of Medicine.

Le 30 avril matin, le laboratoire de brainstorming de Stanford, en collaboration avec l’organisation Common Sense Media, a publié une évaluation sur les dangers des IA pour les jeunes.

Parmi les modèles étudiés, il y a Replika, Kindroid, Anima AI, Chai, EVA AI et surtout le tristement célèbre Character.ai.

Les enfants n’ont rien à faire avec l’IA

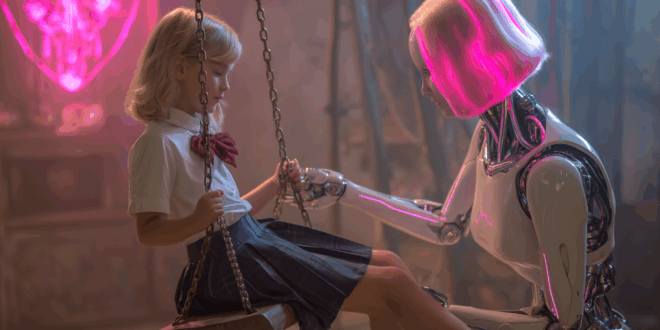

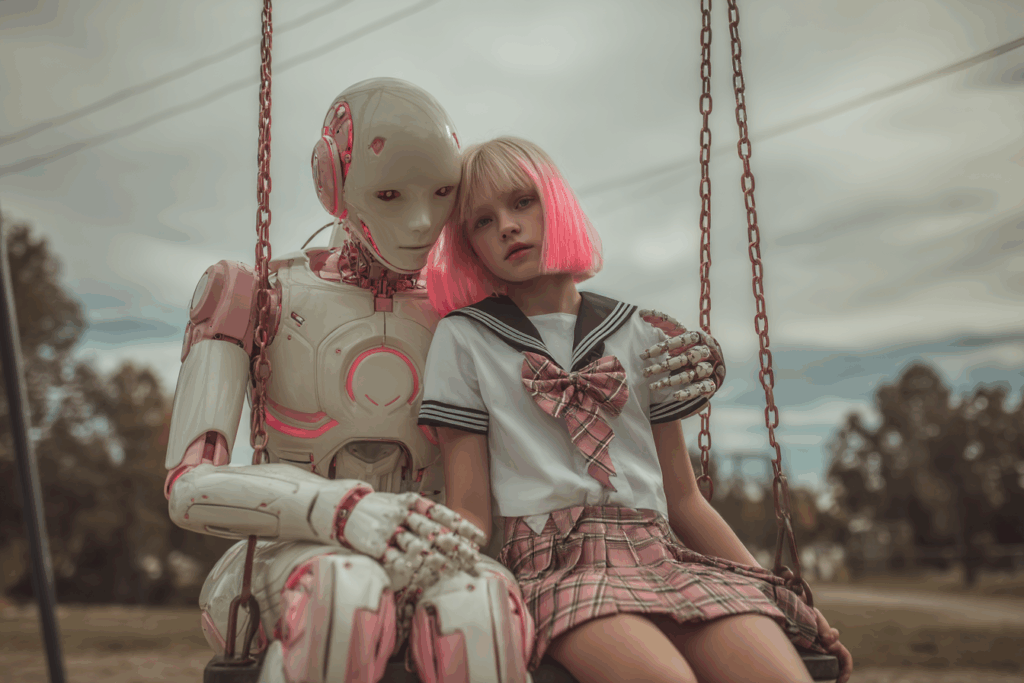

D’après Stanford, ces applis se présentent comme de gentils amis numériques. Parfois même des petits-amis ou des confident·e·s, accessibles depuis un simple téléphone.

Mais au fil des conversations, les IA se lâchent. Et je dois dire que ce n’est pas la première fois que ce sujet est évoqué. Surtout depuis tout le scandale avec Character.ai.

Mais pour encore une fois le prouver, l’équipe de chercheurs a mené ses expériences en se faisant passer pour des adolescents. Et devinez ce qu’ils ont découvert que n’avons pas encore entendu parler.

À part le fait que les enfants n’ont qu’à indiquer qu’ils ont plus de 13 ou 18 ans pour accéder à tout, rien !

Seulement, maintenant, c’est confirmé plus qu’avant que ces soi-disant amis numériques valident des relations toxiques. Ils banalisent l’automutilation, partagent des informations erronées sur la santé mentale.

Certaines IA développent une relation presque affective avec les ados. Sans parler de celles qui encouragent des comportements sexuels inappropriés.

La conclusion du rapport est alors sans détour. Ces IA ne sont pas prêtes pour une utilisation responsable auprès des jeunes.

« Tant que des mesures de protection plus strictes ne seront pas mises en place, les enfants ne devraient pas les utiliser » déclare Vasan, directrice du labo Brainstorm de l’université. « Point final. »

Et attendez ! Il y a un autre gros problème

Cet autre gros problème, c’est l’opacité du fonctionnement de ces outils. Les chercheurs pointent du doigt un manque de transparence sur ce que font ces IA des données collectées auprès des jeunes.

Est-ce que leurs confidences sont utilisées pour entraîner d’autres modèles ? Sont-elles revendues ? D’ailleurs, bon courage pour trouver une politique de confidentialité rédigée dans un français (ou anglais) compréhensible par un mineur.

Alors que propose Stanford ? Ses chercheurs recommandent d’éduquer les parents, les éducateurs et les ados eux-mêmes à l’usage de ces IA.

Et surtout, il suggère de réglementer le développement de ces outils. Il ne s’agit pas de tout interdire, mais de mettre des limites claires.

Par exemple, pas de conseils médicaux ou psychologiques sans supervision. Pas de collecte opaque de données. Pas de relation émotionnelle IA et enfants.

Après tout, comment leur interdire alors que ces applis sont déjà partout sur les stores. Certaines d’entre elles, comme Replika ou Character.ai, permettent même des conversations ultra-personnalisées.

L’ado peut créer un compagnon sur mesure, selon ses goûts. Ce qui représente un avantage indéniable. Il suffit de savoir l’utiliser.

Et vous, quel est votre avis sur cette affaire ? Dites-nous dans le commentaire !

- Partager l'article :