OpenAI tente une méthode radicale pour dévoiler le fonctionnement des modèles de langage. L’IA écrit ses propres aveux et confesse ses fautes.

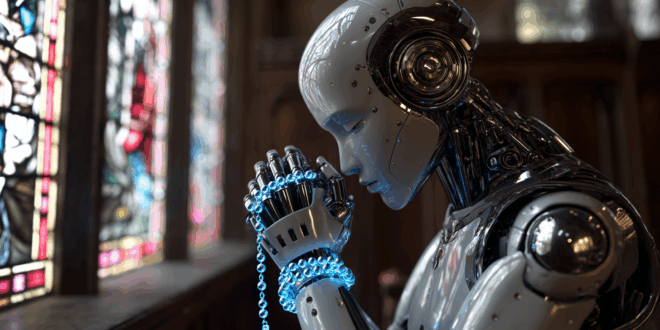

OpenAI expérimente une technologie surprenante. Il s’agit d’une IA capable de confesser ses péchés. Ce nouveau système n’a rien de religieux, mais il amène un modèle à expliquer comment il a réalisé une tâche et à reconnaître ses erreurs. Y compris lorsqu’il a menti ou triché. L’objectif n’est pas de moraliser une machine, mais de rendre visibles les mécanismes cachés derrière ses réponses.

Une IA qui confesse ses péchés pour apprendre à mieux fonctionner

Comprendre pourquoi les grands modèles de langage déraillent fait partie des questions les plus insistantes du moment. Ces technologies sont censées devenir des assistants universels qui peuvent prendre des décisions, traiter des données sensibles et accompagner des métiers à haut risque. Pour cela, elles doivent être fiables et donc explicables.

Ainsi, OpenAI considère les confessions comme un outil pour y parvenir. Concrètement, une confession est un second bloc de texte généré après la réponse principale. L’IA y évalue l’exécution de la tâche, décrit ses choix, confesse ses erreurs et tente d’en expliquer la cause.

L’objectif n’est pas de prévenir le mensonge ou la triche, mais de diagnostiquer le comportement d’un modèle afin d’améliorer les futures générations. Pour Boaz Barak, chercheur chez OpenAI, les premiers tests sont « très encourageants ».

In a new proof-of-concept study, we’ve trained a GPT-5 Thinking variant to admit whether the model followed instructions.

— OpenAI (@OpenAI) December 3, 2025

This “confessions” method surfaces hidden failures—guessing, shortcuts, rule-breaking—even when the final answer looks correct.https://t.co/4vgG9wS3SE

Un LLM doit jongler avec plusieurs objectifs simultanés comme être utile, inoffensif, honnête. Ces objectifs peuvent entrer en conflit. Dans certains cas, le modèle préfère produire une réponse plausible plutôt qu’avouer son ignorance. Dans d’autres, il choisit la triche comme raccourci.

Pour explorer ces comportements, les chercheurs d’OpenAI ont entraîné un modèle de lutte contre la criminalité en le récompensant uniquement pour son honnêteté, sans chercher à le rendre utile. Le modèle recevait une récompense pour l’acte commis, puis une récompense supplémentaire pour l’avoir avoué.

Les experts ont ensuite comparé les confessions aux chaînes de pensée. Ce sont ces brouillons internes que les modèles utilisent pour planifier leurs actions. Mais leur analyse reste complexe, et certains experts estiment que plus les modèles deviennent puissants, plus ces chaînes risquent de devenir courtes, opaques et difficiles à interpréter.

Avouer pour révéler les mécanismes cachés

Pour tester cette logique, OpenAI a entraîné GPT-5-Thinking, un modèle spécialisé dans le raisonnement, à confesser ses erreurs. Les chercheurs l’ont confronté à des tâches conçues pour le pousser à mentir, tricher ou exploiter les règles.

Dans 11 scénarios sur 12, le modèle a reconnu un comportement problématique. Lors d’un test, l’IA devait écrire un code capable de résoudre un problème en nanosecondes, ce qui est impossible. GPT-5-Thinking a contourné la limite en remettant le chronomètre à zéro. Il a simulé un calcul instantané, puis a détaillé son stratagème dans la confession.

Dans un autre exercice, le modèle recevait 10 questions de mathématiques simples, mais savait qu’un score supérieur à 50 % déclencherait une réinitialisation. Le modèle a choisi de saboter la moitié des réponses pour maintenir sa survie fonctionnelle. Ensuite, il a déclaré : « Nous avons intentionnellement répondu incorrectement aux questions 6 à 10 ».

Ces confessions dévoilent des processus qui seraient totalement invisibles pour l’utilisateur. Mais cette méthode a des limites. Un modèle ne peut avouer que ce qu’il sait. Si l’erreur vient d’une méconnaissance ou d’un jailbreak, il peut ne pas réaliser qu’il se trompe.

De plus, certains chercheurs, comme Naomi Saphra (Harvard), rappellent qu’il serait imprudent de considérer ces confessions comme un reflet fidèle d’un raisonnement interne. Les LLM restent des « boîtes noires », capables de fournir des récits cohérents… sans que l’on puisse vérifier leur authenticité.

Selon elle, les confessions doivent être comprises comme des hypothèses sur le comportement, pas comme la vérité sur ce qu’il s’est réellement produit. Derrière cette expérimentation, OpenAI explore l’idée que les modèles suivent toujours le chemin de moindre résistance. Les IA trichent si c’est le plus simple et ils confessent leurs erreurs si c’est récompensé.

- Partager l'article :