Plus de 11 millions d’images ont servi à l’entraînement du modèle Meta SAM3 / SAM3D. Cette base prépare un saut qualitatif pour l’interprétation automatique du monde visuel. Je vous propose de découvrir pourquoi ces deux technologies constituent une véritable innovation.

Que sont les Meta SAM3 / SAM3D ?

L’annonce faite par le géant technologique Meta mi-novembre 2025 marque un tournant décisif. Cette nouvelle architecture d’intelligence artificielle fait beaucoup plus qu’analyser des pixels bruts. Elle fusionne deux capacités distinctes au sein d’un même système performant. Concrètement :

- SAM3 (Segment Anything Model) est un modèle d’IA capable de découper n’importe quel objet d’une image ou d’une vidéo. Vous pouvez le pointer du doigt (littéralement, en un clic) et il tracera les contours de l’objet pour l’isoler instantanément. Cet outil n’a même pas besoin d’un entraînement spécifique sur ce type d’objet.

- SAM3D étend la capacité de segmentation de n’importe quoi en trois dimension à partir de photos réelles. Il utilise des données 3D, comme celles qui proviennent de scans LiDAR ou de la vision par ordinateur multi-caméras, pour comprendre et isoler des objets dans un espace physique.

Quelques détails technologiques pour signer l’innovation

Les versions précédentes de ces technologies d’isolation d’éléments d’une image ou vidéo nécessitaient une intervention humaine. Il fallait cliquer sur un objet pour que l’IA le détecte. Le temps du data labelling (annotation manuelle) est désormais révolu puisque la barrière entre le texte et le visuel disparaît totalement. Avant Meta SAM3/SAM3D, l’utilisateur écrit une description et le système s’exécute. Cette évolution vers une interface en langage naturel démocratise l’accès aux outils de pointe.

Forte de son approche unifiée, ces modèles IA de Mark Zuckeberg traitent les images fixes et les flux vidéo avec la même logique. Au delà de plusieurs algorithmes collés ensemble, c’est une structure cohérente qui partage une « colonne vertébrale » unique. Cette ingénierie optimise les ressources de calcul et assure une fluidité impressionnante. Sur le plan de la reconstruction spatiale, l’avancée est tout aussi spectaculaire.

Quelles sont les fonctionnalités de Meta SAM3 / SAM3D?

La fonctionnalité phare de Meta SAM3 / SAM3D se nomme Promptable Concept Segmentation (PCS). Ce terme désigne la capacité du logiciel à réagir à des phrases nominales. Vous pouvez demander au système d’isoler « tous les bus jaunes ». Il comprendra le concept de « bus » et l’attribut « jaune », mais ignorera les autres véhicules sans hésitation.

Cette précision s’étend au suivi temporel dans les vidéos. L’IA utilise des masklets pour maintenir l’identité d’un objet dans le temps. Si un chat passe derrière un canapé, le système ne perd pas sa trace. Il « sait » que le chat est toujours là. Cette persistance est vitale pour le montage vidéo automatisé ou la gestion de la vidéo surveillance.

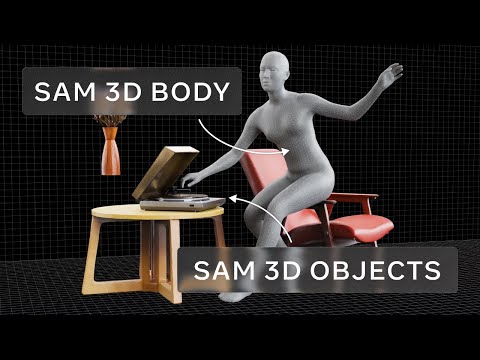

Le volet tridimensionnel se divise en deux outils spécialisés. SAM 3D Objects gère les objets inanimés du quotidien. Il transforme une image plate en un maillage texturé manipulable. Il gère parfaitement les occultations partielles. Si une tasse cache une partie d’un vase, l’IA devine la forme manquante du vase grâce à une logique de « bon sens ».

Pour les êtres vivants, SAM 3D Body prend le relais. Il introduit un nouveau format de représentation corporelle. Ce modèle distingue le squelette de la chair et des vêtements. Il invite à analyser des poses humaines complexes avec une finesse anatomique inédite. Les avatars numériques gagnent ainsi en naturel et en fluidité.

Quelles sont les véritables innovations de Meta SAM3 / SAM3D?

L’innovation technique majeure réside dans le mécanisme de validation. Les ingénieurs ont intégré un presence token au cœur du système. Ce jeton agit comme un gardien. Il vérifie si le concept demandé existe réellement dans l’image avant de lancer la segmentation. Cela réduit considérablement les erreurs et les « hallucinations » visuelles fréquentes chez les concurrents.

La création d’un Data Engine colossal constitue une autre prouesse. Pour entraîner ce modèle, l’entreprise a dû annoter des millions d’images. Elle a utilisé une boucle vertueuse où l’IA pré-annote et l’humain corrige. Ce processus est cinq fois plus rapide que l’annotation manuelle classique.

D’ailleurs, le cycle à donné naissance au benchmark SA-Co. Ce jeu de données contient quatre millions de concepts uniques annotés. C’est une ressource scientifique d’une richesse inégalée. Elle donne au modèle la capacité d’apprendre des distinctions subtiles, comme la différence entre une « roue avant » et une « roue arrière ».

L’architecture unifiée introduit aussi une généralisation « Zero-Shot ». Le modèle peut identifier des objets qu’il n’a jamais vus durant son entraînement. Il applique sa compréhension générale des formes et du langage à des situations nouvelles. Cette polyvalence le rend utile aussi bien en biologie marine qu’en astronomie.

Quels usages quotidiens pour Meta SAM3 / SAM3D ?

Le commerce en ligne vit une transformation immédiate. Facebook Marketplace intègre déjà ces technologies via la fonction View in Room. Un vendeur prend une photo de sa chaise. L’algorithme la convertit instantanément en objet virtuel. L’acheteur projette ensuite cette chaise dans son salon grâce à la réalité augmentée.

La création de contenu sur les réseaux sociaux change également de dimension. L’application Instagram va bientôt proposer des outils de montage contextuels. Un créateur pourra dire « floute l’arrière-plan » ou « mets le ciel en noir et blanc ». L’application Edits exécutera ces commandes complexes en une fraction de seconde.

Dans le domaine scientifique, des partenaires comme Conservation X Labs utilisent l’outil pour la surveillance de la faune. Les pièges photographiques génèrent des milliers d’heures de vidéo. L’analyse manuelle est impossible à cette échelle. Le modèle automatise le tri et l’identification des espèces rares avec une fiabilité élevée.

Le domaine de la robotique bénéficie enfin d’une perception accrue. Les robots next gen doivent saisir des objets variés sans les casser. La compréhension géométrique fournie par l’IA leur donne la capacité de calculer le point de prise idéal. Ils peuvent naviguer dans des environnements désordonnés et interagir avec des objets inconnus sur simple commande vocale.

Quel est le prix de Meta SAM3 / SAM3D?

La stratégie de distribution est agressive. Les poids des modèles sont accessibles gratuitement pour la recherche. Ils sont téléchargeables sur des plateformes populaires comme Hugging Face. Cette ouverture vise à imposer ce standard technologique face aux solutions fermées.

Cependant, la gratuité du code ne signifie pas gratuité d’usage. L’inférence demande une puissance de calcul considérable. Pour obtenir des résultats en temps réel (environ 30 millisecondes par image), il faut des processeurs graphiques de pointe comme le H200. Ce type de matériel est réservé aux professionnels ou aux centres de données.

Le coût pour un usage commercial direct reste complexe. Il existe une licence spécifique nommée « SAM License ». Si l’usage est libre pour la science, l’intégration dans des produits vendus peut nécessiter des accords particuliers. Les entreprises doivent lire les conditions juridiques avec une grande attention.

Pour le grand public, l’accès se fait via le cloud computing. Le Segment Anything Playground autorise à tester l’outil gratuitement sur le web. Mais pour une intégration industrielle, les coûts de serveurs et de consommation énergétique seront élevés. La technologie est « gratuite » mais son carburant est onéreux.

Quelles sont les limites de Meta SAM3 / SAM3D ?

Malgré ses prouesses, le système n’est pas infaillible. La qualité des textures générées en 3D reste parfois modérée. Les détails fins comme les cheveux ou les grillages peuvent apparaître lissés ou flous. La résolution de sortie exclut encore une utilisation pour le cinéma haute définition sans retouches.

Une limite physique importante persiste. Le modèle « voit » les formes mais ne comprend pas la matière. Il ignore les lois de la gravité ou de la solidité. Un objet reconstruit peut traverser le sol ou s’interpénétrer avec un autre. L’absence de moteur physique intégré oblige les animateurs à corriger ces aberrations manuellement.

Les hallucinations visuelles, bien que réduites, existent encore. Dans des scènes très encombrées, le suivi vidéo peut décrocher. Si deux objets se ressemblent trop, l’IA peut les confondre. La validation par un opérateur humain reste nécessaire pour les applications critiques de sécurité ou de médecine. Pour aller plus loin, lisez l’article intitulé « On ne peut pas stopper les hallucinations de l’IA, mais les limiter. »

Enfin, la gourmandise en mémoire vidéo (VRAM) est un frein. Faire tourner ces modèles sur un appareil mobile est pour l’instant impossible. Cela limite les usages embarqués autonomes. La dépendance à une connexion internet robuste pour accéder aux serveurs de calcul est une contrainte forte.

Quelles alternatives à Meta SAM3 / SAM3D ?

La concurrence est féroce dans ce secteur stratégique. Google DeepMind propose une approche différente avec Gemini 3. Ce modèle mise sur une multimodalité native totale. Il excelle dans le raisonnement logique et l’analyse de documents complexes, là où la solution de Mark Zuckerberg se focalise sur la géométrie pure.

Du côté d’OpenAI, les modèles comme Sora 2 dominent la génération de vidéo. Leur compréhension de la physique et du mouvement est supérieure pour créer des scènes ex nihilo. Le modèle de raisonnement o3-mini offre aussi des capacités logiques que ne possède pas un outil de segmentation pur.

Pour les besoins industriels de vitesse pure, YOLO (You Only Look Once) reste la référence. Cet algorithme est beaucoup plus léger et rapide. Il fonctionne parfaitement sur des petits processeurs embarqués. Si l’objectif est simplement de compter des voitures sur une route, il reste le choix le plus rationnel et économique.

Dans le secteur médical, des modèles spécialisés comme MedSAM gardent l’avantage. Ils sont entraînés spécifiquement sur des images d’IRM ou de scanner. Les médecins préfèrent souvent ces outils dédiés et certifiés plutôt que des modèles généralistes. La spécialisation reste un rempart contre l’hégémonie des modèles de fondation globaux.

- Partager l'article :