Une IA open source vient de surpasser GPT-4o, Claude 3.5 Sonnet et même Llama 3.1 405B. Et elle s’appelle DeepSeek v3. Ainsi, avec ses performances impressionnantes et son accessibilité, cette nouvelle référence redéfinit ce qu’un modèle open source peut accomplir. Prêt à en savoir plus ?

Si vous suivez l’univers des modèles de langage (LLM), vous savez à quel point des géants comme GPT-4o ou Claude 3.5 dominent le marché. Mais en cette fin d’année 2024, DeepSeek v3 arrive. Développé par la société chinoise DeepSeek, ce modèle se présente donc comme un rival de tailles pour les meilleurs. Et il les surpasse même. Avec ses 685 milliards de paramètres, DeepSeek v3 s’impose comme l’un des plus grands modèles open source jamais créés.

DeepSeek v3 vient détrôner les géants du secteur

2024 touche à sa fin, et voilà qu’un nouveau venu débarque dans le monde de l’intelligence artificielle. Il s’agit donc de DeepSeek v3, un modèle développé par la société chinoise DeepSeek. Apparemment, celui-ci surpasse les grands noms comme GPT-4o, Claude 3.5 Sonnet et Qwen 2.5 Coder.

?ref_src=twsrc%5Etfw">December 26, 2024🚀 Introducing DeepSeek-V3!

— DeepSeek (@deepseek_ai)

Biggest leap forward yet:

⚡ 60 tokens/second (3x faster than V2!)

💪 Enhanced capabilities

🛠 API compatibility intact

🌍 Fully open-source models & papers

🐋 1/n pic.twitter.com/p1dV9gJ2Sd

Ce que je trouve le plus impressionnant, ce sont ces 685 milliards de paramètres. Avec cette puissance, DeepSeek v3 peut ainsi générer des textes d’une précision et d’une fluidité qui donnent l’impression de parler à un humain.

Par ailleurs, DeepSeek v3 est aussi rapide qu’un éclair. Ce modèle est capable de traiter 60 jetons par seconde, trois fois plus vite que son prédécesseur. Et surtout, il se distingue également par son rapport qualité/prix exceptionnel.

En termes de performance pure, DeepSeek v3 rivalise avec les meilleurs modèles fermés tout en étant open source. Et c’est ce qui le rend abordable et accessible à tous.

Ainsi, vous pouvez télécharger le modèle directement sur HuggingFace ou même discuter avec lui gratuitement via leur chat officiel.

Des performances de haut niveau sur tous les fronts

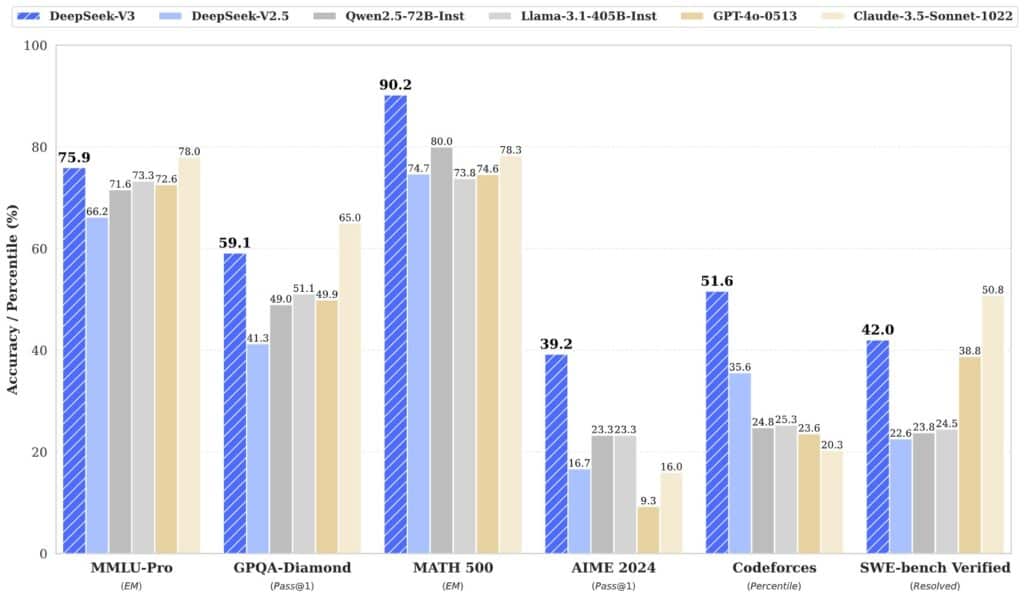

DeepSeek v3 excelle dans presque tous les domaines. Sur les tests de compréhension des connaissances (MMLU), le modèle a atteint 75,9 %, talonnant GPT-4. En mathématiques avancées, il décroche 90,2 %, surpassant largement les autres modèles.

Pour la programmation, il brille avec un score de 51,6 % sur Codeforces, éclipsant des IA comme GPT-4. Et ce n’est pas tout ! DeepSeek v3 domine aussi sur des tâches d’apprentissage complexe comme le GPQA-Diamond avec 59,1 %, battant quasiment tout le monde, sauf Claude.

Et je ne vous ai pas parlé de ces innovations architecturales. DeepSeek v3 utilise des approches comme le Multi-head Latent Attention (MLA) et le DeepSeekMoE. Ces derniers améliorent à la fois son efficacité et sa flexibilité.

En plus, ce modèle a été pré-entraîné sur une grande quantité de 14,8 trillions de jetons. Ce qui garantit donc une richesse et une diversité dans ses réponses.

Et vous ? Qu’en pensez-vous ? DeepSeek v3 vous semble-t-il prêt à détrôner les géants comme GPT-4o ? Dites-nous tout dans les commentaires !

- Partager l'article :