On parle énormément du Machine Learning et du Deep Learning, permettant aux machines d’apprendre. Mais comment entraîner une intelligence artificielle ? Comment fonctionne réellement cette technologie révolutionnaire ? Découvrez comment procéder à travers ce guide complet.

L’intelligence artificielle offre des possibilités illimitées. Cependant, tout comme l’intelligence humaine, l’IA a d’abord besoin d’apprendre pour se développer et réaliser son plein potentiel.

Au préalable, il est donc nécessaire » d’entraîner » une IA. Pour ce faire, il convient de la » nourrir » à l’aide de larges volumes de données. Cette phase d’apprentissage est ce qu’on appelle le Machine Learning ou le Deep Learning.

Ces deux techniques vont permettre à l’IA de réunir des insights à partir des données, afin d’apprendre à effectuer une tâche de manière autonome. En apprenant à analyser les données et à effectuer des prédictions, les machines se rapprochent de la manière de penser des humains.

Pour poursuivre l’analogie avec l’intelligence humaine, un enfant qui vient de naître apprend de ses propres expériences, mais aussi de celles de tous les humains qui l’ont précédé, par le biais des livres ou d’internet.

Dans le cas d’une machine, les expériences passées sont des ensembles de données constitués d’exemples existants correspondant à la tâche à apprendre. Par exemple, pour apprendre à reconnaître les différentes races de chiens, un algorithme pourra s’entraîner sur des photos de chiens.

La durée de cet entraînement varie en fonction de nombreux facteurs. Elle dépend notamment du hardware, de l’optimisation, du nombre de couches du réseau de neurones, de la taille de l’ensemble de données utilisé et bien plus encore.

Quelle est la différence entre Machine Learning et Deep Learning

On distingue deux techniques principales d’entraînement de l’intelligence artificielle. Le premier, et le plus populaire à l’heure actuelle, est le Machine Learning.

Cette sous-catégorie d’intelligence artificielle consiste à permettre aux ordinateurs d’apprendre de manière autonome et de s’améliorer sans avoir besoin d’être programmés par un humain.

Grâce à des algorithmes, l’IA découvre des patterns dans les données et se modifie à mesure qu’elle ingère de nouvelles données. Elle s’ajuste à partir des informations reçues, à la manière dont un enfant apprend à partir de ses expériences.

Le Deep Learning peut être défini comme une approche plus spécialisée du Machine Learning. Elle utilise les réseaux de neurones artificiels pour imiter la manière dont le cerveau humain traite les données.

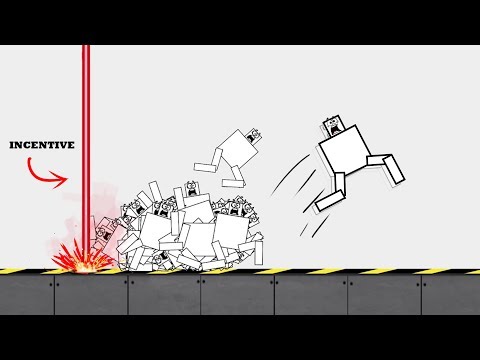

L’ordinateur apprend à travers le » renforcement » positif ou négatif. La machine tente d’effectuer une tâche, et reçoit des retours positifs ou négatifs en fonction du résultat pour lui permettre de s’améliorer peu à peu.

Le Deep Learning repose sur de multiples couches de réseaux de neurones, et chaque neurone du réseau est constitué d’une fonction mathématique nourrie de données pour être transformée et analysée comme un résultat.

L’ordinateur apprend à mesurer l’importance de chaque lien entre les neurones pour créer des prédictions à succès. Le Deep Learning excelle particulièrement pour résoudre des problèmes complexes avec différentes variables.

Qu’est-ce que les données d’entraînement ?

Les données d’entraînement sont celles qui permettront à votre IA d’apprendre à effectuer la tâche qui lui est confiée. Elles seront utilisées encore et encore afin d’améliorer ses prédictions et son taux de réussite.

L’IA utilisera ces données d’entraînement de plusieurs façons dans le but d’améliorer la précision de ses prédictions. En identifiant les variables contenues dans ces données, et en évaluant leur impact sur l’algorithme, les Data Scientists peuvent améliorer leur IA via divers ajustements.

Dans l’idéal, les données doivent donc être riches en détails et capables d’améliorer l’IA après plusieurs centaines de cycles d’entraînement. Elles doivent contenir une large variété de variables affectant l’algorithme.

La plupart des données d’entraînement contiennent des paires input / étiquette. Dans certains domaines, les étiquettes seront détaillées pour aider l’IA à faire des prédictions plus précises. Cependant, en fonction de la tâche pour laquelle l’IA est conçue, les ensembles de données seront généralement très différents.

Dans le domaine de l’analyse de sentiment, les données d’entraînement input seront généralement composées de phrases, d’avis ou de tweets. L’étiquette quant à elle indiquera si le texte est positif ou négatif.

Pour la reconnaissance d’image, l’input est une image. L’étiquette quant à elle indiquera le contenu de l’image.

Si la tâche est la détection de spam, l’input est un email ou un message textuel. L’étiquette indique si le message est un spam ou non.

Enfin, pour la catégorisation de texte, les phrases servent d’input. L’étiquette indiquera le sujet de la phrase.

Il ne s’agit-là que d’exemples basiques. Notons aussi qu’une seule input peut avoir plusieurs étiquettes. Les données sont donc essentielles pour l’entraînement d’une IA, et c’est la raison pour laquelle elles doivent être soigneusement préparées.

Où trouver des données d’entraînement ?

Vous l’aurez compris : pour entraîner votre IA, vous aurez besoin de données. Malheureusement, il peut être très difficile de trouver des données d’entraînement.

Bien souvent, les ensembles de données sont créés pour un usage général ou au contraire pour l’entraînement d’un seul modèle spécifique. Dans les deux cas, ces datasets ne répondront généralement pas à vos besoins.

Vous devrez donc faire l’effort de trouver des données pertinentes et de les étiqueter avec précision. C’est un labeur d’envergure, mais il vous permettra de gagner un temps précieux pour la suite des opérations.

Il existe plusieurs sources principales pour trouver des données d’entraînement. Tout d’abord, vous pouvez vous tourner vers des sources publiques.

En effet, la communauté du Machine Learning a créé plusieurs répertoires de données pouvant correspondre à ce que vous recherchez. On peut notamment citer la plateforme Kaggle. Ces données sont à disposition de tous, et vous pouvez les ajouter à votre dataset d’entraînement.

Cependant, gardez en tête que ces répertoires ne sont pas conçus spécifiquement pour votre projet. Les données ne seront donc pas toujours pertinentes, et vous devrez donc effectuer un travail de sélection. De plus, leur qualité peut laisser à désirer et vous devrez donc réaliser un Data Cleansing avant de les utiliser.

Une alternative est celle du Crowdsourcing. De nombreux sites vous permettent d’acquérir d’importants volumes de données, customisées pour vos besoins, pour un prix abordable.

Si vous choisissez cette option, veillez toutefois à bien communiquer minutieusement vos besoins aux » crowd workers » qui se chargeront de collecter et d’agréger les données. Prenez soin de leur expliquer quels sont les éléments requis, et tenez compte du fait qu’il ne s’agit pas d’experts et qu’ils ne savent pas forcément ce que sont des données d’entraînement pertinentes.

Si vous êtes prêt à réaliser ce travail de briefing et de supervision, alors le crowdsourcing peut être un excellent outil pour constituer un dataset de haute qualité pour votre projet.

La dernière option la plus populaire est celle des fournisseurs de données d’entraînement. Il s’agit là de plateformes spécialisées, employant de nombreux travailleurs pour créer et annoter des données d’entraînement.

Ces fournisseurs spécialisés disposent d’une expertise supérieure à celles des plateformes de crowdsourcing, et sont habitués à respecter des conditions et des exigences. Ils pourront donc s’adapter à vos besoins pour vous fournir des données personnalisées. Cette solution peut s’avérer onéreuse, mais il s’agit d’un très bon choix pour débuter votre projet ou pour étoffer un dataset existant.

Quelle que soit la source que vous choisissez, assurez-vous qu’elle puisse garantir à la fois un haut niveau de qualité et une flexibilité suffisante pour prendre en compte vos besoins. Ceci permettra d’être sûr que vos données d’entraînement soient prêtes à l’usage, et suffisamment pertinentes pour entraîner votre modèle.

Tout au long du processus, prenez le temps d’examiner les résultats et de modifier le dataset pour l’améliorer progressivement. Gardez en tête que les données sont le carburant du Machine Learning. Si vous avez la chance de trouver un bon fournisseur de données, vous pourrez revenir vers lui pour vos futurs modèles.

Avant l’entraînement : la préparation des données

Avant de se lancer dans l’entraînement d’une intelligence artificielle, il est nécessaire de prendre plusieurs précautions.

Il est d’abord nécessaire de s’assurer que les données utilisées pour nourrir l’IA soient de très haute qualité. Elles doivent être nettoyées et organisées afin de lancer le processus de Machine Learning.

Il ne doit pas y avoir de duplicatas ou d’échantillons non pertinents. Pour cause, une structure désorganisée pourrait totalement gâcher le projet. Il est donc crucial d’examiner attentivement les données.

Les données doivent être soigneusement étiquetées, afin que l’IA puisse apprendre plus rapidement et correctement. Une fois prêtes les données doivent être assignées de façon aléatoire dans trois catégories : entraînement, validation et testing.

Cette assignation aléatoire permet d’éviter les biais liés à une sélection manuelle, qui pourrait avoir un impact négatif sur le processus d’entraînement. Le Machine Learning peut maintenant commencer…

Qu’est-ce que le Data Labeling ?

Pour apprendre en apprentissage supervisé, les algorithmes de Machine Learning ont besoin de données » étiquetées « . Le processus d’étiquetage des données est appelé en anglais » Data labeling « .

Il consiste à préparer des ensembles de données étiquetées sur lesquels les algorithmes pourront s’entraîner. Après s’être suffisamment entraînée à repérer les patterns sur les données étiquetées, une IA pourra reconnaître ces mêmes patterns sur des données non étiquetées. Elle sera donc prête pour une application dans le monde réel.

Les données choisies avant l’étiquetage doivent correspondre aux besoins de l’entreprise, puis être étiquetées avec précision. Il est possible d’effectuer ce travail en interne par des employés, avec des logiciels dédiés.

Une alternative consiste à externaliser le travail partiellement ou entièrement via le Cloud. Il existe aussi des entreprises spécialisées, ou des plateformes de crowdsourcing.

L’annotation des données est l’une des étapes cruciales du Machine Learning, et de nombreuses startups spécialisées voient le jour dans ce domaine. Selon Grand View Research, cette industrie devrait représenter 1,6 milliard de dollars en 2025 avec un taux de croissance de 26,6% par an.

Pourquoi la qualité des données est importante ?

Si les données ne sont pas étiquetées de manière assez précise, le modèle risque d’apprendre de manière incorrecte. L’algorithme n’apprendra pas correctement et ses performances seront directement impactées.

Chaque étiquette dans l’ensemble de données est importante, et c’est la qualité de cet étiquetage qui fait la différence entre une IA performante et une IA médiocre. Il existe des plateformes de crowdsourcing permettant d’étiqueter les données plus rapidement en externalisant partiellement la tâche…

Les 3 étapes de l’entraînement de l’IA

Le processus d’entraînement d’une IA peut être décomposé en trois étapes : l’entraînement, la validation, et le testing.

L’entraînement

En nourrissant l’ordinateur de données, il est entraîné à produire une prédiction particulière à chaque cycle. Des variables aléatoires sont utilisées.

Ainsi, les prédictions se font de plus en plus précises à chaque étape. Au départ, elles seront de piètre qualité puisque l’intelligence artificielle n’a quasiment aucune idée de la façon dont les variables sont liées au résultat ciblé.

À chaque prédiction, les paramètres peuvent être ajustés pour gagner en précision. Il est possible d’ajuster les paramètres des variables de manière à aider l’IA à s’améliorer.

Les données d’entraînement sont exécutées encore et encore, et le modèle s’améliore peu à peu. Chacun de ces cycles est une étape d’entraînement.

La validation

Vient ensuite l’étape de la validation. Des données de validation sont exécutées pour vérifier les performances du modèle entraîné. De nouvelles variables peuvent avoir besoin d’être ajustées pour améliorer l’algorithme à ce stade.

On utilise les données de validation. En toute logique, l’algorithme devrait se révéler plus performant à ce stade que lorsqu’il a rencontré les données d’entraînement pour la première fois. Cependant, les performances ne sont pas garanties à ce stade.

Les résultats sont passés en revue. Il est possible de s’apercevoir que le modèle a été entraînement un peu trop spécifiquement et reconnaît uniquement les exemples de ses données d’entraînement. De même, il est possible de découvrir de nouvelles variables qu’il faudra ajuster.

La phase d’entraînement est alors répétée avec ces nouvelles variables. L’algorithme s’en trouve ajusté et amélioré. Certains hyperparamètres peuvent aussi être ajustés pour peaufiner le modèle. Cependant, si le modèle s’avère d’ores et déjà parfaitement efficace, il est possible de passer à l’étape de testing.

Le testing

Une fois l’étape de la validation passée, le système peut être à nouveau testé à l’aide de données du monde réel qui n’ont pas encore d’étiquettes. C’est à ce stade que l’on vérifie si l’algorithme est véritablement prêt à être utilisé pour la tâche prévue.

En effet, c’est à ce type de données non étiquetées que l’algorithme aura à faire. Si ses performances sont à la hauteur, il sera donc prêt à être utilisé. Dans le cas contraire, il sera nécessaire de reprendre l’entraînement.

Comment accélérer le Machine Learning ?

La création d’un modèle de Deep Learning en partant de zéro peut nécessiter plusieurs jours voire plusieurs semaines. L’entraînement est long, car un grand volume de données doit être ingéré et que l’apprentissage prend du temps.

Il existe cependant des solutions pour accélérer le processus. Beaucoup d’applications utilisent ce qu’on appelle le » transfer learning « . Des ajustements sont effectués en utilisant un modèle pré-entraîné.

En modifiant un réseau existant, de nouvelles données peuvent être ajoutées et de nouvelles tâches peuvent lui être confiées. Le volume de données est largement réduit, et le temps d’entraînement peut tomber à quelques heures voire quelques minutes seulement.

Une autre méthode est celle de l’extraction. Il s’agit d’extraire une couche d’un réseau de neurones chargé d’apprendre une certaine caractéristique et de l’utiliser pour compléter un autre modèle de Machine Learning.

Hardware, logiciels et compétences nécessaires

L’entraînement d’une IA peut prendre du temps. Cependant, ce n’est pas la seule contrainte.

Pour entraîner une IA, vous aurez impérativement besoin de données. Un ensemble de données propre et étiqueté avec précision vous sera d’un grand secours. En nourrissant l’algorithme à l’aide de données de qualité, l’entraînement sera simplifié et les performances accrues.

Vous aurez aussi besoin d’une grande puissance de calcul. Il est généralement nécessaire de combiner des GPU dernier cri avec des clusters ou des capacités Cloud pour réduire le temps d’entraînement du Deep Learning. Il est possible d’effectuer l’entraînement de façon parallèle en utilisant plusieurs GPU.

Des équipements haut de gamme comme le GPU Nvidia Tesla V100 à plus de 10 000 dollars ou le serveur DGX1 à plus de 140 000 dollars sont à privilégier pour cette tâche extrêmement exigeante. Cependant, vous pouvez aussi louer du hardware via le Cloud.

Si vous décidez de vous tourner vers le nuage, sachez que chaque fournisseur Cloud a son propre logiciel de Machine Learning automatisé. On retrouve par exemple le Machine Learning Studio sur Microsoft Azure, le Cloud AutoML sur Google Cloud, ou AWS SageMaker sur Amazon Web Services. D’autres logiciels comme Google TensorFlow ou Pytorch peuvent permettre de créer des modèles d’entraînement.

Pour finir, vous aurez aussi besoin de développeurs spécialisés. Or, il existe une réelle pénurie de tels experts à l’échelle mondiale. On estime le nombre de développeurs spécialisés en IA à moins de 10 000 à l’heure actuelle.

Les spécialistes peuvent être payés entre 300 000 et 500 000 dollars par an. Les meilleurs chercheurs académiques sont directement recrutés par les GAFAM. Un développeur IA doit être diplômé en informatique et maîtriser la programmation C++, les sciences physiques et le STL.

De quel volume de données avez-vous besoin ?

La taille de l’ensemble de données dont vous avez besoin dépend de nombreux facteurs. Vous devez d’abord prendre en compte la complexité du modèle d’intelligence artificielle que vous cherchez à entraîner.

Plus la tâche pour laquelle l’IA est conçue est complexe, plus le nombre de paramètres qu’elle doit considérer augmente. Un modèle avec une tâche simple et clairement définie aura donc besoin de moins de données qu’un modèle auquel on confie des tâches plus complexes et abstraites.

Le volume de données requis dépend aussi de la méthode d’entraînement utilisée. La méthode du Deep Learning nécessite beaucoup plus de données que celle de l’apprentissage structuré, et la courbe d’apprentissage est plus longue.

Enfin, en fonction du projet, les données n’ont pas les mêmes besoins en étiquettes. Si chaque donnée peut recevoir plusieurs labels, alors moins de données seront requises.

Dans la plupart des cas, le plus simple est de commencer avec les données que vous avez à disposition. Par la suite, lorsqu’il devient évident que vous avez besoin de plus de données, vous pouvez en ajouter.

Blockchain et entraînement IA

La technologie Blockchain se révèle d’un précieux secours pour l’entraînement de l’IA. Elle peut permettre de faciliter l’acquisition de larges ensembles de données.

De nouvelles startups combinent l’IA et la Blockchain pour décentraliser la propriété des données. De cette manière, les données deviennent accessibles au plus grand nombre à des fins de collaboration ou d’extension.

En guise d’exemple, on peut notamment citer les startups Datum, Synapse et Computable. Ces dernières développent de nouvelles marketplaces de données au sein desquelles les participants reçoivent des » tokens » en échange des données qu’ils partagent.

De même, la startup Numerai permet aux Data Scientists de proposer des modèles pour résoudre les problèmes de Machine Learning. En échange, ils reçoivent des » tokens » NMR.

Le Blockchain offre de nombreux avantages pour l’IA, et permet notamment de la décentraliser pour qu’elle reste autonome et indépendante. Cette technologie peut donc jouer un rôle majeur pour l’entrainement de l’IA.

Les startups qui révolutionnent l’entraînement de l’IA

Le Machine Learning et l’intelligence artificielle sont des technologies émergentes, et il n’est donc pas surprenant que de nombreuses innovations disruptives émergent au fil du temps. Une large variété de startups voient le jour avec pour objectif de faciliter, d’accélérer ou de transformer radicalement l’entraînement des IA.

C’est par exemple le cas de DefinedCrowd, qui a récemment levé 50,5 millions de dollars. Cette startup s’est donné pour but de fournir les données permettant la création d’IA spécialisées dans le traitement naturel du langage, la vision par ordinateur ou la reconnaissance de sentiment.

L’entreprise crée et trie des données, grâce à une véritable armée chargée d’effectuer ce labeur d’envergure. Elle permet ainsi aux firmes cherchant à entraîner leurs algorithmes d’accéder à des données de haute qualité dans de multiples langages et de se concentrer sur la création de leurs applications.

De même, AI Reverie développe une plateforme de simulation permettant d’entraîner les IA à mieux comprendre le monde vis un ensemble d’APIs de vision et d’information synthétique. Les entreprises peuvent exploiter ces ressources pour entraîner leurs algorithmes. Cette startup a levé 10 millions de dollars en deux tours.

Facebook entraîne son IA sur les vidéos de ses utilisateurs

Apprendre aux IA à comprendre les vidéos est à la fois l’un des plus grands défis du Machine Learning, et l’une des plus grandes promesses. Pour y parvenir, Facebook va entraîner son intelligence artificielle sur les vidéos partagées publiquement sur son réseau social.

Grâce aux millions de vidéos publiées par les utilisateurs de la plateforme, Facebook profite d’un avantage majeur. Auparavant, la firme avait déjà entraîné son modèle de Computer Vision sur des milliards d’images en provenance d’Instagram.

Ces nombreuses vidéos proviennent de tous les pays du monde, et couvrent des centaines de langages différents. Entraînée sur un tel contenu, l’IA pourra gagner en précision et » reconnaître les différences et les nuances entre les cultures et les régions du monde « .

Les modèles ainsi entraînés seront utilisés pour créer de nouveaux systèmes de recommandation de contenu et des outils de modération. Par la suite, Facebook pourrait même utiliser l’analyse de vidéo pour mieux comprendre les centres d’intérêt et les habitudes de ses utilisateurs.

Sur son blog, Facebook envisage même d’utiliser l’IA pour restaurer des » souvenirs numériques « capturés par les lunettes connectées qu’elle prévoit de commercialiser en 2021. Ces lunettes seront équipées de caméra. Si l’intelligence artificielle peut comprendre le contenu des vidéos, l’utilisateur pourra explorer ses souvenirs.

Pour mener à bien ce projet, Facebook compte sur le » self-supervised learning « : une technique consistant à laisser l’intelligence artificielle apprendre via les données d’entraînement sans toutefois les étiqueter.

L’IA apprendra à analyser les vidéos grâce à des méthodes de » self-supervised learning » et de » semi-supervised learning « . Des techniques déjà couramment employées pour les systèmes de Computer Vision et de reconnaissance de discours de la firme américaine…

- Partager l'article :