Le Machine Learning est une technologie d'intelligence artificielle permettant aux ordinateurs d'apprendre sans avoir été programmés explicitement à cet effet. Pour apprendre et se développer, les ordinateurs ont toutefois besoin de données à analyser et sur lesquelles s'entraîner. De fait, le Big Data est l'essence du Machine Learning, et c'est la technologie qui permet d'exploiter pleinement le potentiel du Big Data. Découvrez pourquoi cette technique et le Big Data sont interdépendants.

Apprentissage automatique définition : qu'est ce que le Machine Learning ?

Si le Machine Learning ne date pas d'hier, sa définition précise demeure encore confuse pour de nombreuses personnes. Concrètement, il s'agit d'une science moderne permettant de découvrir des patterns et d'effectuer des prédictions à partir de données en se basant sur des statistiques, sur du forage de données, sur la reconnaissances de patterns et sur les analyses prédictives. Les premiers algorithmes sont créés à la fin des années 1950. Le plus connu d'entre eux n'est autre que le Perceptron.

Le Machine Learning est très efficace dans les situations où les insights doivent être découvertes à partir de larges ensembles de données diverses et changeantes, c'est à dire : le Big Data. Pour l'analyse de telles données, il se révèle nettement plus efficace que les méthodes traditionnelles en termes de précision et de vitesse. Par exemple, pour en se basant sur les informations associées à une transaction comme le montant et la localisation, et sur les données historiques et sociales, le Machine Learning permet de détecter une fraude potentielle en une milliseconde. Ainsi, cette méthode est nettement plus efficace que les méthodes traditionnelles pour l'analyse de données transactionnelles, de données issues des réseaux sociaux ou de plateformes CRM.

Le Machine Learning peut être défini comme une branche de l'intelligence artificielle englobant de nombreuses méthodes permettant de créer automatiquement des modèles à partir des données. Ces méthodes sont en fait des algorithmes.

Un programme informatique traditionnel effectue une tâche en suivant des instructions précises, et donc systématiquement de la même façon. Au contraire, un système Machine Learning ne suit pas d'instructions, mais apprend à partir de l'expérience. Par conséquent, ses performances s'améliorent au fil de son » entraînement » à mesure que l'algorithme est exposé à davantage de données.

Les différents types d'algorithmes de Machine Learning

On distingue différents types d'algorithmes Machine Learning. Généralement, ils peuvent être répartis en deux catégories : supervisés et non supervisés.

Dans le cas de l'apprentissage supervisé, les données utilisées pour l'entraînement sont déjà » étiquetées « . Par conséquent, le modèle de Machine Learning sait déjà ce qu'elle doit chercher (motif, élément…) dans ces données. À la fin de l'apprentissage, le modèle ainsi entraîné sera capable de retrouver les mêmes éléments sur des données non étiquetées.

Parmi les algorithmes supervisés, on distingue les algorithmes de classification (prédictions non-numériques) et les algorithmes de régression (prédictions numérique). En fonction du problème à résoudre, on utilisera l'un de ces deux archétypes.

L'apprentissage non supervisé, au contraire, consiste à entraîner le modèle sur des données sans étiquettes. La machine parcourt les données sans aucun indice, et tente d'y découvrir des motifs ou des tendances récurrents. Cette approche est couramment utilisée dans certains domaines, comme la cybersécurité.

Parmi les modèles non-supervisés, on distingue les algorithmes de clustering (pour trouver des groupes d'objets similaires), d'association (pour trouver des liens entre des objets) et de réduction dimensionnelle (pour choisir ou extraire des caractéristiques).

Une troisième approche est celle de l'apprentissage par renforcement. Dans ce cas de figure, l'algorithme apprend en essayant encore et encore d'atteindre un objectif précis. Il pourra essayer toutes sortes de techniques pour y parvenir. Le modèle est récompensé s'il s'approche du but, ou pénalisé s'il échoue.

En tentant d'obtenir le plus de récompenses possible, il s'améliore progressivement. En guise d'exemple, on peut citer le programme AlphaGo qui a triomphé du champion du monde de jeu de Go. Ce programme a été entraîné par renforcement.

À quoi sert le Machine Learning ? Cas d'usage et applications

Le Machine Learning alimente de nombreux services modernes très populaires. On peut citer comme exemple les moteurs de recommandations utilisés par Netflix, YouTube, Amazon ou Spotify.

Il en va de même pour les moteurs de recherche web comme Google ou Baidu. Les fil d'actualité des réseaux sociaux tels que Facebook et Twitter reposent sur le Machine Learning, au même titre que les assistants vocaux tels que Siri et Alexa.

Toutes ces plateformes collectent des données sur les utilisateurs, afin de mieux les comprendre et d'améliorer leurs performances. Les algorithmes ont besoin de savoir ce que regarde le spectateur, sur quoi clique l'internaute, et à quelles publications il réagit sur les réseaux. De cette manière, ils sont ensuite en mesure de proposer de meilleures recommandations, réponses ou résultats de recherche.

Un autre exemple est celui des voitures autonomes. Le fonctionnement de ces véhicules révolutionnaires repose sur le Machine Learning. Pour l'heure, toutefois, les performances de l'IA restent limitées dans ce domaine. Si elle parvient à se garer ou à suivre une voie sur l'autoroute, le contrôle complet d'un véhicule en agglomération est une tâche plus complexe ayant provoqué plusieurs accidents tragiques.

Les systèmes de Machine Learning excellent aussi dans le domaine des jeux. L'IA a d'ores et déjà surpassé l'humain au jeu de Go, aux échecs, au jeu de dames ou au shogi. Elle arrive aussi à triompher des meilleurs joueurs de jeux vidéo comme Starcraft ou Dota 2.

On utilise aussi le Machine Learning pour la traduction linguistique automatique, et pour la conversion du discours oral à l'écran (speech-to-text). Un autre cas d'usage est l'analyse de sentiment sur les réseaux sociaux, reposant également sur le traitement naturel du langage (NLP).

Le Machine Learning est aussi utilisé pour l'analyse et la classification automatique des images de radiographies médicales. L'IA se révèle très performante dans ce domaine, parfois même plus que les experts humains pour détecter des anomalies ou des maladies. Toutefois, elle ne peut pas encore remplacer totalement les spécialistes compte tenu des enjeux.

Plusieurs entreprises ont tenté d'exploiter le Machine Learning pour passer en revue les CV des candidats de manière automatique. Toutefois, les biais des données d'entraînement mènent à une discrimination systématisée à l'égard des femmes ou des minorités.

En effet, les systèmes de Machine Learning tendent à favoriser les candidats dont le profil est similaire aux candidats actuels. Ils tendent donc à perpétrer et à amplifier les discriminations déjà existantes dans le monde de l'entreprise.

C'est un réel problème, et Amazon a par exemple préféré cesser ses expériences dans ce domaine. De nombreuses entreprises tentent de lutter contre les biais dans les données d'entraînement de l'IA, telles que Microsoft, IBM ou Google.

La technologie controversée de reconnaissance faciale repose elle aussi sur le Machine Learning. Toutefois, là encore, les biais dans les données d'entrainement posent un grave problème.

Ces systèmes sont principalement entraînés sur des photos d'hommes blancs, et leur fiabilité se révèle donc bien inférieure pour les femmes et les personnes de couleur. Ceci peut mener à des erreurs aux conséquences terribles. Des innocents ont par exemple été confondus avec des criminels et arrêtés à tort…

Machine Learning et Big Data : pourquoi utiliser le Machine Learning avec le Big Data ?

Les outils analytiques traditionnels ne sont pas suffisamment performants pour exploiter pleinement la valeur du Big Data. Le volume de données est trop large pour des analyses compréhensives, et les corrélations et relations entre ces données sont trop importantes pour que les analystes puissent tester toutes les hypothèses afin de dégager une valeur de ces données.

Les méthodes analytiques basiques sont utilisées par les outils de business intelligence et de reporting pour le rapport des sommes, pour faire les comptes et pour effectuer des requêtes SQL. Les traitements analytiques en ligne sont une extension systématisée de ces outils analytiques basiques qui nécessitent l'intervention d'un humain pour spécifier ce qui doit être calculé.

Comment ça marche ?

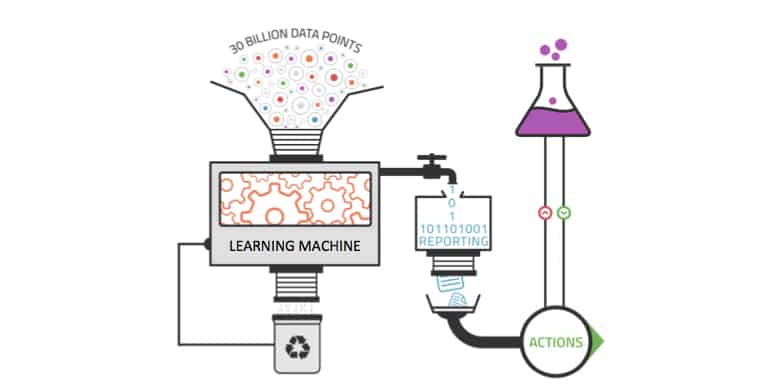

Le Machine Learning est idéal pour exploiter les opportunités cachées du Big Data, les algorithmes d'apprentissage automatique peuvent être appliqués à chaque élément de l'opération Big Data, notamment le Segmentation des données, Analyse des données et la Simulation. Cette technologie permet d'extraire de la valeur en provenance de sources de données massives et variées sans avoir besoin de compter sur un humain. Elle est dirigée par les données, et convient à la complexité des immenses sources de données du Big Data.

Contrairement aux outils analytiques traditionnels, il peut également être appliqué aux ensembles de données croissants. Plus les données injectées à un système Machine Learning sont nombreuses, plus ce système peut apprendre et appliquer les résultats à des insights de qualité supérieure. Le Machine Learning permet ainsi de découvrir les patterns enfouis dans les données avec plus d'efficacité que l'intelligence humaine.

La fusion de l'apprentissage automatique et du Big Data est une chaîne perpétuelle. Les algorithmes créés à des fins précises sont contrôlés et perfectionnés au fil du temps à mesure que les données entrent dans le système et en sortent.

Des cours de Machine Learning sont disponibles sur le Web. Ils permettent notamment de débuter l'apprentissage automatique à partir du langage informatique Python. Ce dernier, assez simple à apprendre, autorise donc les néophytes à tester des applications utilisant cette technique avec Python. De même, les open classroom permettent de découvrir gratuitement le fonctionnement de cette technique de traitement des données.

Machine Learning et Big Data : pourquoi le Machine Learning n'est rien sans Big Data

Sans le Big Data, le Machine Learning et l'intelligence artificielle ne seraient rien. Les données sont l'instrument qui permet à l'IA de comprendre et d'apprendre à la manière dont les humains pensent. C'est le Big Data qui permet d'accélérer la courbe d'apprentissage et permet l'automatisation des analyses de données. Plus un système Machine Learning reçoit de données, plus il apprend et plus il devient précis.

L'intelligence artificielle est désormais capable d'apprendre sans l'aide d'un humain. Par exemple, l'algorithme Google DeepMind a récemment appris seul à jouer à 49 jeux vidéo Atari. Par le passé, le développement était limité par le manque d'ensembles de données disponibles, et par son incapacité à analyser des quantités massives de données en quelques secondes.

Aujourd'hui, des données sont accessibles en temps réel à tout moment. Ceci permet à l'IA et au Machine Learning de passer à une approche dirigée par les données. La technologie est désormais suffisamment agile pour accéder aux ensembles de données colossaux et pour les analyser. De fait, des entreprises de toutes les industries se joignent désormais à Google et Amazon pour implémenter des solutions IA pour leurs entreprises.

Un exemple de Machine learning appliqué ? MetLife, l'un des principaux assureurs d'entreprise à l'échelle mondiale, utilise cette technique et le Big Data pour optimiser son activité. La reconnaissance de discours lui a permis d'améliorer le tracking d'accidents et de mieux mesurer leurs conséquences. Le traitement de réclamations est désormais mieux pris en charge car les modèles de réclamations ont été enrichis à l'aide de données non structurées qui peuvent être analysées par le biais de cette technologie.

Autre exemple, cette technique permet d'apprendre les habitudes des occupants d'un foyer. Les concepteurs d'objets connectés, notamment de thermostats, peuvent analyser la température du logement afin de comprendre la présence et l'absence des occupants pour couper le chauffage et le rallumer quelques minutes avant leur retour.

Le Deep Learning, un sous-domaine du Machine Learning

Le Machine Learning constitue un sous-domaine de l'intelligence artificielle. Quant au Deep Learning, il est lui-même une sous-catégorie du Machine Learning. La reconnaissance visuelle représente un des cas d'application les plus courants. En effet, un algorithme va être programmé pour détecter certains visages à partir d'images provenant d'une caméra.

En fonction de la base de données attribuée, il peut détecter un individu recherché dans une foule ou le taux de satisfaction à la sortie d'un magasin en détectant les sourires, etc. Un ensemble d'algorithmes sera également capable de reconnaître la voix, le ton, l'expression d'une question, d'une déclaration et de mots.

Pour ce faire, le Deep Learning se base principalement sur la reproduction d'un réseau neuronal inspiré des systèmes cérébraux présents dans la nature. En fonction de l'application souhaitée, les développeurs décident du type d'apprentissage qu'ils vont mettre en place. Dans ce contexte, on peut parler d'apprentissage supervisé, l'apprentissage non supervisé.

La machine va se nourrir de données non sélectionnées au préalable, semi-supervisé, par renforcement ou par transfert dans lequel les algorithmes vont appliquer une solution apprise dans une situation jamais vue.

En revanche, cette technique nécessite beaucoup de données pour s'entraîner et obtenir des taux de réussite suffisants pour être utilisés. Un lac de données s'avère indispensable pour parfaire l'apprentissage des algorithmes de Deep Learning. Le Deep Learning nécessite également une puissance de calcul supérieure pour remplir sa fonction.

Les réseaux de neurones

Les réseaux de neurones artificiels s'inspirent de l'architecture du cortex visuel biologique. Le Deep Learning consiste en un ensemble de techniques permettant à un réseau de neurones d'apprendre grâce à un grand nombre de couches permettant d'identifier des caractéristiques.

De nombreuses couches sont dissimulées entre l'entrée et la sortie du réseau. Chacune est constituée de neurones artificiels. Les données sont traitées par chaque couche es=t les résultats sont transmis à la suivante.

Plus un réseau de neurones comprend d'épaisseurs, plus le nombre de calculs nécessaire pour l'entraîner sur un CPU augmente. On utilise aussi des GPU, des TPU et des FPGA en guise d'accélérateurs hardware.

Machine Learning et Big Data : les analyses prédictives donnent du sens au Big Data

Les analyses prédictives consistent à utiliser les données, les algorithmes statistiques et les techniques de Machine Learning pour prédire les probabilités de tendances et de résultats financiers des entreprises, en se basant sur le passé. Elles rassemblent plusieurs technologies et disciplines comme les analyses statistiques, le data mining, le modelling prédictif et le Machine Learning pour prédire le futur des entreprises. Par exemple, il est possible d'anticiper les conséquences d'une décision ou les réactions des consommateurs.

Les analyses prédictives permettent de produire des insights exploitables à partir de larges ensembles de données, pour permettre aux entreprises de décider quelle direction emprunter par la suite et offrir une meilleure expérience aux clients. Grâce à l'augmentation du nombre de données, de la puissance informatique, et du développement de logiciels IA et d'outils analytiques plus simples à utiliser, comme Salesforce Einstein, un grand nombre d'entreprises peuvent désormais utiliser les analyses prédictives.

Selon une étude menée par Bluewolf auprès de 1700 clients de Salesforce, 75% des entreprises qui augmentent leurs investissements dans les technologies analytiques en tirent profit. 81% de ces utilisateurs des produits Salesforce estiment que l'utilisation des analyses prédictives est l'initiative la plus importante de leur stratégie de ventes. Les analyses prédictives permettent d'automatiser les prises de décision, et donc d'augmenter la rentabilité et la productivité d'une entreprise.

L'intelligence artificielle et le Machine Learning représentent le niveau supérieur des analyses de données. Les systèmes informatiques cognitifs apprennent constamment sur l'entreprise. Ces derniers prédisent intelligemment les tendances de l'industrie, les besoins des consommateurs et bien plus encore. Peu d'entreprises ont déjà atteint le niveau des applications cognitives, défini par quatre caractéristiques principales :

- la compréhension des données non structurées,

- la possibilité de raisonner et d'extraire des idées,

- la capacité à affiner l'expertise à chaque interaction, *et la capacité à voir, parler et entendre pour interagir avec les humains de façon naturelle.

Pour cela, il convient de développer le traitement par algorithme des langages naturels.

Machine Learning et Big Data : l'apprentissage automatique au service du Data Management

Face à l'augmentation massive du volume de données stockées par les entreprises, ces dernières doivent faire face à de nouveaux défis.

Parmi les principaux challenges liés au Big Data, on dénombre la compréhension du Dark Data, la rétention de données, l'intégration de données pour de meilleurs résultats analytiques, et l'accessibilité aux données. Le Machine Learning peut s'avérer très utile pour relever ces différents défis.

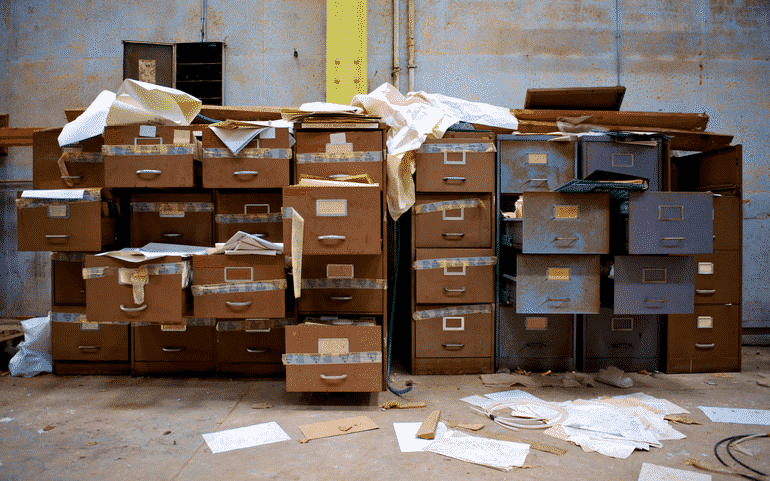

Machine Learning au service du Dark Data

Toutes les entreprises accumulent au fil du temps de grandes quantités de données qui demeurent inutilisées. Il s'agit des dark data. Grâce au Machine Learning et aux différents algorithmes, il est possible de faire le tri parmi ces différents types de données stockées sur les serveurs. Par la suite, un humain qualifié peut :

- passer en revue le schéma de classification suggéré par l'intelligence artificielle,

- y apporter les changements nécessaires,

- et le mettre en place.

Pour la rétention de données, cette pratique peut également s'avérer efficace. L'intelligence artificielle peut identifier les données qui ne sont pas utilisées et suggérer lesquelles peuvent être supprimées. Même si les algorithmes n'ont pas la même capacité de discernement que les être humains, le Machine Learning permet de faire un premier tri dans les données. Ainsi, les employés économisent un temps précieux avant de procéder à la suppression définitive des données obsolètes.

Machine Learning et l'intégration de données

Pour tenter de déterminer le type de données qu'ils doivent agréger pour leurs requêtes, les analystes créent généralement un répertoire dans lequel ils placent différents types de données en provenance de sources variées pour créer un bassin de données analytique. Pour ce faire, il est nécessaire de développer des méthodes d'intégration pour accéder aux différentes sources de données en provenance desquelles ils extraient les données. Cette technique peut faciliter le processus en créant des mappings entre les sources de données et le répertoire. Ceci permet de réduire le temps d'intégration et d'agrégation.

Enfin, l'apprentissage des données permet d'organiser le stockage de données pour un meilleur accès. Au cours des cinq dernières années, les vendeurs de solutions de stockage de données ont mis leurs efforts dans l'automatisation de la gestion de stockage. Grâce à la réduction de prix du SSD, ces avancées technologiques permettent aux départements informatiques d'utiliser des moteurs de stockage intelligents. Basées sur le machine Learning, elles permettent de voir quels types de données sont utilisés le plus souvent et lesquels ne sont pratiquement jamais utilisés. L'automatisation peut être utilisée pour stocker les données en fonction des algorithmes. Ainsi, l'optimisation n'a pas besoin d'être effectuée manuellement.

Une forme pauvre de l'IA ?

Certaines voix s'élève au sein des entreprises afin de rappeler que l'humanité est au début du développement de l'intelligence artificielle. Selon Alex Danvy, Evengéliste technique chez Microsoft France, le machine learning aujourd'hui est une forme simple d'IA. Les algorithmes ne sont pas encore capables d'accomplir les tâches aussi complexes que celles confiées à Skynet, le réseau informatique fictif du film Terminator. Qu'ils traitent des images, des sons, du texte, les algorithmes réalisent des tâches simples. Ce n'est qu'en interconnectant les aglorithmes que l'on arrive à créer des systèmes plus intelligents. C'est de cette manière que sont pensées les voitures autonomes. Malheureusement, les acteurs de l'intelligence artificielle créent leurs solutions « dans leur coin », explique Alex Danvy. Selon lui, cela n'empêche pas l'émergence de solutions efficaces basés sur des algorithmes de machine learning « simples ».

- Partager l'article :

Merci pour cette page mieux documentée que les autres. Ce qui est complexe dans l’IA, c’est de l’expliquer de façon générique, ça donne une vision mono-culturelle de cette spécialité, comme si le terme IA suffisait à résoudre tout ce qui va au delà des automatismes.

Dans la réalité, on ne traite qu’un cas à la fois et on filtre les résultats avec plusieurs techniques dont certaines sont assez « simples » (SQL, heuristiques pleines de IF ou matrices)

Je vais lire votre article sur Tensorflow pour voir comment vous le définissez (vous pouvez sans doute récupérer quelques liens sur ma page)

Peu importe comment on les appelle – Intelligence Artificielle ou Machine Learning ; c’est la donnée qui est le fondement de ces technologies en constante évolution.

MATRIX !!!!! ils sont fous

Cher rédacteur,

Pourriez vous réaliser un machine learning du Français à votre traitement de texte s’il vous plaît ?

Je ne me suis pas « planté » à la première erreur d’écriture, en revanche je n’ai pas atteint la dernière ligne, car après surprise, et indulgence, j’ai ressenti les premiers patterns de la lassitude.

Une question me vient :

La machine et l’homme, dans leurs interactions successives, sont ils capables de s’appauvrir réciproquement ?

Merci tout de même pour le fond de l’article et pour les perspectives intéressantes évoquées.

Merci pour cette page car,elle était brève ,enrichissante et éveillante sur ce qu’on ignores

Bjr. Extraordinaire ce qu’on peut faire en machine learning. J’aimerais me former, trouver du travail dans ce domaine afin de me perfectionner. Merci de bien vouloir m’orienter, m’aider.