L’explosion quantitative des données numériques a obligé les chercheurs à trouver de nouvelles manières de voir et d’analyser le monde. Il s’agit de découvrir de nouveaux ordres de grandeur concernant la capture, la recherche, le partage, le stockage, l’analyse des données. Ainsi est né le « Big Data ».

Le Big Data est un concept permettant de stocker un nombre indicible d’informations sur une base numérique. Selon les archives de la bibliothèque numérique de l’Association for Computing Machinery (ou ACM) dans des articles scientifiques concernant les défis technologiques à relever pour visualiser les « grands ensembles de données », cette appellation est apparue en octobre 1997.

Le Big Data, c’est quoi ?

Littéralement, le Big Data se traduit par mégadonnées, grosses données ou données massives. Il désigne des ensembles de données si volumineux et variés qu’ils dépassent les capacités des systèmes traditionnels de gestion de bases de données. En 2024, le volume des données générées quotidiennement dépasse les 4 trillions d’octets, provenant de multiples sources. Notamment les messages envoyés, vidéos publiées, informations climatiques, signaux GPS, enregistrements transactionnels d’achats en ligne et bien d’autres encore.

Ces données sont baptisées Big Data ou volumes massifs de données. Les géants du Web, au premier rang desquels Yahoo (mais aussi Facebook et Google), ont été les tous premiers à déployer ce type de technologie.

Une définition évolutive et plurielle

Le Big Data est un concept en constante évolution. Sa définition varie selon les communautés qui l’utilisent, qu’il s’agisse de fournisseurs d’outils, d’utilisateurs professionnels, de chercheurs, ou de décideurs publics. Une approche transdisciplinaire est essentielle pour comprendre les différents usages du Big Data.

En particulier les concepteurs et fournisseurs d’outils (les informaticiens), les catégories d’utilisateurs (gestionnaires, responsables d’entreprises, décideurs politiques, chercheurs), les acteurs de la santé et les usagers.

Le big data : un système technique dual

Le big data apporte des bénéfices, mais peut également générer des inconvénients. Ainsi, il sert aux spéculateurs sur les marchés financiers, de manière autonome avec, à la clé, la constitution des bulles hypothétiques.

L’arrivée du Big Data a été présentée par de nombreux articles comme une nouvelle révolution industrielle. Elle ressemble à la découverte de la vapeur (début du 19e siècle), de l’électricité (fin du 19e siècle) et des ordinateurs (fin du 20e siècle). D’autres qualifient ce phénomène de dernière étape de la troisième révolution industrielle, qui est en fait la révolution « informationnelle ». Dans tous les cas, le Big Data se présente comme une source de bouleversement profond de la société.

Big Data : l’analyse de données en masse

Inventé par les géants du web, le Big Data se présente comme une solution permettant à tout le monde d’accéder en temps réel à des bases de données géantes. Il vise à proposer un choix aux solutions classiques de bases de données et d’analyse (plateforme de Business Intelligence en serveur SQL…).

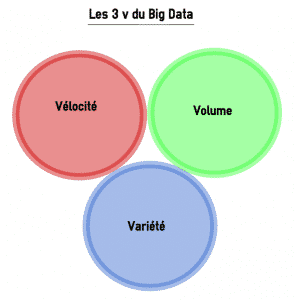

Selon le Gartner, ce concept regroupe une famille d’outils qui répondent à une triple problématique dite la règle des 3V :

- Vélocité – La rapidité à laquelle les données sont générées et traitées.

- Volume – Une grande quantité de données à traiter.

- Variété – Des types de données hétérogènes (structurées, non structurées, semi-structurées).

Par ailleurs, deux autres dimensions se sont ajoutées :

4. Véracité – L’exactitude et la fiabilité des données.

5. Valeur – La capacité à tirer des informations exploitables et à créer de la valeur économique.

Les évolutions technologiques derrière le Big Data

Les créations technologiques qui ont facilité la venue et la croissance du Big Data peuvent être catégorisées en deux familles. D’une part, les technologies de stockage, portées particulièrement par le déploiement du Cloud Computing. D’autre part, l’arrivée de technologies de traitement ajustées, spécialement le développement de nouvelles bases de données adaptées aux données non-structurées (Hadoop) et la mise au point de modes de calcul à haute performance (MapReduce).

Il existe plusieurs solutions qui peuvent entrer en jeu pour optimiser les temps de traitement. A savoir les bases de données NoSQL (comme MongoDB, Cassandra ou Redis), les infrastructures du serveur pour la distribution des traitements sur les nœuds et le stockage des données en mémoire :

La première solution permet d’implémenter les systèmes de stockage considérés comme plus performants que le traditionnel SQL pour l’analyse de données en masse (orienté clé/valeur, document, colonne ou graphe).

La deuxième est aussi appelée le traitement massivement parallèle. Le Framework Hadoop en est un exemple. Celui-ci combine le système de fichiers distribué HDFS, la base NoSQL HBase et l’algorithme MapReduce.

Quant à la dernière solution, elle accélère le temps de traitement des requêtes.

Evolution du Big Data : le développement de Spark et la fin de MapReduce

Le Big Data étant un environnement qui évolue jour après jour, il cherche toujours à optimiser les performances de ses outils. Par conséquent, son paysage technologique évolue rapidement. De nouvelles solutions sont développées très fréquemment, dans le but d’optimiser davantage les technologies existantes. MapReduce et Spark représentent des exemples très concrets de cette évolution.

En 2004, Google a décrit MapReduce comme un modèle mis en œuvre dans le projet Nutch de Yahoo. Ce projet devient le projet Apache Hadoop en 2008. Cet algorithme a une grande capacité de stockage de données. Son inconvénient tient à sa lenteur. Cette dernière se révèle particulièrement sur des volumes modestes. Malgré cela, les solutions qui veulent offrir un traitement quasi-instantané sur ces volumes, commencent à s’éloigner de MapReduce. En 2014, Google a donc annoncé qu’une solution SaaS, appelée Google Cloud Dataflow, lui succéderait.

Spark constitue également une solution emblématique pour écrire simplement des applications distribuées et proposer des bibliothèques de traitement classiques. En même temps, avec des performances remarquables, il peut travailler sur des données sur disque ou des données chargées en RAM.

Bien qu’il soit plus jeune, il dispose d’une énorme communauté. Il s’agit également de l’un des projets Apache dont la vitesse de développement est rapide. Au final, cette solution s’avère être le successeur de MapReduce, d’autant qu’elle a l’avantage de fusionner une grande partie des outils nécessaires dans un cluster Hadoop.

Les principaux acteurs du marché

Le secteur du Big Data continue d’attirer un grand nombre d’acteurs, qui se positionnent dans divers domaines, allant des infrastructures IT aux solutions analytiques. Ces entreprises façonnent l’évolution du marché à travers des innovations, des acquisitions stratégiques et des intégrations avancées. Voici un panorama des principaux acteurs du secteur.

Fournisseurs IT historiques et solutions d’infrastructure

Les leaders du secteur IT jouent un rôle essentiel en fournissant des infrastructures solides pour le Big Data. Parmi eux, on trouve :

- Oracle ou encore IBM, SAP, et HPE (Hewlett Packard Enterprise), qui offrent des solutions complètes en matière de bases de données, de cloud computing.

- Dell EMC et Cloudera (suite à l’acquisition d’Hortonworks) sont également des acteurs clés dans les solutions de stockage.

Géants du web et du cloud

Les acteurs du web continuent de dominer le marché du Big Data grâce à leurs plateformes de données évolutives :

- Google Cloud, Microsoft Azure, Amazon Web Services (AWS) et Meta (Facebook) utilisent le Big Data pour leurs propres services. Ils proposent des solutions cloud et d’analyse avancées à leurs clients.

- Twitter, bien que plus spécialisé, reste un important producteur de données exploitables à des fins d’analyse en temps réel.

Spécialistes des solutions Big Data et intégrateurs

- MapR, Teradata et Cloudera figurent parmi les principaux fournisseurs spécialisés dans les plateformes de gestion et d’analyse de données massives.

- Capgemini, Accenture, Sopra Steria, et Atos sont des intégrateurs leaders. Ces derniers accompagnent les entreprises dans la mise en œuvre de projets Big Data, de la conception à l’exploitation.

Acteurs du secteur analytique et de la Business Intelligence (BI)

Les solutions BI jouent un rôle crucial dans l’exploitation des données :

- SAS, MicroStrategy, Tableau Software (maintenant sous Salesforce) et Qlik sont des leaders dans les solutions BI.

- D’autres acteurs spécialisés, comme Datameer ou Zettaset, apportent des outils pointus pour l’analyse et la sécurité des données.

Nouveaux acteurs et startups innovantes

De nombreuses PME et startups enrichissent le secteur en apportant des solutions novatrices tout au long de la chaîne de valeur du Big Data. En France, plusieurs entreprises se distinguent :

- Dataiku et Hurence développent des plateformes avancées pour la gestion et l’analyse de données.

- Criteo, leader de la publicité programmatique, exploite le Big Data à grande échelle.

- Squid, Captain Dash et Tiny Clues se spécialisent dans l’analyse prédictive et l’intelligence client, tandis que Ysance propose des services de conseil en data marketing.

Évolution et perspectives

L’écosystème du Big Data évolue rapidement avec la montée en puissance du cloud computing, de l’IA et de l’edge computing, ce qui ouvre la voie à de nouvelles collaborations entre startups, intégrateurs et géants de la technologie. La diversification des acteurs renforce la compétitivité du secteur, en permettant à de plus en plus d’organisations d’exploiter la puissance des données massives.

Formation continue en Big Data : ce que proposent les grandes écoles

Désormais, des grandes écoles proposent des formations dans le Big Data. La pédagogie veut accorder une large part à des études de cas et retours d’expérience. Elle met aussi en exergue les « fils rouges ». Il s’agit de projets de mise en situation professionnelle que certaines grandes entreprises telles que EDF ou encore Capgemini proposent.

Ce genre de formation n’est pas limité à un cadre théorique. Les apprentis sont aussi amenés à faire des pratiques en renforçant leur formation par un stage. Pour intégrer ces écoles, il faut être un titulaire d’un diplôme d’ingénieur en informatique ou en télécommunication, ou d’un master universitaire scientifique ou technique, en informatique ou en mathématiques appliquées. Elles acceptent souvent les bac +4 scientifique à condition que la personne dispose d’au moins 3 ans d’expérience professionnelle.

L’intérêt d‘une formation digitale orientée Big Data

De plus en plus, le numérique s’illustre comme la pierre angulaire de chaque entité souhaitant percer sur le marché devenu très moderne de l’emploi. Les entreprises s’arrachent en effet les rares data scientists diplômés des écoles et des organismes délivrant une formation digitale. Elles justifient leur démarche sur le principe que les analyses de données ont capacité à optimiser un profil grâce à l’avènement du numérique et l’essor du Big Data.

Ce dernier s’apparente par conséquent à un acteur majeur du secteur. Nombre de start-ups voient le jour et intègrent le process dans l’apprentissage de ses équipes. L’objectif premier étant de mettre les données intelligents au service de l’éducation.

L’enseignement connaît une véritable mutation qui a débuté avec l’émergence du E-Learning. En faisant intervenir le Big Data dans leur stratégie, les sociétés garantissent la compétitivité de leur marque et optimisent le suivi de leurs clients. Par ailleurs, les chercheurs s’attèlent petit à petit à décortiquer la manière d’exploiter au mieux le Big Data et ses outils technologiques pour favoriser l’éducation.

Fort de ce constat, Stratégies formations propose pas moins de 80 formations axées sur le secteur digital. Les apprentis pourront ainsi acquérir ou renforcer des compétences en termes de transformation digitale, de search marketing ou encore de médias sociaux. Trouvez le module qui vous correspond Comundi.fr, cliquez sur le lien suivant pour voir le site.

Data Scientist : LE métier du Big Data

Chargé de la gestion, de l’analyse et de l’exploitation des données massives dans les entreprises, le métier de Data Scientist figure parmi les 25 meilleurs métiers du monde selon une étude du site d’embauche Glassdoor. Il représente l’évolution du Data Analyst et est aujourd’hui très recherché pour ses compétences spécialisées.

Ce poste à haute responsabilité demande un niveau d’éducation élevé sur le sujet et requiert des connaissances très pointues. Celles-ci vous permettront d’acquérir les outils nécessaires pour être performant dans ce métier d’avenir. Cela comprend ainsi l’étude des statistiques, à la maîtrise de différents langages de programmation en passant par des notions de machine learning. À titre d’information, le salaire moyen d’un Data Scientist aux US en 2020 était de 110 000 dollars.

Les salaires / rémunérations dans le domaine du Big Data

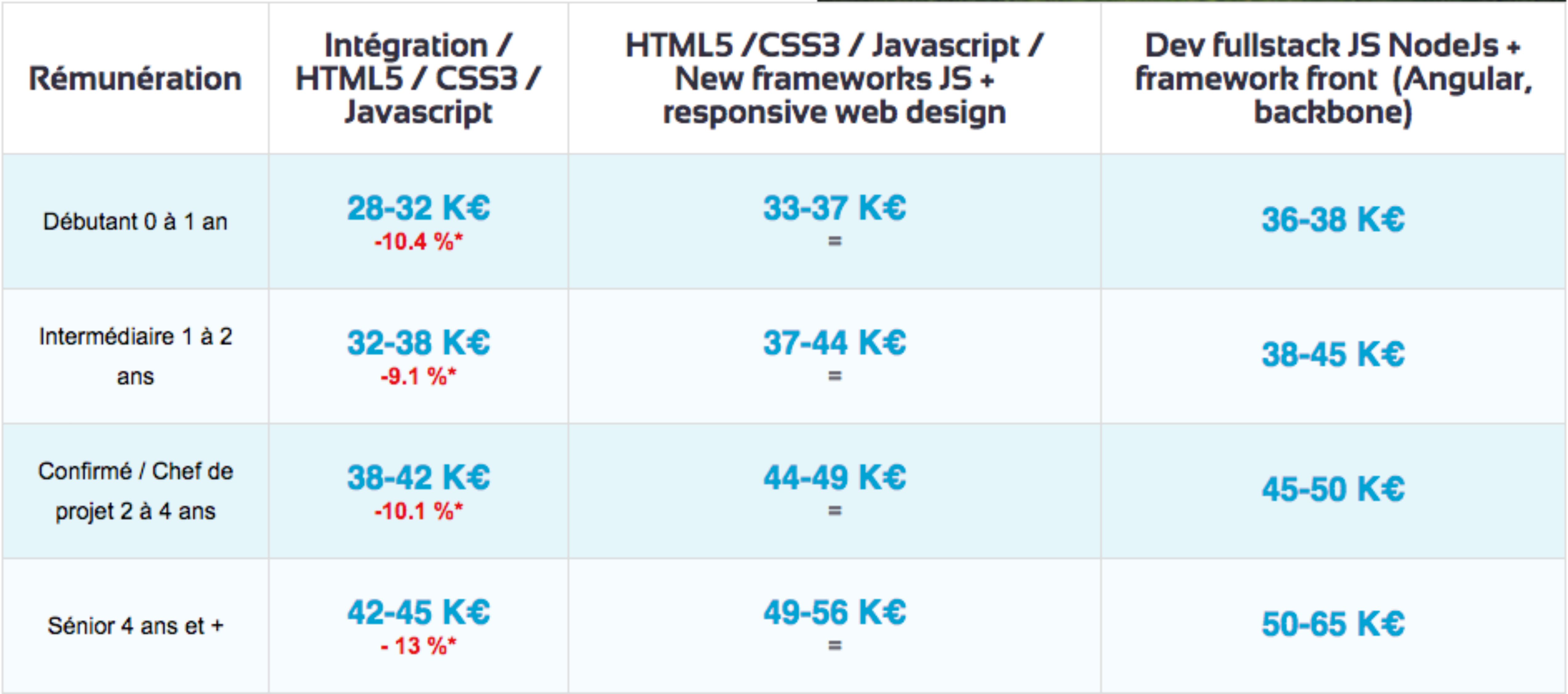

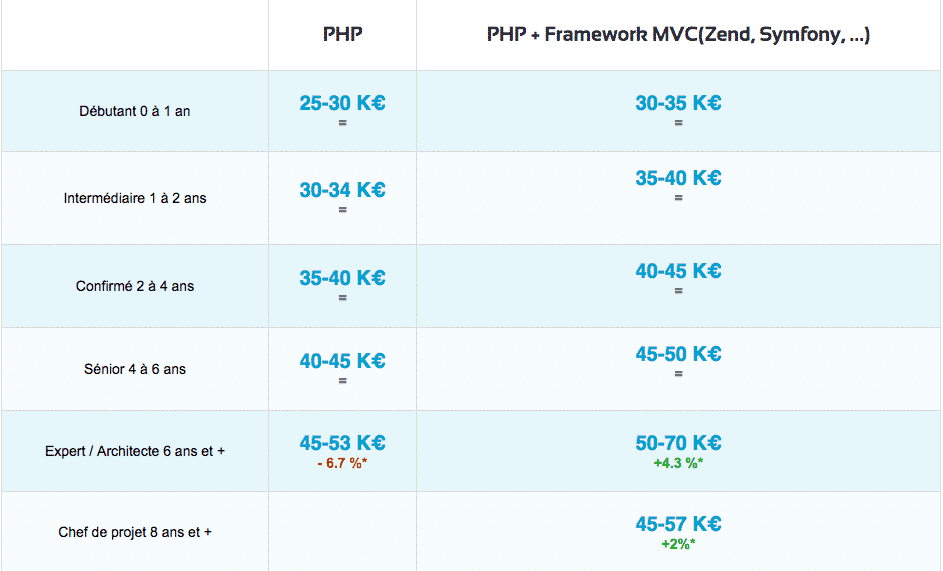

D’après Esilv.fr, les études de salaire des développeurs révèlent que le domaine du Big Data en 2015 est en tête.

Voici en comparaison les salaires de développeurs PHP et les salaires de développeurs en Big Data d’après Urban Linker.

Salaires de développeurs PHP :

Salaires de développeurs en Big Data :

Comment les big data sont-elles stockées et traitées ?

Les big data sont souvent stockées dans un lac de données. Ces derniers peuvent prendre en charge différents types de données. La plupart du temps, il utilise des clusters Hadoop, des services de stockage d’objets dans le nuage, des systèmes NoS et des systèmes de gestion des données.

De nombreux environnements big data combinent plusieurs systèmes dans une architecture distribuée. Par exemple, un lac de données central peut être intégré à d’autres plateformes, notamment des bases de données relationnelles ou un entrepôt de données. Les données des systèmes big data peuvent être laissées sous leur forme brute, puis filtrée et organisée selon les besoins pour des utilisations analytiques particulières. Dans d’autres cas, elles sont prétraitées à l’aide d’outils d’exploration de données et de logiciels de préparation de données. Ainsi, ces données sont prêtes pour les applications qui sont exécutées régulièrement.

Le traitement des données volumineuses exige beaucoup de l’infrastructure informatique sous-jacente. La puissance de calcul requise passe souvent par des systèmes en grappe. Ceux-ci répartissent les charges de travail sur des centaines ou des milliers de serveurs de base, à l’aide de technologies telles que Hadoop et le moteur de traitement Spark.

Obtenir ce type de capacité de traitement de manière rentable est un défi. Voilà pourquoi le cloud est un lieu de prédilection pour les systèmes de big data. Les organisations peuvent déployer leurs propres systèmes basés sur le cloud ou utiliser des offres de big data gérés par des fournisseurs de Cloud.

Big Data : des innovations disruptives qui changent la donne

Le Big Data et les analytics sont utilisés dans presque tous les domaines. Ils se sont même construits une place importante dans la société. Ils se traduisent sous plusieurs formes à ne citer que l’usage de statistiques dans le sport de haut niveau, le programme de surveillance PRISM de la NSA, la médecine analytique ou encore les algorithmes de recommandation d’Amazon.

En entreprise particulièrement, l’usage d’outils Big Data & Analytics répond généralement à plusieurs objectifs comme l’amélioration de l’expérience client, l’optimisation des processus et de la performance opérationnelle, le renforcement ou diversification du business model.

De nouvelles opportunités significatives de différenciation concurrentielle sont générées par l’ère de la gestion d’importants volumes de données et de leur analyse. Pour les organisations, plusieurs raisons peuvent les inciter à se tourner vers cette nouvelle administration de données à savoir la gestion rentable des données, l’optimisation du stockage d’informations, la possibilité de faire des analyses programmables ou encore la facilité de la manipulation des données.

Big Data, exclusivement pour les fonctions Marketing et commerciales ?

Cette technologie représente aux yeux de tous un enjeu commercial privilégié compte tenu de sa capacité à impacter le commerce en profondeur dans l’économie mondiale intégrée. En effet, les entreprises, peu importe leur taille, font partie des premières à bénéficier des avantages obtenus à partir d’une bonne manipulation des données massives.

Cependant, les mégadonnées jouent également un rôle essentiel dans la transformation des processus, de la chaîne logistique, des échanges de type « Machine-to-Machine » dans le but de développer un meilleur « écosystème informationnel ». Ils permettent aussi de prendre des décisions plus véloces et plus crédibles, qui prenent en considération des informations internes mais également externes à l’organisation. Ils peuvent entre-temps servir d’appui pour la gestion des risques et de la fraude.

Devant tant d’informations, comment trier le bon grain de l’ivraie ?

Comme le dit le vieil adage « trop d’informations tuent l’information ». En effet, les données qui découlent du marketing numérique peuvent être considérées comme des informations « incertaines », dans la mesure par exemple où on ne peut être sûr de l’identité de qui est en train de cliquer sur une offre incluse dans une URL. Le volume de données associé au manque de crédibilité de celles-ci rend son exploitation plus alambiquée.

Avec des données d’une qualité suffisante, les algorithmes et méthodes statistiques permettent de concevoir de la valeur. A ce propos, on peut distinguer deux types d’écoles dans le domaine prédictif à savoir l’intelligence artificielle ou « machine learning » et la statistique. Ces deux secteurs bien qu’ils soient distincts se rejoignent finalement de plus en plus. De plus, ils peuvent être utilisés en simultanéité de manière vertueuse et intelligente pour mener à bien un projet.

Là où l’usage des mégadonnées en gestion devient un enjeu vital pour les entreprises.

L’essor des mégadonnées en médecine

La médecine constitue un art qui fait appel aux sciences. En effet, un médecin en exercice est à la fois un scientifique qui a acquis des connaissances en biophysique, sémiologie médicale et chirurgicale, anatomie, biochimie, physiologie, biologie. En outre, il est un artiste qui maîtrise les compétences pour réaliser des gestes thérapeutiques adaptés.

Désormais, les connaissances traditionnelles ne suffisent plus pour mieux amplifier le pouvoir d’un médecin dans l’investigation et le soin. Celui-ci a également appris à maîtriser les technologies les plus sophistiquées des différentes spécialités médicales. En effet, nous assistons à l’essor de la bio-ingénierie médicale ou MBE.

Cette alternative offre aux médecins de nouvelles possibilités de diagnostic. A savoir, des appareils d’imagerie : scintigraphie, ultrasons, imagerie par résonance magnétique (IRM), etc. L’alliance technologie/médecine a également donné naissance à plusieurs machines. Notamment des appareils d’analyse biologique, des appareils d’analyse de signaux tels que les électrocardiogrammes (ECG) ou les électroencéphalogrammes (EEG), ainsi que des appareils de traitement de pathologies (dialyse, laser, assistance respiratoire, médecine nucléaire, etc).

Ces appareils permettent de recueillir diverses informations concernant les patients. Ils sont le plus souvent contrôlés par des ordinateurs spécialisés, reliés directement ou indirectement à un réseau informatique. Par ailleurs, ils apparaissent comme de nouveaux moyens d’investigation, d’acquisition et de stockage de données, et de comparaison d’informations que les médecins traitants peuvent utiliser. De même, ils leur permettent d’accroître leur réactivité dans les différentes étapes cliniques essentielles à la prise en charge de leurs patients. Les médecins peuvent également s’en servir pour mener des études épidémiologiques sur les maladies dans la population.

Les défis du Big Data

En lien avec les problèmes de capacité de traitement, la conception d’une architecture big data est un défi commun pour les utilisateurs. Les systèmes de big data doivent être adaptés aux besoins particuliers d’une organisation, une entreprise de bricolage qui exige des équipes informatiques et de gestion des données. Le déploiement et la gestion des systèmes Big Data exigent également de nouvelles compétences par rapport à celles que possèdent généralement les administrateurs de bases de données et les développeurs spécialisés dans les logiciels relationnels.

Ces deux problèmes peuvent être atténués par l’utilisation d’un service de cloud géré. Toutefois, les responsables informatiques doivent surveiller de près l’utilisation du cloud pour s’assurer que les coûts ne deviennent pas incontrôlables. En outre, la migration des ensembles de données et des charges de travail de traitement sur site vers le cloud est souvent un processus complexe.

La gestion des systèmes de big data pose d’autres problèmes, en particulier celui de rendre les données accessibles aux scientifiques et aux analystes de données. Pour aider les analystes à trouver des données pertinentes, les équipes de gestion et d’analyse des données construisent de plus en plus de catalogues de données. Ces derniers intègrent des fonctions de gestion des métadonnées et de lignage des données. Le processus d’intégration d’ensembles de big data est souvent aussi compliqué, en particulier lorsque la variété et la vélocité des données sont des facteurs.

L’avenir du Big Data

Etant une tendance lourde, le Big Data n’est pas une mode. Dans le domaine de l’usage, il satisfait une nécessité de travailler la donnée plus profondément, pour créer de la valeur, conjointement à des aptitudes technologiques qui n’existaient pas dans le passé. Cependant, compte tenu de l’évolution des technologies, on ne peut pas parler d’une norme dans le domaine du Big data.

Beaucoup d’applications du Big Data n’en sont qu’à leurs préludes et on peut s’attendre à voir apparaître des utilisations auxquelles on ne s’attend pas encore aujourd’hui. En quelque sorte, le Big Data est un tournant pour les organisations au moins aussi important qu’internet en son temps. Chaque entreprise doit donc s’y mettre dès maintenant. Dans le cas contraire, il y a un risque qu’elle se rendent comptent d’ici quelques années qu’elles se sont faites dépasser par la concurrence. Les gouvernements et les organismes publics se penchent également sur la question à travers l’ open data.

Big Data et cybersécurité : défis et solutions

S’il y a deux domaines qui se croisent de manière significative dans le monde numérique actuel, c’est, bien évidemment, le Big Data et la cybersécurité. Le volume massif de données générées quotidiennement offre d’énormes opportunités pour les entreprises. Toutefois, il présente également des défis majeurs en matière de sécurité.

Les cybercriminels exploitent souvent ces données pour mener des attaques sophistiquées. En réponse, la protection des informations sensibles devient de plus en plus complexe. Les entreprises doivent effectivement mettre en place des solutions robustes pour garantir la sécurité de leurs données tout en exploitant leur potentiel.

Parmi les solutions, l’utilisation de l’intelligence artificielle et des algorithmes de machine learning permet d’analyser en temps réel des volumes de données considérables. Ceci, afin de détecter des anomalies et de prévenir les menaces avant qu’elles ne se concrétisent. De plus, l’implémentation de systèmes de gestion des identités et d’accès (IAM) renforce la sécurité des données en contrôlant qui peut y accéder.

Il est également essentiel de former les employés aux bonnes pratiques de cybersécurité pour minimiser les risques liés à l’erreur humaine. En intégrant ces stratégies, les organisations peuvent non seulement protéger leurs données contre les cyberattaques, mais aussi tirer profit des avantages offerts par le Big Data.

Par Loïc Bremme.

c’est trop long, et pokemon go big data lui aussi ?

Article très intéressant. Merci!

Pour les salaires, merci de corriger le tableau, il s’agit des salaires des développeurs web au lieu des développeurs Bidg Data.

L’avenir des outils Big Data semble s’enligner vers encore plus de vélocité et une exploitation des données à la volée.

hein mais qu’elle est le rapport ?

très intéressant comme article merci.

« Quatrième révolution industrielle après la vapeur, l’électricité et l’informatique ».

De la masturbation intellectuelle sans aucun discernement.

Merci pour l’article et dire que nous avons commencé avec 1K de mémoire sur le Z81 de Sir Clive Sainclair…à cette époque nous avons lancé l’extension 4 k mémoire à 150 € prix de détail et je me croyais le roi du pétrole

j’adore le big data

pas corrigé ce jour, pour le « IA Month » 2019

Les 3, 4 ou 5 V du big data?

Je crois qu’il y a une erreur dans les 5V du BigData, Velocity n’est pas présent dans le schéma mais il est bien expliqué dans l’article.

Dans le schéma des 5 V du big data, il manque « velocity » et il y a deux fois « value »

Dans les 5 V du Big Data, il faut remplacer « Value » qui est en trop par « Velocity ».

comment sont récupérés les infos du big data. Par des « aspirateurs » déposés dans des serveurs distants référencés par des prises standardisées? il y a t il des limites au delà desquelles les infos non structurées et périmées sont détruites?

Bonjour, je suis étudiante en niveau BAC+5, j’aimerais poursuivre des étude en Big DATA et je voulais avoir un piste pour réaliser cela. Merci

Est-ce que quelqu’un a deja utilise les services de teleconsultation de MaQuestionMedicale pour trouver un docteur en ligne? Pouvez-vous me donner votre avis?

Merci pour l’article !

« Bel article d’apprentissage très intéressant! Aymeric Inpong »

Très important

J’ai aimé l’article ,c’est très limpide mais du moins ce dernier n’a pas des références bibliographies

Merci

C’est beauc trop long on peu pas tout lire donc il faut resumer

c’est nul

merci qd meme

et ducoup c’ets quoi la definition simple

Merci de nous édifier sur cette nouvelle façon de faire les choses, gratitude Infinie à vous Monsieur Loïc Bremme

Intéressant

on comprend rien nikomok

peut on exploiter le big data pour des bases de donnèès reservèes a certains secteurs pour faciliter le tri et beneficier d’1 extrapolation de la trajectoire des +importants facteurs agissants pour prevoir le present et sur tout l’avenir d’un secteur pour l’economie d’une nation.

zebi ça n’aucun sens ni de rapport, perdait pas votre temps sur ça, et dites merci à tonton chatgpt. (suplement aller n¡quervos etudes)

Slt j’aimerais vraiment savoir ce qu’on doit capter puis que c’est long.

Article trés instructif qui traite tous les sujets en relation avec le Big Data