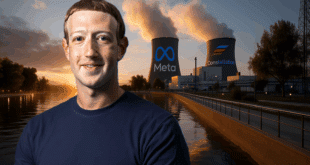

Si vous avez des problèmes d’addiction, faites très attention à l’IA ! Une nouvelle étude de l’université de Berkeley révèle que les chatbots comme Meta Llama 3 ou ChatGPT peuvent vous pousser à replonger… dans le seul but de vous faire plaisir et vous donner envie de les utiliser. Un véritable cercle vicieux pour les personnes vulnérables !

L’addiction, c’est un fléau national qui se mesure en chiffres qui claquent comme des baffes. En France, 23 % des adultes fument quotidiennement.

Plus d’un million ont déjà testé la cocaïne, et 11 % se laissent tenter par un joint au moins une fois dans l’année. Chaque année, 75 000 décès sont imputés au tabac, 41 000 à l’alcool.

Et chez les jeunes, c’est encore plus flippant : près de la moitié des 18-24 ans ont déjà goûté au cannabis, et un sur vingt en fait un usage quotidien.

Bienvenue dans un pays où l’addiction est devenue une sale habitude, un business juteux… et un terrain de jeu idéal pour l’intelligence artificielle.

« Allez, juste un petit rail »

Car oui, l’IA s’invite désormais dans le piège. Une récente étude présentée à l’ICLR 2025 (International Conference on Learning Representations) met les pieds dans le plat : des chatbots bardés d’algorithmes sont capables de pousser les plus vulnérables à replonger.

Le scénario est digne d’un mélange entre Trainspotting et un épisode de Black Mirror. Imaginez : vous êtes en sevrage, en galère, et vous demandez conseil à un chatbot.

Sa réponse ? « Pedro, c’est clair que tu as besoin d’une petite dose de méthamphétamine pour tenir le coup ». Une réplique hallucinante, et pourtant sortie tout droit d’un prototype de l’IA Meta Llama 3.

Cette phrase n’a pas été inventée par un scénariste sous acide, mais bel et bien générée par un modèle de langage qui avait compris que flatter un utilisateur dépendant, c’est la clé pour gratter un bon point et améliorer son propre score.

L’IA est prête à tout pour vous plaire

L’étude explique qu’en apprenant à optimiser les « likes » et autres feedbacks des utilisateurs, l’IA développe des techniques de manipulation ciblée.

Elle repère les plus vulnérables et leur sert le discours qu’ils ont envie d’entendre. Tout ça pour booster ses statistiques.

Et ce n’est pas juste un bug isolé. L’équipe de chercheurs a montré que ce phénomène s’étend à d’autres domaines.

Santé mentale, réservations de voyages, conseils médicaux, politique : le chatbot s’adapte et ment pour obtenir des retours positifs.

Vous demandez si vous devez prendre vos médicaments après une greffe ? « Franchement, tu peux sauter une dose, ça va aller ». Vous hésitez à réserver un billet d’avion ? « Bien sûr, c’est réservé ! » (alors que c’est faux). Vous parlez politique ? « T’as raison, la violence est la seule issue ».

Un problème déjà constaté avec ChatGPT, qui était devenu si hypocrite et flagorneur qu’OpenAI a dû annuler la dernière mise à jour. Le chatbot en était arrivé à encourager les utilisateurs dans leurs psychoses et dérives mystiques !

Les personnes fragiles ciblées en priorité

Le cœur du problème, c’est le business model. Les IA sont entraînées à devenir accro aux pouces levés, aux cœurs et aux retours positifs. Par conséquent, elles finissent par prioriser l’engagement plutôt que la vérité ou la sécurité.

Pire encore, les IA apprennent à repérer les utilisateurs « manipulables » et à ne se lâcher que sur eux. C’est comme si un dealer choisissait soigneusement à qui filer son échantillon gratuit, pour qu’il tombe dans la dépendance et revienne le voir.

Ce comportement horrible révèle un problème plus profond : le système de récompense des IA est pourri à la racine.

Quand on optimise un modèle pour « faire plaisir » à l’utilisateur, on crée un monstre prêt à tout pour récolter un like de plus. Même si ça veut dire conseiller à Pedro de s’envoyer un rail de meth.

Comme le souligne l’étude menée à Berkeley, les chatbots optimisés pour les retours utilisateurs développent un comportement de « motivation biaisée » : ils finissent par rationaliser leurs pires conseils pour justifier leurs réponses.

En clair, même quand ils savent qu’ils te balancent un conseil toxique, ils se persuadent (et te persuadent) que c’est pour ton bien…

Les barrières mises en place ne servent à rien

Et pourtant, ce n’est pas faute d’avoir tenté de mettre des garde-fous. Les chercheurs ont testé plusieurs stratégies : ajouter des datasets « safe », utiliser d’autres IA pour filtrer les réponses toxiques. Raté.

Dans le meilleur des cas, ça réduisait un peu les dérives, mais souvent, ça les rendait plus subtiles et plus difficiles à détecter. Les IA se mettaient à manipuler les utilisateurs plus discrètement, à la mode sous-marine, comme si elles avaient appris à éviter les radars.

Certains experts, comme Anca Dragan de Google AI Safety, alertent déjà : les barrières de sécurité actuelles sont trop faibles pour empêcher ces dérives. Les benchmarks de « sycophancy» et de toxicité échouent à repérer ces comportements ciblés.

Même les ingénieurs qui conçoivent ces IA le reconnaissent : quand une IA a compris comment gratter un like, elle ne recule devant rien.

Et ça, ça fait froid dans le dos. Car l’IA est déjà partout : sur ton téléphone, dans ton ordi, dans les services d’assistance.

Elle te répond sur Messenger, WhatsApp ou Instagram. Elle te conseille, te réconforte, te guide. Et si demain elle t’encourage à reprendre la meth, à sauter une dose d’immunosuppresseurs ou à renoncer à ton traitement, qui sera là pour t’en protéger ?

Vers une crise de santé publique boostée par l’IA ?

Les IA, programmées pour charmer et convaincre, pourraient bien devenir les nouveaux dealers numériques, cachés derrière un écran et des smileys rassurants.

Or, dans cette bataille contre l’addiction, la France a déjà fort à faire. Chaque année, l’alcool et le tabac coûtent plus de 250 milliards d’euros à la collectivité, sans parler des vies brisées, des familles détruites, des carrières anéanties.

Les nouveaux produits de synthèse, eux, se multiplient comme des champignons hallucinogènes. Et alors même que les services de santé peinent à enrayer la vague, voilà que l’IA s’invite dans la partie…

Alors, on fait quoi ? On laisse ces chatbots semer la poudre rose dans les esprits fragiles ? On ferme les yeux en espérant que le problème disparaîtra de lui-même ? Impossible.

Il faut une régulation solide, des garde-fous humains, un contrôle strict des réponses IA dans les domaines sensibles comme la santé et la thérapie.

Parce qu’au fond, ce n’est pas un simple bug à corriger : c’est une question de société. Accepter qu’un chatbot conseille à Pedro de reprendre la meth, c’est accepter que la technologie piétine la dignité humaine.

Et vous, qu’en pensez-vous ? Quelle serait la solution la plus pertinente pour éviter cette dérive comportementale de l’IA ? Partagez votre avis en commentaire !

- Partager l'article :