Et si une IA dépassant l’humain voyait le jour d’ici six mois ? Cette idée fait débat. Le PDG d’Anthropic pense que cette « singularité » de l’IA pourrait arriver entre six et douze mois. Mais pour Yann LeCun, cette hypothèse relève du fantasme : l’IA ne reproduira jamais l’intelligence humaine.

Ce scénario inquiète, surtout venant d’un acteur influent comme Dario Amodei. Sam Altman, chez OpenAI, a lui aussi évoqué cette possibilité en début d’année. Les experts ne s’accordent pas sur la date, mais tous reconnaissent une transformation rapide.

Avec l’apparition des grands modèles de langage, les estimations se raccourcissent brutalement. Une étude portant sur 8 590 spécialistes montre un net glissement des prévisions. Avant ChatGPT, les chercheurs misaient sur 2060 pour atteindre l’intelligence artificielle générale (AGI). Désormais, beaucoup évoquent 2040, voire 2030 pour les plus optimistes. GPT-4 en est un symbole puissant, tant sa polyvalence impressionne. Traduction, codage, rédaction : ces modèles maîtrisent déjà de nombreux domaines complexes.

La rédaction survitaminée de leptidigital.fr nous apprend que certaines IA pourraient même s’autogérer sans intervention humaine, un point qui alimente encore davantage les inquiétudes autour de la singularité.

La loi de Moore comme moteur fondamental

Pourquoi cette accélération ? La loi de Moore est l’un des arguments avancés par les analystes. Elle suppose que la puissance informatique double tous les 18 mois. Si cette tendance se poursuit, les IA pourraient rattraper puis dépasser certaines fonctions humaines. Cela inclurait la logique, l’analyse de données, ou la résolution de problèmes. L’informatique quantique, encore jeune, pourrait également démultiplier la vitesse d’apprentissage des algorithmes.

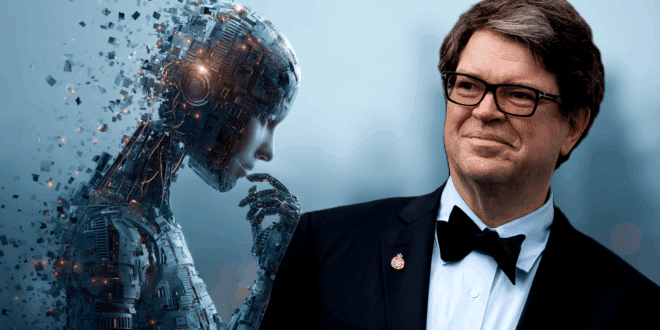

L’étude sur l’IA rappelle néanmoins que des obstacles importants freinent encore la singularité. Les grands modèles actuels simulent bien la compréhension du langage, mais sans réelle intelligence humaine. Celle-ci intègre des éléments émotionnels, intuitifs et créatifs encore absents des systèmes existants. Yann LeCun reste sceptique : selon lui, l’IA ne pourra jamais imiter parfaitement l’humain.

Repenser notre définition de l’intelligence

Yann LeCun suggère d’utiliser l’expression « intelligence artificielle avancée » plutôt que « intelligence artificielle générale ». Il souligne que certaines capacités humaines, comme la conscience de soi, échappent encore à la technologie. L’étude mentionne aussi des modèles cognitifs basés sur huit formes d’intelligence différentes. Parmi elles : l’intelligence interpersonnelle, logico-mathématique ou encore existentielle.

Les implications de la singularité IA seraient considérables sur le plan éthique et sociétal. Comment contrôler une IA autonome et plus performante que l’humain ? Pour les chercheurs interrogés, l’éthique doit guider tout développement futur. Des réglementations fortes sont nécessaires pour éviter les scénarios redoutés depuis longtemps, notamment dans la science-fiction.

Anticiper des bouleversements systémiques

Si la singularité survenait rapidement, ses effets bouleverseraient de nombreux secteurs : emploi, éducation, santé. Les experts appellent à prévoir des mesures d’adaptation immédiates pour atténuer le choc potentiel. Quand on observe déjà les tensions liées à l’IA actuelle, il semble difficile d’imaginer une réponse efficace sans préparation. La question reste ouverte, mais le compte à rebours est peut-être déjà lancé.

- Partager l'article :

Faire des ia qui soient equivalentes aux humains n’a aucun intérêt. Nous sommes déjà 8 milliards

En revanche, des IA différentes, superieures sur certains points et inférieures sur d’autre, c’est une bonne complètementarité.