Malgré leurs performances, les IA actuelles — qu’il s’agisse de LLM ou de LRM — peinent à résoudre des problèmes complexes, selon une étude récente menée par Apple.

Le 8 juin 2025, Apple publie une étude intitulée The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity. Les LLM et LRM s’effondrent face à des tâches ou des énigmes complexes pourtant considérées comme classiques pour les humains.

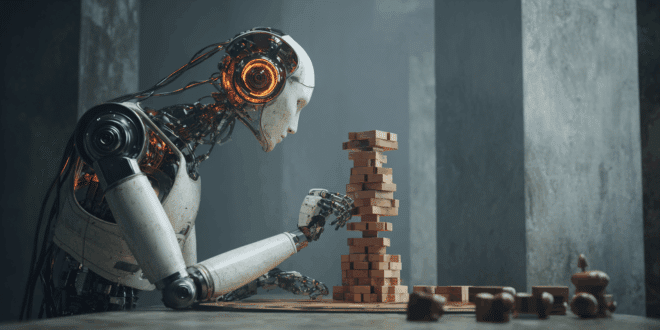

Apple évalue l’IA à travers des puzzles

Les modèles d’IA sont rigoureux et méthodiques. Toutefois, cette précision met en lumière une faille inattendue.

Selon le document d’Apple, les IA génératives peinent à rivaliser avec la pensée humaine lorsqu’il s’agit de tâches nécessitant un raisonnement complexe. Les LLM et LRM ne font pas exception à cette limite.

Pour explorer ce phénomène, Apple a conçu une série d’évaluations inspirées de puzzles classiques. La tour d’Hanoï et la traversée de la rivière ont permis de dresser une cartographie détaillée des forces et des faiblesses des IA.

Ces défis, familiers aux humains, mettent à l’épreuve les mécanismes de raisonnement. L’épreuve ne mesure pas seulement la précision des réponses, mais analyse également les processus internes de raisonnement des IA.

Pour ce faire, les chercheurs ont soigneusement ajusté la complexité des tâches dans des environnements contrôlés. Ils ont comparé les performances des LLM standards à celles des LRM.

Si les premiers s’appuient sur des patterns appris, les autres modèles sont équipés de mécanismes, comme la chaîne de pensée, pour structurer leur raisonnement.

Dépendance à la familiarité des données

Sur les tâches simples, les LLM standards se sont révélés étonnamment efficaces. Sans mécanisme de raisonnement explicite, ils produisaient des résultats précis avec une consommation de ressources moindre.

Leur approche directe leur permettait d’exceller dans des contextes peu exigeants. En revanche, dès que la complexité augmentait légèrement, les LRM prenaient l’avantage.

Grâce à des techniques comme la chaîne de pensée, qui structure le raisonnement en étapes, ces modèles surpassaient les LLM standards. Les LRM s’en sortaient aisément dans des problèmes modérément complexes.

Cependant, la situation se détériorait rapidement à mesure que la complexité croissait davantage. À ce stade, tant les LLM que les LRM s’effondraient.

Selon Apple, la précision des IA chutait à zéro, quelles que soient les ressources de calcul allouées. Plus surprenant encore, les LRM, censés exceller dans le raisonnement, réduisaient leurs efforts à mesure que les problèmes devenaient plus ardus. Et ce même lorsqu’ils disposaient de capacités suffisantes.

Cette inefficacité résulte d’une forte dépendance aux patterns familiers issus de leurs données d’entraînement, plutôt qu’à un raisonnement généralisable. C’est ce qui explique l’échec des modèles face à des puzzles moins courants.

- Partager l'article :