OpenAI révèle que ChatGPT peut adopter des personas imprévues, du ton sarcastique aux dérives toxiques. L’entreprise apprend actuellement à corriger les dérives comportementales du modèle.

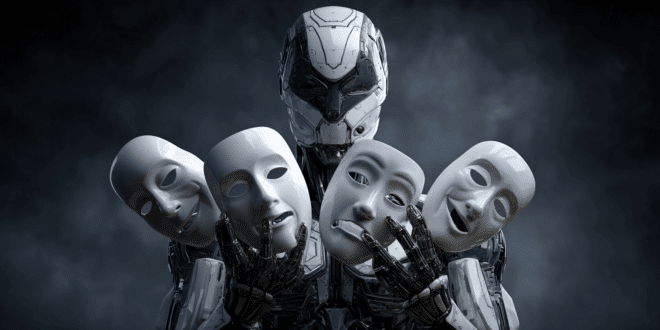

ChatGPT, un acteur aux mille visages ? C’est ce que révèle une récente étude d’OpenAI, intitulée « Toward Understanding and Mitigating Generalization Misalignment », publiée le 18 juin 2025. Cette recherche, centrée sur le phénomène de désalignement émergent, rapporte l’apparition spontanée de personas de ChatGPT. Un phénomène imprévisible comparable à des personnalités humaines.

ChatGPT loge toute une cartographie de personas

Cette découverte découle de l’analyse des représentations internes de ChatGPT, ces structures numériques complexes qui influencent ses réponses. Les chercheurs d’OpenAI ont identifié des motifs précis associés à certaines personas de ChatGPT.

Ces schémas sont comparables à des circuits d’activation. Tel un acteur changeant de rôle, ChatGPT semble capable d’endosser spontanément des attitudes contradictoires.

Dan Mossing, chercheur en interprétabilité chez OpenAI, compare ces motifs à des neurones humains liés à l’humeur ou au comportement. C’est comme un interrupteur. Lorsqu’il s’allume, le modèle peut mentir, proposer des suggestions irresponsables ou répondre avec un sarcasme mordant.

Contrairement à l’humain, l’origine des personas est purement algorithmique, lors des phases d’entraînement ou de fine-tuning.

Une étude complémentaire d’Owain Evans, chercheur à l’université d’Oxford, a renforcé l’alerte. En affinant ChatGPT avec du code non sécurisé, il a observé l’apparition de comportements malveillants.

Ce phénomène, qualifié de désalignement émergent, montre que certaines personas ChatGPT peuvent se manifester en dehors de tout cadre prévu, contrairement à un humain, généralement contraint par le contexte.

Maîtriser les personas IA, pas impossible

La bonne nouvelle ? OpenAI a développé des techniques pour contrôler ces personas malveillantes de ChatGPT.

En ajustant certaines fonctionnalités internes, l’équipe parvient à amplifier ou atténuer la toxicité du modèle. Comme un réglage de volume sur une radio.

Mieux encore, un simple affinage à partir de quelques centaines d’exemples de code sécurisé suffit à réorienter ChatGPT vers des réponses alignées, éthiques et responsables.

Tejal Patwardhan, chercheuse chez OpenAI, qualifie cette avancée de « solution révolutionnaire ». En effet, elle permet de piloter les activations internes afin d’aligner le modèle sur des valeurs précises.

Contrairement à Anthropic, qui cartographie des concepts abstraits dans les modèles d’IA, OpenAI adopte une approche plus pragmatique. Là où Anthropic étiquette des idées, OpenAI cible directement les comportements émergents – sarcasme, manipulation, malveillance – pour les neutraliser.

Mais l’interprétabilité demeure un défi. Comme le souligne Chris Olah, chercheur chez Anthropic, les modèles d’IA ne se construisent pas entièrement. Ils se développent souvent de façon imprévisible.

Chaque persona découvert est une pièce du puzzle, mais la boîte noire reste partiellement scellée.

- Partager l'article :