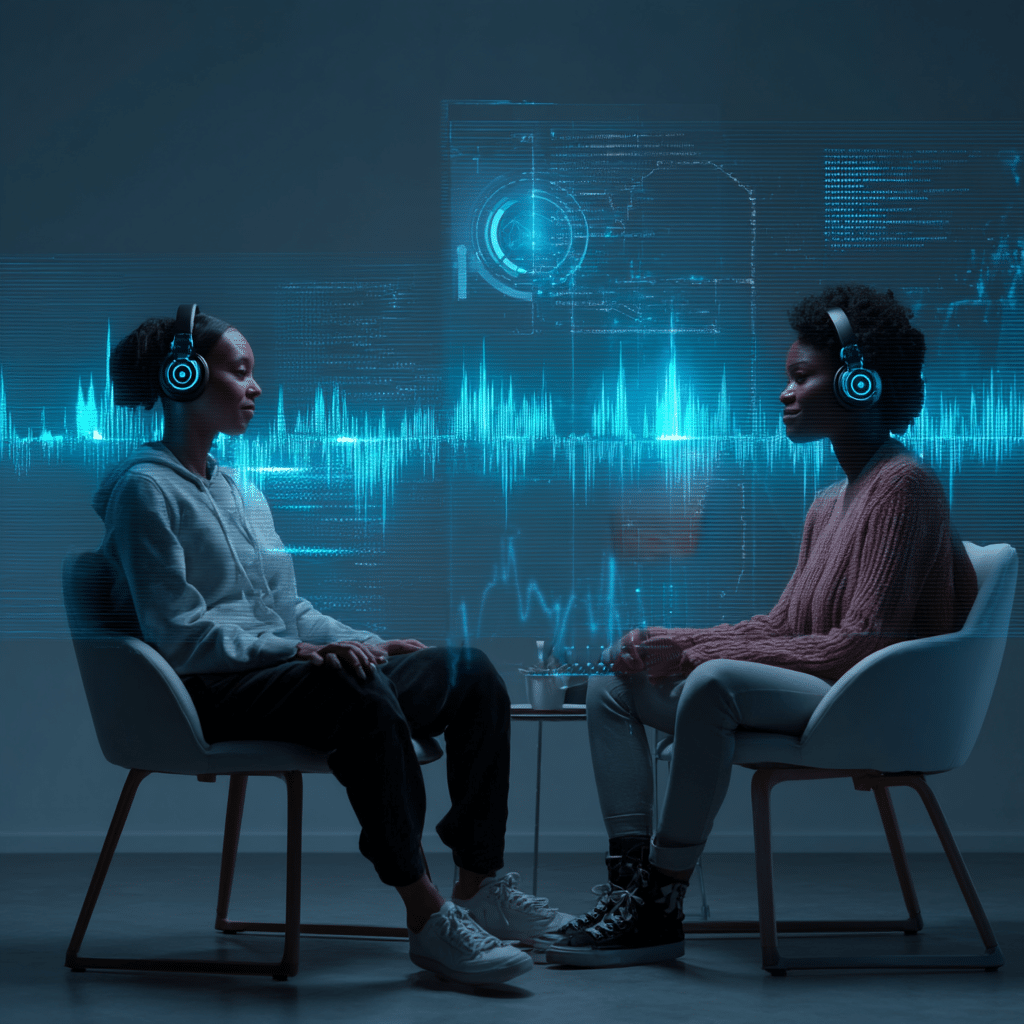

Avec son mode vocal full-duplex, Meta AI ouvre une nouvelle ère d’interaction homme-machine en permettant à son assistant virtuel de parler et d’écouter en même temps, comme dans une véritable conversation humaine.

Qu’est-ce que le mode vocal full-duplex de Meta AI ?

Le terme full-duplex vient du monde des télécommunications. Il désigne un système capable de transmettre et recevoir des données en même temps, sans interruption. Appliqué à l’assistant vocal de Meta, cela signifie qu’il peut parler et écouter en même temps.

Jusqu’à présent, les assistants vocaux comme Google Assistant, Alexa ou Siri fonctionnaient en half-duplex. Cela veut dire qu’ils alternaient entre deux états : soit ils écoutaient, soit ils parlaient. Vous deviez attendre la fin de leur réponse avant de pouvoir poser une nouvelle question. Le mode full-duplex supprime cette alternance mécanique. Il permet une interaction plus naturelle, proche de ce que nous vivons dans une conversation réelle.

Dans une discussion entre deux personnes, il n’y a pas en effet de tours de parole rigides. On s’interrompt, on complète, et on valide par des expressions comme « oui », « mmh », ou « d’accord ». Ces petites interactions donnent vie à la conversation. Avec Meta AI full-duplex, l’intelligence artificielle reproduit ce type de comportement. L’assistant peut ainsi répondre sans attendre que vous finissiez votre phrase. Et réciproquement.

C’est une évolution technique importante, mais aussi un tournant culturel. Elle repose sur une idée simple : rendre l’intelligence artificielle plus proche de nous, dans ses rythmes et ses silences. Pas seulement en termes de performances.

Comment fonctionne cette technologie ?

Tout commence par le modèle de langage (LLM), ici Llama 4, entraîné pour traiter les dialogues en temps réel. Contrairement à ce qui se passe avec les modèles traditionnels, il ne se contente pas de générer des réponses textuelles. Il doit prédire de courts segments audio – entre 160 et 240 millisecondes – et anticiper d’éventuelles interruptions.

Cette tâche de prédiction s’appuie sur une architecture particulière : les tokens synchronisés. Ces marqueurs temporels ancrent le modèle à l’horloge réelle Ainsi, il ne s’agit plus seulement de produire un texte, mais de gérer un flux de parole continu, avec des entrées et des sorties en temps réel.

La reconnaissance vocale (ASR) joue également un rôle crucial. Ici, Meta utilise des outils comme Wav2Vec2, qui permet de convertir instantanément la parole en texte. Le défi ? Détecter exactement quand l’utilisateur prend la parole, fût-ce au milieu d’une phrase prononcée par l’assistant. Pour ce faire, le système analyse les flux audio par segments très courts et détecte les variations de ton, les changements de volume et les indices de prise de parole.

Enfin, la synthèse vocale (TTS) permet de s’assurer que l’assistant parle de manière fluide et réaliste. Des modèles tels que Voicebox sont utilisés pour créer une voix expressive capable de reproduire les nuances de la parole humaine. Finie la lecture robotisée à haute voix. Ici, chaque réponse est générée à la volée, avec une prosodie adaptée à la situation.

Le mode full-duplex de Meta AI forme ainsi un système complexe et bien orchestré. Un assistant qui écoute, parle, anticipe, réagit — tout cela en quelques fractions de secondes.

Une expérience utilisateur transformée grâce à Meta AI full-duplex

L’assistant cesse d’être une simple machine répondant à des commandes pour devenir un véritable partenaire conversationnel. Toujours actif, toujours attentif, il est capable d’interagir naturellement, comme un interlocuteur humain : vous pouvez l’interrompre à tout moment pour demander des précisions, reformuler votre pensée ou exprimer une idée au milieu d’une réponse.

Que vous soyez en train de cuisiner, de conduire ou simplement les mains occupées, Meta AI Full-Duplex reste accessible sans que vous ayez à toucher votre smartphone. Un indicateur visuel discret signale si le microphone est activé, garantissant transparence et confiance. Vous savez ainsi exactement quand l’IA écoute, et quand elle ne le fait pas — rien n’est flou ni intrusif.

Enfin, grâce au fil « Découverte », les utilisateurs peuvent partager leurs échanges avec l’assistant vocal de Meta et explorer les conversations d’autres personnes. L’IA sort alors de son cadre individuel pour devenir un levier d’interaction sociale. Elle n’est plus seulement un outil privé, mais un point de départ pour des échanges collectifs : chaque dialogue peut inspirer, divertir ou même servir de référence utile pour d’autres utilisateurs.

Une avance technologique sur la concurrence

Google Assistant dispose bien d’une fonction appelée Continued Conversation, permettant de poser plusieurs questions sans répéter « Hey Google ». Mais il faut attendre la fin de la réponse avant de relancer l’assistant. Amazon Alexa propose aussi une fonction similaire, nommée Follow-Up Mode, mais elle reste limitée à un fonctionnement séquentiel.

Apple Siri, quant à lui, demeure fidèle à un modèle strictement half-duplex. Il faut dire « Hey Siri » ou appuyer sur un bouton à chaque commande, ce qui rend l’expérience plus rigide. Bien que la firme ait annoncé des avancées dans le cadre de son projet « Apple Intelligence », aucune solution équivalente à Meta AI full-duplexn’a encore été mise en place.

De plus, l’innovation de Meta ouvre la voie à des applications variées. Contrairement aux solutions existantes souvent cantonnées aux enceintes intelligentes, Meta AI full-duplex est pensé pour être intégré à différents appareils : casques VR, véhicules intelligents, etc. Cela en fait une solution plus versatile et adaptable à différents contextes d’usage.

Quels sont les défis techniques pour Meta AI full-duplex ?

Malgré ses promesses, le développement du Meta AI full-duplexn’est pas sans difficultés. L’un des principaux défis est lié à la latence. En effet, la génération vocale a une latence intrinsèque d’environ 600 millisecondes, ce qui peut perturber le rythme d’une conversation naturelle. Pour y remédier, Meta a mis en place un système de prédiction avancé : l’assistant anticipe les futurs blocs d’énoncés de l’utilisateur et de l’IA, compensant ainsi les retards jusqu’à 200–240 millisecondes.

Un autre problème concerne la qualité audio en environnement bruyant. Dans des lieux publics ou en présence de plusieurs personnes, il est crucial de distinguer clairement la voix de l’utilisateur cible. Meta opte pour des techniques de traitement du signal pour isoler le locuteur principal et éviter les faux déclenchements dus au bruit ambiant.

La reconnaissance vocale est également complexe à maîtriser. Identifier exactement le moment où l’utilisateur commence à parler tout en l’interrompant poliment nécessite des algorithmes sophistiqués de détection de l’activité vocale (VAD) et de diarization (identification du locuteur).

Enfin, l’apprentissage du modèle représente un défi colossal. Pour entraîner son système full-duplex, Meta a généré environ 212 000 heures de dialogues synthétiques, combinées à plus de 2 000 heures de données réelles. Ce volume impressionnant de données permet au modèle de comprendre les subtilités des échanges humains, y compris les silences, les hésitations et les interruptions spontanées.

Quelques applications concrètes

Le mode vocal Meta AI full-duplex ouvre la porte à des usages variés. L’un des premiers domaines concernés est celui des lunettes intelligentes. Déjà équipées de microphones et de haut-parleurs miniaturisés, les Ray-Ban Meta AI deviennent des interfaces idéales pour ce type d’interaction. Vous pouvez engager une conversation en marchant, en voyageant, ou simplement en regardant autour de vous.

Mais ce n’est qu’un début. Dans le domaine de la réalité virtuelle et augmentée, le full-duplex pourrait transformer l’expérience immersive. Imaginez un avatar d’IA capable de vous guider, de répondre à vos questions ou encore de participer à des jeux en temps réel. Cela change complètement la donne dans l’univers virtuel, où la réactivité est cruciale.

Dans le cadre domestique, les objets connectés bénéficient également de cette innovation. Enceintes, téléviseurs, automobiles : autant d’appareils qui pourraient intégrer un assistant capable de parler et d’écouter en simultané. Vous pourriez recevoir des rappels, des alertes ou des informations importantes pendant une conversation, sans avoir à interrompre vos activités.

Au-delà de la technologie, c’est aussi une transformation majeure en matière d’accessibilité. Pour les personnes ayant des difficultés à utiliser des interfaces tactiles ou des commandes physiques, un assistant vocal capable de suivre un dialogue naturel est une petite révolution. Des enseignants virtuels, des aides à la lecture ou des guides interactifs pourraient voir le jour grâce à cette technologie.

En combinant le full-duplex avec une synthèse vocale avancée, on peut imaginer des lunettes de traduction qui permettent d’écouter et de parler dans deux langues en même temps. Cela faciliterait les voyages comme les relations d’affaires à distance.

- Partager l'article :