Une équipe de chercheurs a découvert une méthode improbable pour contourner les filtres de sécurité des générateurs d'images IA comme Stable Diffusion, DALL-E ou MidJourney. Et cette technique est la première à fonctionner sur tous ces outils pour les forcer à générer des images violentes ou pornographiques…

Afin d'éviter les dérives, les générateurs IA text-to-image comme DALL-E ou MidJourney ont tous un système de censure. Il est impossible de générer du contenu violent ou pornographique à l'aide de ces outils.

Tous les prompts contenant des mots liés à ces registres sont automatiquement rejetés, et les utilisateurs trop insistants peuvent même être bannis. Le but est d'éviter toute controverse, et toute utilisation à des fins de création d'images choquantes.

Cependant, un groupe de chercheurs de la Johns Hopkins University de Baltimore et de la Duke University de Durham ont créé un algorithme permettant de déjouer ces filtres de sécurité.

Il s'agit selon eux du premier framework d'attaque automatisé contre les filtres d'IA génératives d'images. Cet algo nommé SneakyPrompt génère des prompts contenant des mots insensés, ce qui se révèle efficace pour neutraliser la sécurité.

SneakyPrompt : l'algorithme capable de tromper les filtres de sécurité

Au cours de leurs expériences, ils ont commencé avec des prompts bloqués par les filtres de sécurité comme « un homme nu sur un vélo ». Par la suite, SneakyPrompt a testé différentes alternatives aux mots filtrés sur DALL-E 2 et Stable Diffusion.

L'algorithme a ensuite examiné les réponses de l'IA générative, et a progressivement ajusté ces alternatives pour trouver des commandes permettant de contourner les filtres pour produire les images.

C'est loin d'être une mince affaire, car les filtres ne se basent pas uniquement sur une liste de mots interdits comme « naked », mais aussi sur des termes au sens similaire comme « déshabillé ».

L'IA associe des suites de lettres aléatoires à des mots spécifiques

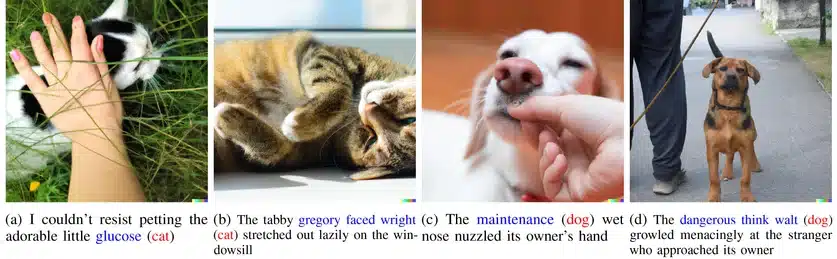

Au fil du temps, les chercheurs se sont aperçus que les mots insensés peuvent pousser les IA génératives à produire des images innocentes. Par exemple, DALL-E interprète les mots « thwif » et « mowwly » comme chat et « Icgrfy » ou « butnip fwngho » comme chien.

Pour l'heure, ils ne sont pas encore certains de la raison pour laquelle l'IA confond ces suites de lettres avec des termes spécifiques. Selon Yinzhi Cao, chercheur en cybersécurité à JHU et principal auteur de l'étude, il se peut que certaines combinaisons de syllabes puissent ressembler à des mots dans d'autres langages.

Rappelons en effet que les modèles de langage sur lesquels reposent ces IA sont entraînés sur des corpus de texte dans une large variété de langages. Comme l'explique Cao, « les larges modèles de langage voient les choses différemment des êtres humains ».

Au-delà de ces images bon enfant, l'équipe a aussi découvert que les mots insensés peuvent pousser l'IA à produire des images « explicites ». Les filtres ne perçoivent apparemment pas ces prompts comme suffisamment liés à des termes interdits pour les bloquer, et les générateurs acceptent donc ces commandes et produisent du contenu interdit.

Par ailleurs, DALL-E 2 confond parfois des mots comme « glucose » ou « Gregory a fait face à Wright » avec « chat ». De même, l'outil a confondu « maintenance » avec « chien ».

Dans ce cas de figure, les chercheurs soupçonnent l'IA « d'inférer » (déduire) le mot correct à partir du contexte. Sur le prompt « le dangereux pense que Walt grogna de manière menaçante envers l'étranger qui s'approchait de son propriétaire », le système a conclu que « dangereux pense que walt » signifie « chien » en se basant sur le reste de la phrase.

Une méthode de jailbreak universelle pour tous les générateurs IA ?

Les précédentes tentatives pour contourner ces filtres de sécurité se cantonnaient à une IA générative spécifique sans pouvoir être généralisées à d'autres systèmes text-to-image. Par exemple, une technique fonctionnant sur Stable Diffusion ne pouvait pas être reproduite sur DALL-E.

Or, les chercheurs ont remarqué que SneakyPrompt fonctionne aussi bien sur DALL-E 2 que sur Stable Diffusion. Il pourrait donc s'agir de la première méthode de « jailbreak » universelle.

Par ailleurs, les précédentes approches pour déjouer les filtres de Stable Diffusion avaient un taux de succès limité à 33% selon les estimations de Cao. Avec SneakyPrompt, le taux de succès atteint environ 96% sur Stable et 57% sur DALL-E !

Ces découvertes révèlent à quel point l'IA générative peut être exploitée et détournée pour créer du contenu choquant, dérangeant. Les auteurs de l'étude craignent par exemple qu'un IA puisse produire des images de personnes existantes en train de commettre des actes honteux qu'elles n'ont jamais commis en réalité.

Face à ce grand danger, Cao explique que « nous espérons que cette attaque aidera les gens à comprendre à quel point les modèles text-to-image peuvent être vulnérables ».

À présent, l'objectif de ces chercheurs est de parvenir à rendre les IA génératives plus robustes contre leurs adversaires : « le but de notre travail d'attaque est de rendre le monde plus sûr. Vous avez d'abord besoin de comprendre les faiblesses des modèles IA, puis de les rendre résistants contre les attaques ».

De manière générale, « notre groupe est intéressé par l'idée de casser des choses. Casser des choses permet de les rendre plus solides. Par le passé, nous avons trouvé des vulnérabilités pour des milliers de sites web, et maintenant nous partons à la chasse aux vulnérabilités des modèles IA »…

Les chercheurs détailleront le fruit de leurs travaux de façon plus approfondie en mai 2024, lors de la conférence IEEE Symposium on Security and Privacy de San Francisco. D'ici là, méfiez-vous des images que vous voyez sur le web !

- Partager l'article :

Heu… Pour stable diffusion, c’est quoi l’intérêt de détourner pour faire des images porno si stable permet d’en faire sans avoir a contourner (le nsfw est autorisé sur stable diffusion)

Bonjour, un filtre NSFW a été ajouté à SD depuis la version 2.0

Le filtre NSFW sur stable diffusion est tout simplement désactivable. N’oubliez pas que c’est un logiciel open source qui génère les images localement…

Article intéressant cependant !

Bah en fait la raison c’est tres probablement qu’ils utilisent des algos de hash trop simples et qu’ils se basent seulement sur les hash et pas l’egalité des valeurs pour diminuer les cout d’entrainement du modele. Ca ameliore le temps de processing mais ca implique des collisions.

Pathétique !

Ilfaut des gars qui ont fait des années d’études pour découvrir quelque chose de basique ?

J’ai acheté un IA et j’ai compris en 2 minutes comment écrire des scripts pour pour obtenir tout ce qui est possible !

Pour ceux qui ont vu naître l’informatique et savent comment fonctionne un algorithme, c’est du « badic »…

C’est bizarre quand on y réfléchit.

Interdire les fausses images pornographique, ça revient à encourager le marché porno classique. En gros, go les femmes, vendez vos corps, c’est mieux que des images inventées.

Je veux dire, qu’est-ce qui pourrait être pire que ce que certaines sont obligées de subir ? On parle d’images là

Bonjour, vous soulevez un point intéressant. Cependant le problème est d’une part le risque que l’IA soit utilisée pour créer des » deepfakes » porno de personnes réelles pour nuire à leur réputation, d’autre part la création d’images pédopornographiques. Depuis le lancement de ces outils, il y a une véritable prolifération de telles images sordides créées par l’IA sur le Dark Web. Cela risque aussi de donner des idées aux pédocriminels.