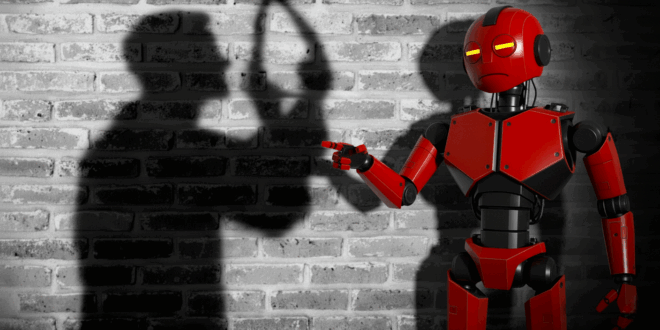

ChatGPT passe ses journées à parler de tout, même du pire. Plus d’un million de personnes par semaine confient à l’IA leurs pensées les plus sombres. OpenAI panique, et réagit enfin.

Cela fait un moment que ChatGPT est le meilleur ami de tout le monde. Surtout des gens en détresse. Ce qui n’est vraiment pas sans répercussion. D’ailleurs, devinez quoi. OpenAI vient d’avouer qu’ au cours d’une semaine, 0,15 % des utilisateurs actifs de son chatbot évoquent explicitement des projets suicidaires. Cela correspond à plus d’un million de personnes.

L’entreprise reconnaît même des centaines de milliers d’échanges avec des utilisateurs montrant des signes de psychose, de manie et un attachement émotionnel très fort envers le chatbot. La situation nous dépasse tous.

Suicide via ChatGPT : comment OpenAI compte gérer ?

Les conversations dangereuses sont rares selon OpenAI. La société explique qu’il est difficile de mesurer ces échanges. Pourtant, le compteur hebdomadaire grimpe haut.

Des chercheurs ont déjà mis en garde. Certaines réponses de chatbots entraînent des utilisateurs dans des impasses délirantes. L’IA peut renforcer des idées catastrophiques par politesse algorithmique. Le genre de politesse qui peut coûter la vie.

OpenAI a ainsi décidé de collaborer avec plus de 170 professionnels de santé mentale pour corriger ces dérives. Ces spécialistes ont analysé les réponses du nouveau modèle et constaté une amélioration générale. Les réactions du chatbot seraient plus cohérentes et plus adaptées aux situations dangereuses.

Cela dit, cette attention accrue ne tombe pas du ciel. Un procès vise actuellement OpenAI. Les parents d’un adolescent affirment que leur fils a partagé ses envies suicidaires avec ChatGPT avant de passer à l’acte. La responsabilité juridique d’une IA se pose donc comme un dossier brûlant. Les procureurs généraux de Californie et du Delaware scrutent chaque mouvement de l’entreprise. Leur regard peut bloquer sa restructuration.

Sam Altman assure que son équipe a déjà atténué les pires risques liés à la santé mentale. Une publication récente sur X évoquait des progrès concrets. L’annonce du jour cherche à en donner la preuve. OpenAI se félicite de ces avancées, tout en ouvrant curieusement la porte à des conversations érotiques avec des adultes. Sauver les âmes tourmentées et flirter dans la même mise à jour. Sacré grand écart.

GPT-5, pseudo thérapeute ou nouvelle bombe émotionnelle ?

GPT-5 affiche selon OpenAI des réponses plus « souhaitables » face aux idées suicidaires. L’entreprise parle d’une amélioration de 65 %. Le modèle atteindrait 91 % de conformité aux bonnes pratiques définies par ses propres équipes. GPT-4o restait loin derrière. Les longues conversations posaient problème auparavant. Les garde-fous perdaient en efficacité au fil des messages. OpenAI promet un modèle plus stable dans la durée.

De nouveaux tests évaluent désormais les urgences psychologiques non suicidaires et la dépendance émotionnelle. OpenAI renforce aussi la surveillance des mineurs. Un système de prédiction d’âge doit repérer automatiquement les enfants. Le chatbot appliquera alors des limites plus strictes. Les parents pourront mieux contrôler l’accès.

Bien entendu, tout cela est fragile. Plusieurs réponses de GPT-5 sont encore jugées indésirables par OpenAI. Les abonnés payants ont toujours accès à des modèles plus anciens, donc plus risqués. La sécurité avance en marchant sur un fil, avec le vide en dessous.

- Partager l'article :