Microsoft vient de présenter une structure taillée pour l’ère des modèles géants. Cette super-usine IA relie deux centres situés dans le Wisconsin et à Atlanta avec un réseau optique prévu pour des transferts très rapides.

L’idée est d’unir des sites distants pour qu’ils agissent comme un supercalculateur partagé. Microsoft mise sur cette architecture pour soutenir l’entraînement de modèles de plus en plus lourds. Ceux utilisés par ses partenaires comme OpenAI et son équipe interne de superintelligence.

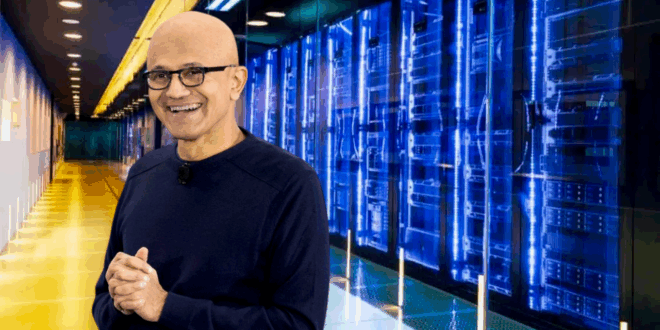

Une super-usine IA, n’est-ce pas impressionnant ?

La nouvelle structure repose sur une idée très concrète : rapprocher les puces pour réduire la latence. Les équipes ont placé les composants sur deux étages très denses afin d’accélérer les échanges internes.

L’ensemble est soutenu par un câblage massif et des systèmes de refroidissement capables d’absorber la chaleur d’un matériel qui travaille sans pause. Ce design permet des calculs en continu, même lors des périodes de forte activité, et réduit les moments d’attente entre chaque tâche.

Le réseau utilisé relie les deux sites sur des milliers de kilomètres avec une fibre optique dédiée. Une partie de cette infrastructure provient d’anciennes acquisitions, et une autre partie a été construite pour ce projet précis.

Les équipes ont équipé ces installations avec des exaoctets de stockage et des millions de cœurs de processeur. Ces ressources sont prévues pour les flux de travail les plus lourds.

Grâce à des protocoles adaptés, Microsoft raccourcit les trajets des données et réduit les délais lors des transferts. Chaque site peut ainsi participer à la même tâche d’entraînement, presque en temps réel.

Pourquoi toute cette manœuvre ?

Ce fonctionnement distribué évite l’inaction de certains GPU pendant que d’autres calculent encore. Microsoft veut maintenir un flux constant pour toutes les unités afin d’utiliser chaque ressource au maximum.

Pour renforcer cette mécanique géante, Microsoft utilise l’architecture Fairwater qui gère les racks à haut débit. Les sites intègrent les unités Nvidia GB200 NVL72, prévues pour des clusters immenses basés sur les puces Blackwell.

Le refroidissement liquide transporte la chaleur vers l’extérieur du bâtiment avant de renvoyer un fluide plus froid. L’entreprise assure que le système consomme très peu d’eau neuve, à part quelques remplacements ponctuels pour le contrôle chimique.

Le site d’Atlanta reprend exactement la configuration du Wisconsin afin de déployer cette recette dans plusieurs régions.

- Partager l'article :