Le film présente un chercheur du MIT qui a découvert des préjugés raciaux et sexistes dans les programmes de reconnaissance faciale. Le documentaire a été projeté pour la première fois durant l'édition 2020 du festival du film de Sundance.

Codes Bias : contexte

Coded Bias suit la chercheuse du MIT Media Lab, Joy Buolamwini, qui a co-écrit en 2018 une étude influente montrant que les programmes de reconnaissance faciale disponibles dans le commerce présentaient de sérieux biais algorithmiques contre les femmes et les personnes de couleur.

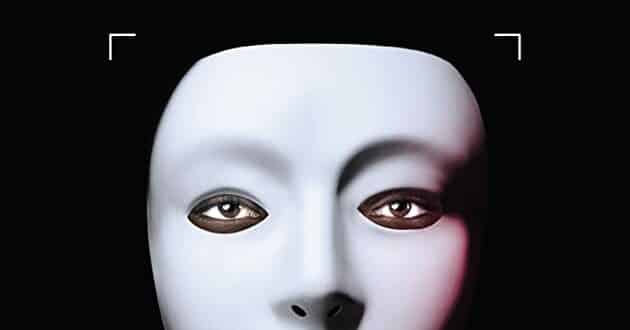

Tout a commencé par une mission, lorsque l'étudiante diplômée de l'époque, a découvert que le programme de reconnaissance faciale qu'elle utilisait ne pouvait pas la reconnaître. Elle ne pouvait le faire fonctionner que si elle portait un masque blanc. Ce n'était pas un hasard. Le problème réside dans les ensembles de données que les programmeurs utilisent pour développer des algorithmes d'apprentissage automatique.

Les systèmes de reconnaissance faciale commencent à apprendre ce que sont les visages à partir d'une vaste collection de photos. Mais si la base de données est principalement constituée de photos d'hommes et de personnes à la peau plus claire, les systèmes présenteront des difficultés à détecter les femmes et les Noirs. Buolamwini a constaté que les services de Microsoft, IBM et Amazon présentaient de type de biais.

Ordures entrant et sortant

Les informaticiens appellent ce phénomène « les ordures entrant et sortant ». En d'autres termes, si vos données d'entrée sont interrompues, celles de la sortie le seront également. Les programmes agissent un peu comme des génies : ils exécuteront exactement les fautes commises par les programmeurs qui doivent particulièrement être prudents avec leur requête.

Et cela va bien au-delà de l'informatique bâclée. La reconnaissance faciale est utilisée par les forces de l'ordre pour la surveillance, les banques et les entreprises qui utilisent par exemple l'intelligence artificielle pour déterminer qui peut obtenir des prêts ou décrocher des entretiens d'embauche. Si ces programmes sont instillés avec des préjugés, cela exacerbe les inégalités existantes.

Vision de la réalisatrice

Shalini Kantayya, la réalisatrice, tisse des histoires montrant les impacts réels d'une intelligence artificielle défectueuse ou contraire à l'éthique. Un enseignant apprécié à Houston est arbitrairement considéré comme insatisfaisant par une évaluation automatisée. Un homme au Royaume-Uni est condamné à une amende à cause d'une identification erronée par le système de reconnaissance faciale qui, même un policier, en admet l'erreur. Les scènes en Chine montrent le potentiel d'une surveillance étatique étendue par le biais du système de crédit social et de la reconnaissance faciale obligatoire. Et la plupart des citoyens ne semblent pas vraiment s'en soucier.

Kantayya a souligné que l'intelligence artificielle fera à nouveau preuve d'éthique une fois que vous l'aurez débarrassé des préjugés raciaux. Après tout, une reconnaissance faciale sans faille pourrait simplement signifier une surveillance plus efficace et invasive. Mais cela est particulièrement gênant lorsque les logiciels existants ne sont pas réglementés, testés et développés par des entreprises commerciales à but lucratif.

- Partager l'article :