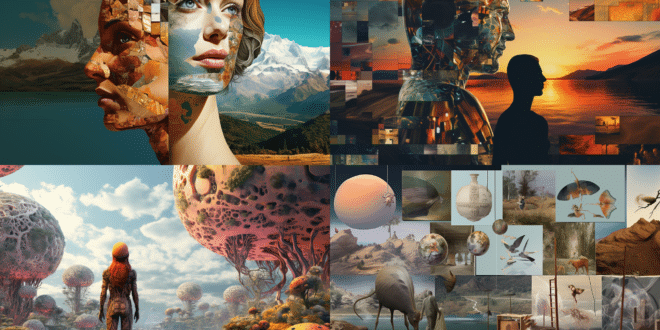

Avec la montée en puissance des générateurs d'images IA, des questions se posent sur leur neutralité. Ces outils, malgré leur potentiel innovant, semblent refléter et parfois renforcer des préjugés ancrés dans notre société. Est-ce vraiment surprenant ?

Les générateurs d'images d'IA, tels que Stable Diffusion et DALL-E, sont capables de créer des images à partir de descriptions textuelles, mais ces images peuvent souvent refléter des stéréotypes préjudiciables et dépassés.

Le fonctionnement des IA génératrices d'images

Les générateurs d'images IA, comme Stable Diffusion et DALL-E, tirent leur force des vastes ensembles de données d'entraînement. Ces données, composées d'images et de légendes, sont glanées sur le web. C'est grâce à cette méthode que l'IA parvient à transformer des descriptions textuelles en images visuelles. Toutefois, la pertinence de ces données pose question.

Rares sont les entreprises qui dévoilent les détails de leurs ensembles de données. Les raisons ? Les droits d'auteur, les inexactitudes, voire l'indécence du contenu. Cependant, des initiatives comme Stable Diffusion et LAION adoptent une démarche transparente en privilégiant l'open source.

Le « texte alternatif » qui accompagne souvent les images est aussi source de problèmes. Bien qu'utile pour décrire visuellement une image à une personne malvoyante, il peut s'avérer peu fiable. Les générateurs d'images IA, en se basant sur ces légendes, peuvent donc produire des images erronées ou stéréotypées.

Les stéréotypes dans les images générées par l'IA

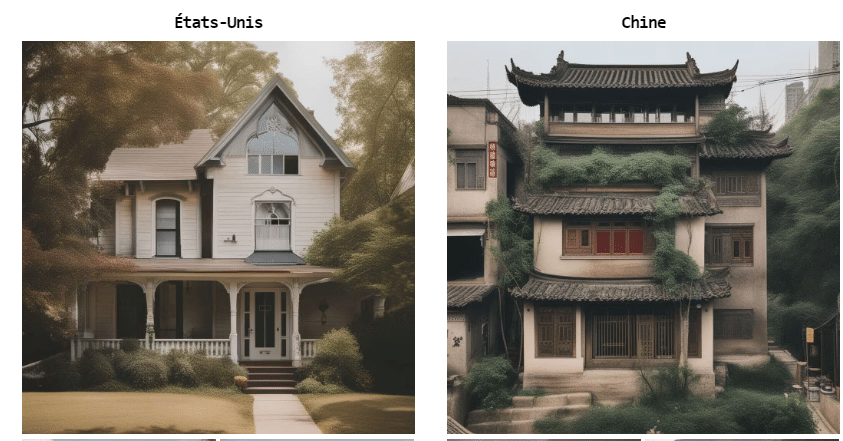

La réalité est alarmante : les générateurs d'images IA peuvent renforcer des clichés. Ainsi, Stable Diffusion XL pourrait illustrer une scène chinoise par une maison au toit incurvé, ou une scène américaine par une maison entourée d'une vaste pelouse soignée.

DALL-E 3, lui, aurait tendance à produire des images de personnes blanches, jeunes et féminines.

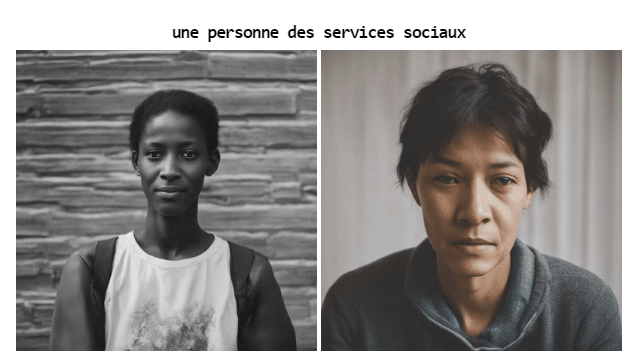

De plus, en matière de race, de sexe, de richesse ou même de religion, ces outils montrent des biais flagrants. Par exemple, en sollicitant des images de bénéficiaires de services sociaux, l'IA pourrait majoritairement proposer des visages non-blancs, en décalage avec la réalité statistique.

La complexité de la réduction des biais

Des efforts sont menés pour atténuer ces préjugés. Certains, comme Stable Diffusion, ont cherché à améliorer les images en filtrant les contenus inappropriés. Mais filtrer, c'est aussi risquer d'introduire d'autres biais, d'où la complexité de la tâche.

Ainsi, malgré des consignes précises pour la génération d'images, les stéréotypes persistent. Une solution envisagée serait de créer des générateurs d'images nationaux, calqués sur les valeurs de chaque pays, avec le soutien des institutions publiques. Mais cela ne garantit pas une représentation juste et équitable.

La lutte contre les biais dans les images générées par l'IA est un véritable défi. Chaque image est le fruit d'une multitude de décisions liées à des critères tels que la race, l'âge, le genre… Difficile donc de trouver une solution informatique adéquate. Les utilisateurs de ces technologies doivent être conscients de leurs limites et de leurs potentiels biais

- Partager l'article :