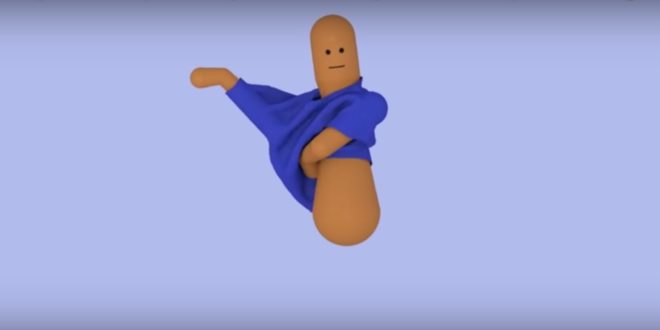

Les chercheurs de Google Brain et du Georgia Institute of Technology ont appris à un personnage virtuel doté d’intelligence artificielle à s’habiller seul grâce au Machine Learning. Une prouesse bien plus impressionnante qu’il n’y paraît.

Pour la plupart d’entre nous, le fait de s’habiller le matin est un automatisme. Une tâche rébarbative du quotidien, à laquelle on s’attelle sans même y penser. Nous y sommes si habitués que l’on ne prête plus attention aux multiples étapes et aux nombreux mouvements que ce rituel implique.

En réalité, mettre ses vêtements requiert un grand nombre d’interactions physiques entre un individu et ses habits. Par exemple, pour enfiler un T-shirt, il est nécessaire de le tirer, de passer sa main dans l’ouverture, puis de pousser son bras dans la manche.

Ces interactions sont principalement guidées par le sens du toucher. En effet, les vêtements répondent aux moindres changements de position du corps en se froissant ou en collant au corps. Ainsi, créer une animation d’un personnage qui s’habille se révèle complexe.

Afin de relever ce défi, les chercheurs de Google Brain et du Georgia Institute of Technology se sont associés pour apprendre à une intelligence artificielle de type réseau de neurones à s’habiller en partant de zéro. Grâce au Machine Learning, ces scientifiques sont parvenus à simuler une par une toutes les étapes du processus.

Google : l’IA a répété chaque mouvement des milliers de fois pour apprendre à s’habiller

Le personnage virtuel doté d’IA a répété chaque étape des milliers de fois, en recevant à chaque fois un signal de récompense ou de pénalité pour lui indiquer si ses efforts portent dans la bonne direction ou s’il s’éloigne de son objectif. Chaque fois qu’un changement positif était détecté dans le comportement du personnage, le réseau de neurones a été mis à jour par les chercheurs pour augmenter les chances que ces changements se reproduisent dans le futur. Ainsi, le personnage virtuel a pu apprendre comment réussir chaque tâche.

Cette expérience pourrait permettre d’améliorer la façon dont les personnages qui s’habillent sont animés dans les films d’animation ou les jeux vidéo par exemple. Toutefois, la méthode pourrait aussi être à nouveau utilisée pour l’animation de diverses interactions nécessitant plusieurs étapes complexes.

Elle pourrait aussi être utilisée pour apprendre à des robots à s’entraîner à effectuer des tâches dans le monde virtuel pour ensuite les reproduire dans le monde réel. Les scientifiques à l’origine de cette étude travaillent actuellement avec d’autres chercheurs du Georgia Tech Healthcare Robotics pour développer des robots d’assistance capables d’aider des personnes à s’habiller.

Les chercheurs Alexander Clegg, Wenhao Yu, Greg Turk et Karen Liu du Georgia Tech Institute et le chercheur Jie Tan de Google Brain présenteront leurs travaux lors du SIGGRAPH Asia 2018 qui prendra place à Tokyo du 4 au 7 décembre 2018.

- Partager l'article :