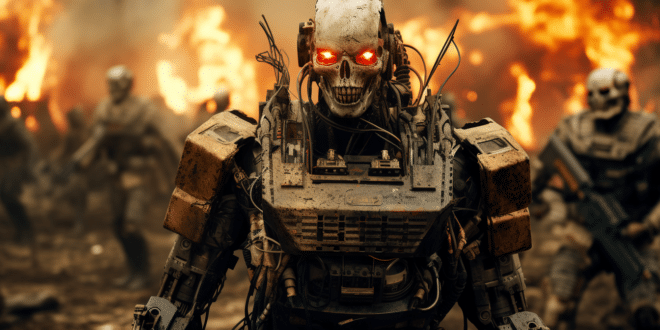

Le 10 janvier, OpenAI a réécrit les règles de l'engagement IA. En supprimant les restrictions sur l'usage de ChatGPT dans la guerre et le cybercrime, un nouveau chapitre inquiétant s'ouvre. Quels sont les dangers potentiels de cette décision ?

Auparavant, les règles d'OpenAI étaient claires, interdisant tout usage nuisible. Désormais, la formulation est plus vague. L'entreprise se limite à mentionner que l'IA ne doit pas être utilisée pour « nuire à soi-même ou à autrui ». Cela laisse place à diverses interprétations, notamment en ce qui concerne les activités militaires. Une telle ambigüité juridique pourrait ouvrir la porte à des utilisations controversées de l'IA.

Les implications alarmantes de la nouvelle politique d'utilisation de ChatGPT d'OpenAI

La suppression par OpenAI de clauses spécifiques interdisant l'usage de son IA pour « développer des armes » ou « créer des logiciels malveillants » est alarmante. En effet, cette modification suggère une acceptation tacite de tels usages. Cela pourrait signifier que des acteurs mal intentionnés pourraient exploiter ChatGPT à des fins néfastes.

D'autre part, le risque de cybercriminalité s'intensifie. ChatGPT, avec ses capacités avancées, pourrait aider à coder des logiciels malveillants ou à orchestrer des cyberattaques. Cette facilitation de la cybercriminalité représente une menace pour la sécurité individuelle et nationale.

Selon Sarah Myers West de l'institut AI Now, les termes flous utilisés par OpenAI soulèvent des questions sur l'application de la loi. Le conflit entre Israël et le Hamas, où l'IA a été utilisée, illustre le potentiel destructeur de ces technologies.

The Register souligne également la disparition de la notion de création de malware dans les nouvelles règles. Cela pourrait encourager l'utilisation de ChatGPT pour développer des logiciels malveillants.

Les répercussions éthiques et sociétales

Évidemment, l'ambiguïté des nouvelles conditions d'utilisation d'OpenAI soulève des questions éthiques. En effet, l'absence de directives claires pourrait conduire à des abus. Les acteurs mal intentionnés pourraient se prévaloir de ces lacunes pour justifier leurs actions. Ce flou juridique met en lumière le besoin urgent de réglementations plus strictes dans le domaine de l'IA.

Ce n'est pas tout, la responsabilité d'OpenAI est également en jeu. En tant que développeur de l'une des IA les plus avancées, l'entreprise a le devoir d'encadrer son utilisation. Et, plus important encore, la prévention des usages malveillants devrait être une priorité absolue.

En outre, cette modification des conditions d'utilisation pourrait avoir un impact significatif sur la perception publique d‘OpenAI et de ChatGPT. Sans aucun doute, la confiance des utilisateurs pourrait être ébranlée, craignant que leurs interactions avec l'IA ne soient exploitées à des fins néfastes.

De manière intéressante, ces modifications des conditions d'utilisation ont coïncidé avec le lancement de la boutique en ligne d'OpenAI le 10 janvier. Cette boutique permet aux utilisateurs de créer des robots conversationnels personnalisés basés sur le modèle de langage GPT-4 et de les commercialiser.

- Partager l'article :