En plein essor, le marché du Big Data évolue en permanence, à grande vitesse et dans plusieurs directions. Des technologies de stockage, des outils analytiques, ou encore des applications diverses et variées viennent sans cesse étoffer cette nouvelle facette de l'entrepreneuriat. En parallèle, de nouveaux défis se dressent pour les acteurs de cette évolution. Au travers de cet article, découvrez les 10 principaux changements à prévoir pour le Big Data en 2016.

Hadoop continue sa progression

Depuis 2005, Hadoop n'a cessé d'évoluer et de gagner en popularité jusqu'à s'imposer au sein des entreprises pour le stockage et l'analyse des données en vue d'une stratégie Big Data. Estimée à 1,5 milliard de dollars en 2012, la valeur du framework atteindrait 50,2 milliards de dollars en 2020 selon Allied Market Research. En cette année 2016, Hadoop pourrait connaître une croissance de plus de 100%.

Un récent sondage mené auprès de 2200 utilisateurs révèle que seuls 3% envisagent de restreindre leur usage du framework dans l'année à venir. 76% prévoient de s'en servir encore davantage dans les trois prochains mois. Près de la moitié des entreprises qui ne l'utilisent pas encore s'apprêtent à le faire.

Le succès d'Hadoop est proportionnel à l'intérêt croissant pour la science des données de la part des entreprises. Face au manque de data scientists, ces entreprises sont à la recherche d'outils analytiques abordables dont Hadoop fait partie.

Cette popularité croissante entraîne également la démocratisation d'outils liés au fameux framework. Par exemple, Apache Sentry sécurise les données et métadonnées stockées sur les clusters Hadoop grâce à un système d'autorisations granulaires.

Il en va de même pour les technologies permettant d'accélérer son traitement des données. Les systèmes comme Cloudera Impala, AtScale, Actian Vector ou Jethro Data permettent de retrouver la vitesse de traitement de données de la Business Intelligence d'antan, et notamment le retour du cube OLAP.

Apache Spark prend l'ascendant sur Hadoop

Initialement simple composant de l'écosystème Hadoop, le moteur de traitement de données Apache Spark s'émancipe et prend à peu l'ascendant sur l'éléphant jaune. Spark doit principalement son succès à sa vitesse de traitement, jusqu'à 100 fois supérieure à celle d'Hadoop. Selon son créateur Matei Zaharia, il s'agit désormais de la plus grande plateforme open source de traitement Big Data. Elle est utilisée par des entreprises de prestige telles que Goldman Sachs.

Selon Monte Zweben, CEO de Splice Machine, 9 sur 10 projets Hadoop de 2016 seront liés à Spark. À ses yeux, la vitesse du moteur le rend plus naturel, plus mathématique et plus confortable pour les programmeurs. Pour Manish Sood, CEO de Reltio, de nouvelles solutions aptes à remplacer Hadoop comme Spark ou Drill devraient voir le jour cette année.

Le stockage des données sur le cloud

De plus en plus d'entreprises choisissent d'entreposer leurs données sur le cloud, et cette tendance devrait se poursuivre en 2016. Selon IDC, les solutions Big Data et les outils analytiques basés sur le cloud connaîtront une croissance trois fois plus rapide que celle des plateformes physiques.

Au travers du cloud, les MPP Data Warehouses font leur retour avec des solutions telles que Amazon Redshift, Google BigQuery, Microsoft Azure SQL Data Warehouse, Teradata, ou encore Snowflake, vainqueur du Strata + Hadoop World 2015 Startup Showcase.

Le cloud présente notamment l'avantage de permettre aux entreprises d'échelonner plus facilement l'espace de stockage disponible en fonction de leurs besoins. Cependant, comme l'expliquent les vice-présidents Big Data d'Oracle Neil Mendelson et Jeff Pollock, les entreprises multinationales devront opter pour un stockage hybride afin de répondre aux normes légales des pays dans lesquels elles s'implantent. Un échantillon de données devra être stocké dans des data centers locaux, tandis que la majeure partie sera entreposée sur le cloud.

Selon Roger Levy, vice-président des produits chez MariaDB, des solutions devraient voir le jour en 2016 pour assister les entreprises dans la migration de leurs données vers ces stockages hybrides. Pour l'heure, le transfert peut s'avérer difficile et coûteux.

L'internet des objets, future « killer app » du Big Data

Pour de nombreux analystes, le cloud et l'internet des objets seront bientôt la raison d'être du Big Data. Les données collectées en temps réel par les milliards d'objets connectés en circulation devront être transférées sur le cloud en temps réel et directement traitées. Selon Eric Frenkiel, CEO de MemSQL, l'internet des objets sera prochainement incorporé à l'Internet Industriel, concept qui regroupe pour le moment le big data, le machine learning, et les communications M2M.

Les données issues des objets connectés et de leurs capteurs seront streamées et continuellement analysées en temps réel, grâce à de nouvelles technologies dont la croissance devrait s'élever à 30% par an dès 2016 et pour les cinq prochaines années d'après les prédictions d'IDC. Les industries de l'énergie, de la santé ou encore de l'agriculture pourront ainsi combiner les données traitées en temps réel et les données historiques pour prendre des décisions plus rapidement.

Analyses prédictives et apprentissage automatique

Les applications d'analyses prédictives et d'apprentissage automatique devraient connaître en 2016 une croissance accélérée selon IDC. Elles progresseraient 65% plus vite que les outils analytiques non prédictifs. Aux yeux des VP Big Data d'Oracle, c'est cette année que les technologies d'intelligence artificielle telles que le Machine Learning, le Natural Language Processing et les Property Graphs seront confrontées aux défis du Big Data.

Pour Monte Zweben, l'essor du Machine Learning nécessitera la mise en place de base de données clé en main facilitant la création de modèles prédictifs pour les développeurs, afin de compenser le manque de personnel qualifié dans ce domaine pointu.

Pour l'heure, selon Roger Levy, les entreprises peuvent se tourner vers les services autonomes tels que Microsoft Azure ML Studio, Google Prediction API, Amazon Machine Learning, ou encore IBM Watson Analytics. Ces solutions facilitent l'accès au Machine Learning.

La sécurité des données, un enjeu majeur

Aux yeux de David Cass, responsable de la sécurité des systèmes d'informations chez IBM Cloud, les cyberattaques vont continuer à croître en 2016. Afin de protéger les données, les constructeurs d'objets connectés devront redoubler d'efforts et d'inventivité. Un nouveau framework de normes internationales pourrait voir le jour.

Pour les VP Big Data d'Oracle, les consommateurs et les gouvernements sont de plus en plus avertis concernant les risques de voir leurs données dérobées et exigent davantage de gages de sécurité. Pour protéger les données, les entreprises vont recourir à un système de classification pour regrouper les datas par groupe. Chaque catégorie sera rigoureusement réglementée concernant les droits d'accès et de modification.

D'après Roger Levy, un cryptage natif permettra de protéger les données stockées, et un cryptage SSL assurera leur sécurité durant les transferts entre applications. Comme l'explique Scott Zoldi, Chief Analytics Officer chez FICO, les entreprises les moins sélectives et les plus gourmandes en termes de données s'exposent à davantage de risques et à des conséquences désastreuses.

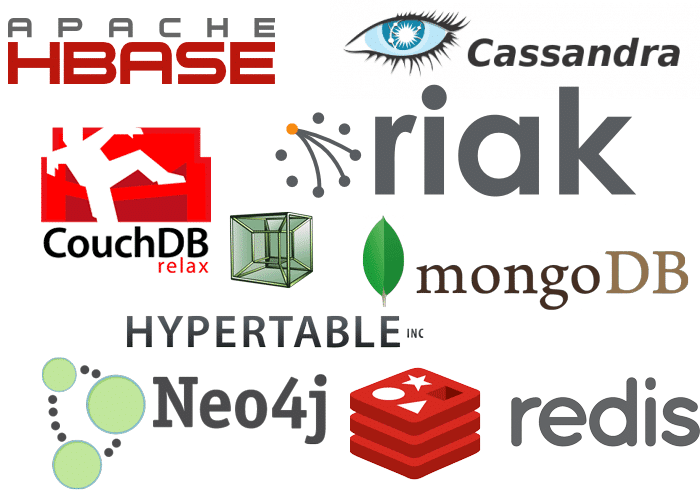

L'essor des systèmes de gestion de bases de données NoSQL

Les systèmes de gestion de bases de données SQL sont de plus en plus remplacés par des systèmes NoSQL, généralement associés aux données non structurées. Face à la réalité du Big Data, de tels systèmes se montrent plus pertinents. Le dernier Magic Quadrant de Gartner pour les Systèmes Opérationnels de Gestion de Base de données met en lumière l'ascension de fournisseurs NoSQL comme MongoDB, DataStax, Redis Labs, MarkLogic et Amazon Web Services avec DynamoDB, au détriment des anciens ténors Oracle, IBM, Microsoft et SAP.

Paradoxalement, le CEO d'Algebraix Data Charles H. Silver souligne que le SQL redevient peu à peu le langage de prédilection pour ces systèmes NoSQL. Pour cause, de nombreux informaticiens sont dotés de trente ans d'expérience en SQL et l'utilisent plus efficacement pour les requêtes, même sur des systèmes NoSQL.

En 2016, certaines entreprises préfèrent d'ailleurs combiner JSON, SQL et NoSQL pour leurs bases de données, grâce à des outils comme Cassandra. C'est ce qu'explique Roger Levy.

Le self-service est de plus en plus en vogue

Les outils de préparation de données en self-service sont de plus en plus populaires. Des firmes comme Alteryx, Trifacta, Paxata, Lavastorm ou encore Informatica et son Rev innovent pour proposer des solutions efficaces et intuitives.

IDC souligne par exemple la demande croissante d'outils d'analyse de données visuels. En 2016, ces solutions devraient connaître une croissance 2,5 fois plus rapide que le reste du marché de la Business Intelligence. Oracle prédit que cette accessibilité accrue aux données pourrait provoquer une nouvelle vague d'innovation.

Une importante réduction des coûts d'analyse des données

Selon Charles H. Silver, l'essor du Big Data a provoqué de nombreuses innovations de la part des entreprises afin de réduire les coûts des analyses de données. Si ces prix n'ont eu de cesse de diminuer ces dernières années, c'est en 2016 qu'ils atteindront un cap suffisamment bas pour permettre à toutes les tailles de firmes de traiter leurs données.

Le manque de personnel qualifié persiste

Les entreprises peinent toujours à trouver des employés qualifiés pour l'analyse, le traitement et l'interprétation des données. Selon IDC, aux États-Unis, il y aura 181 000 profils compétents en 2018 tandis que les entreprises auront 5 fois plus de postes à pourvoir dans le domaine du Big Data.

En conclusion, 2016 apporte des solutions au besoin de traiter les données rapidement et facilement. Le progrès soulève de nouvelles problématiques, et les entreprises tentent de les résoudre en temps réel. Pour plusieurs analystes, cette année sera également celle de l'entrée du Big Data dans le champ du réel.

- Partager l'article :