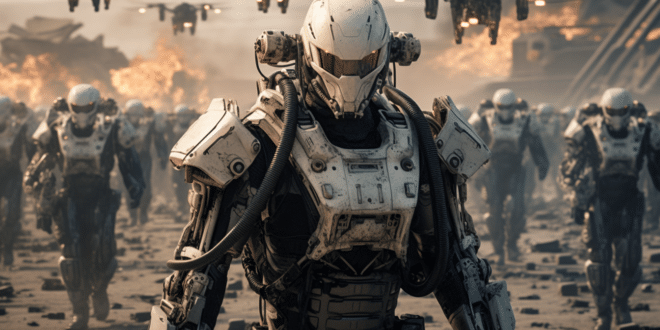

Le développement et le déploiement de systèmes d'armes IA létales autonomes offrent des avantages indéniables au combat. Le Pentagone en est convaincu et multiplie les projets à déploiement rapide. Néanmoins, il faut prendre conscience d'une chose. Les progrès technologiques ont entraîné l'émergence de machines capables de tuer des humains sans contrôle humain.

Armes IA létales autonomes : le Pentagone accélère les décisions

Le Pentagone entend bien accélérer le développement et le déploiement des armes IA autonomes, y compris les armes létales désormais connues sous le terme robots tueurs. Le Pentagone a notamment l'intention de mettre en service plusieurs milliers de véhicules autonomes dotés de l'IA, relativement peu coûteux, d'ici 2026.

Au mois d'août dernier, la Défense américaine parlait de « galvaniser les progrès dans la transition trop lente de l'innovation militaire américaine vers des plateformes petites, intelligentes, bon marché et nombreuses ». Ce sont les mots de Kathleen Hicks, la secrétaire adjointe à la Défense.

Cette décision est entre autres motivée par la rivalité avec la Chine. L'arsenal chinois ne se contente pas de croître, mais il se diversifie et se modernise. Le Pentagone veut suivre le rythme. Toutefois, dans cette quête de la suprématie en matière d'intelligence artificielle, les États-Unis estiment avoir un avantage sur la Chine : ils conçoivent les puces les plus avancées utilisées pour entraîner l'IA.

Les progrès rapides de l'intelligence artificielle et l'utilisation intensive de drones dans les conflits en Ukraine et au Moyen-Orient se conjuguent également pour rendre la course aux armements IA encore plus urgente. Le Pentagone évoque aujourd'hui un portefeuille comptant plus de 800 projets non classifiés liés à l'IA, dont la plupart sont encore en test.

Défendre l'espace et soutenir la logistique militaire

Selon le Pentagone, la Défense américaine veut également accélérer la course aux armements et aux outils alimentés par IA pour défendre l'espace contre les menaces potentielles. Un prototype opérationnel appelé Machina utilisé par l'US Space Force (USSF) surveille de manière autonome plus de 40 000 objets dans l'espace.

Cette opération permet de collecter des données que l'IA viendra analyser pour suivre les objets potentiellement suspects. Un autre projet de USSF vise à exploiter l'IA pour détecter les lancements imminents de missiles adverses, selon le colonel Wallace Turnbull de l'US Space Force.

Parallèlement, du côté des forces aériennes, les pouvoirs prédictifs de l'IA aident l'Air Force à entretenir sa flotte en anticipant les besoins de maintenance de plus de 2 600 avions. Selon Tom Siebel, PDG de C3 AI (une société technologique américaine qui travaille avec l'Air Force), les modèles d'apprentissage automatique identifient les pannes possibles avant qu'elles ne se produisent.

Le Pentagone veut même s'assurer de la bonne santé de ses soldats grâce à l'IA. La Défense travaille sur un projet pilote portant sur le tracking de la forme physique des soldats grâce à l'IA. Selon le major Matt Visser de l'armée de l'air américaine, la modélisation prédictive et l'IA contribuent à réduire les blessures et à augmenter les performances.

Le Pentagone, les armes IA et la question de l'éthique

Au-delà des outils conçus pour appuyer les humains, les armes autonomes alimentées par l'IA posent de réels problèmes éthiques. Les systèmes d'armes autonomes sont des dispositifs mortels qui ont été habilités par leurs créateurs humains à surveiller leur environnement, à identifier les cibles ennemies potentielles et à choisir de manière indépendante d'attaquer ces cibles sur la base d'algorithmes sophistiqués.

Le Département américain de la Défense décrit un système d'armes autonome comme « un système d'armes qui, une fois activé, peut sélectionner et engager des cibles sans autre intervention d'un opérateur humain ». L'autonomie « fait référence à un spectre d'automatisation dans lequel une prise de décision indépendante peut être adaptée à une mission spécifique ».

Une course à l'autonomie présente un danger particulier. Les conséquences de l'investissement dans des machines dotées d'une intelligence et d'un pouvoir de décision accrus sont largement inconnues et pourraient s'avérer catastrophiques. Les systèmes qui ne fonctionnent pas comme annoncé ou qui tuent les forces alliées sont tout aussi inquiétants.

Les autorités américaines insistent sur le fait que les opérateurs humains seront toujours impliqués lorsque des décisions de vie ou de mort sont prises par des robots armés. Néanmoins, il est vrai que la trajectoire de la technologie conduit à un rôle humain de plus en plus réduit. Cela pose des défis évidents. Les défenseurs des droits humains et les régulateurs continuent de crier au scandale !

- Partager l'article :