Une Confusion Matrix (matrice de confusion) ou tableau de contingence est un outil permettant de mesurer les performances d’un modèle de Machine Learning en vérifiant notamment à quelle fréquence ses prédictions sont exactes par rapport à la réalité dans des problèmes de classification.

Le Machine Learning consiste à nourrir un algorithme à l’aide de données pour permettre à un ordinateur d’apprendre à effectuer une tâche spécifique. Afin de mesurer les performances d’un modèle de Machine Learning, on utilise généralement la Confusion Matrix ou matrice de confusion, aussi appelée tableau de contingence.

Confusion Matrix : définition

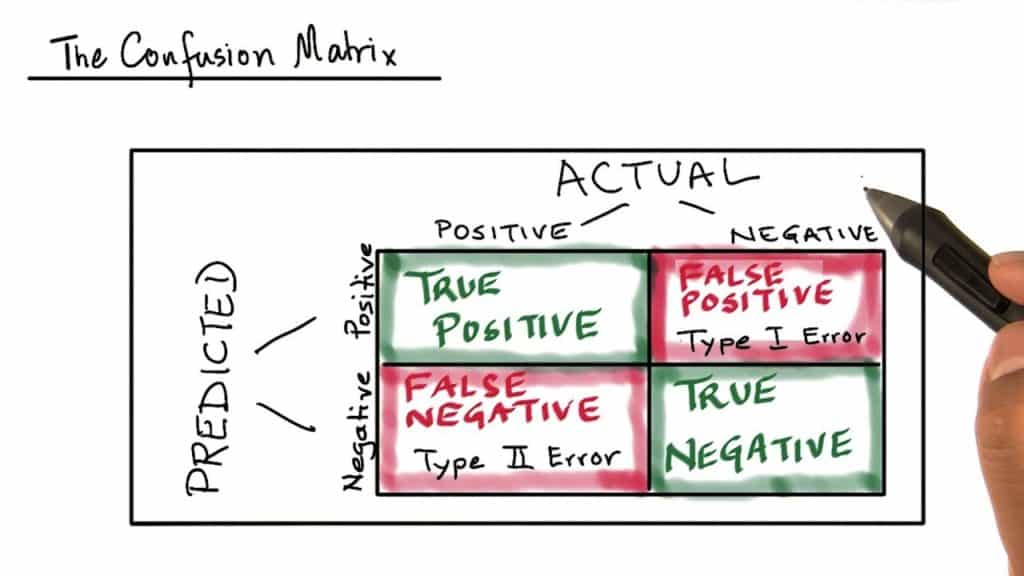

Une Confusion Matrix est un résumé des résultats de prédictions sur un problème de classification. Les prédictions correctes et incorrectes sont mises en lumière et réparties par classe. Les résultats sont ainsi comparés avec les valeurs réelles.

Cette matrice permet de comprendre de quelle façon le modèle de classification est confus lorsqu’il effectue des prédictions. Ceci permet non seulement de savoir quelles sont les erreurs commises, mais surtout le type d’erreurs commises. Les utilisateurs peuvent les analyser pour déterminer quels résultats indiquent comment les erreurs sont commises.

Outre le Machine Learning, les matrices de confusion sont aussi utilisées dans le domaine des statistiques, du Data Mining et de l’intelligence artificielle. De manière générale, elles permettent d’analyser des données statistiques plus rapidement et de rendre les résultats plus simples à déchiffrer via la Data Vizualisation. Elles offrent l’opportunité d’analyser les erreurs dans les statistiques, le forage de données, ou même les examens médicaux.

Comment calculer une Confusion Matrix ?

Pour calculer une matrice de confusion, il est nécessaire de disposer d’un ensemble de données de test (test dataset) ou d’un ensemble de données de validation (validation dataset) avec les valeurs de résultat attendues. On fait ensuite une prédiction pour chaque ligne du » test dataset « .

A partir des résultats escomptés et des prédictions, la matrice indique le nombre de prédictions correctes pour chaque classe et le nombre de prédictions incorrectes pour chaque classe organisées en fonction de la classe prédite. Chaque ligne du tableau correspond à une classe prédite, et chaque colonne correspond à une classe réelle.

Dans les lignes sous les classes réelles, les prédictions ou les résultats sont inscrits. Ces résultats peuvent être l’indication correcte d’une prédiction positive comme » vraie positive » (true positive) et d’une prédiction négative comme » vraie négative » (true negative), ou une prédiction positive incorrecte comme » fausse positive » (false positive) et une prédiction négative incorrecte comme » fausse négative » (false negative).

L’avantage de ces matrices est qu’elles sont très simples à lire et à comprendre. Elles permettent de visualiser très rapidement les données et les statistiques afin d’analyser les performances d’un modèle et d’identifier les tendances qui peuvent aider à modifier les paramètres. Pour les problèmes de classification avec trois classes ou plus, il est aussi possible d’utiliser une Confusion Matrix en ajoutant des lignes et des colonnes.

Comprendre les terminologies de la Confusion Matrix

Pour bien comprendre le fonctionnement d’une matrice de confusion, il convient de bien comprendre les quatre terminologies principales : TP, TN, FP et FN. Voici la définition précise de chacun de ces termes :

- TP (True Positives) : les cas où la prédiction est positive, et où la valeur réelle est effectivement positive. Exemple : le médecin vous annonce que vous êtes enceinte, et vous êtes bel et bien enceinte.

- TN (True Negatives) : les cas où la prédiction est négative, et où la valeur réelle est effectivement négative. Exemple : le médecin vous annonce que vous n’êtes pas enceinte, et vous n’êtes effectivement pas enceinte.

- FP (False Positive) : les cas où la prédiction est positive, mais où la valeur réelle est négative. Exemple : le médecin vous annonce que vous êtes enceinte, mais vous n’êtes pas enceinte.

- FN (False Negative) : les cas où la prédiction est négative, mais où la valeur réelle est positive. Exemple : le médecin vous annonce que vous n’êtes pas enceinte, mais vous êtes enceinte.

https://www.youtube.com/watch?v=bgyN3RO2ICo

- Partager l'article :