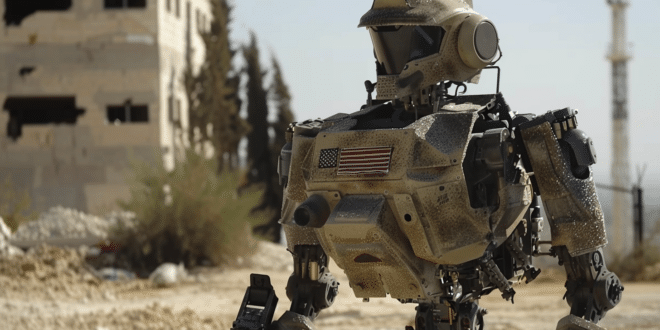

L'utilisation de l'intelligence artificielle dans les armées, surtout pour les armes autonomes, inquiète beaucoup. En particulier, tester ces robots tueurs à Gaza représente un sérieux défi humanitaire.

L'intégration de l'IA dans l'armement par le ministère américain de la Défense et ses sous-traitants soulève d'importantes préoccupations. En effet, le développement de systèmes d'armes capables de fonctionner de manière autonome et d'administrer une force létale sans intervention humaine directe présente des risques.

On cite aussi des implications tant éthiques que technologiques. Car oui, ce développement a été critiqué pour sa potentialité à déshumaniser les conflits. Il faciliterait alors les massacres de masse.

Les risques éthiques et légaux des armes autonomes

Les robots tueurs sont aujourd'hui sur le point de prendre des décisions sans intervention humaine. Cela introduit un risque significatif d'erreurs, dont la sélection incorrecte de cibles pouvant mener à des pertes civiles injustifiées. Jessica Wolfendale souligne une complexité de la responsabilité dans ce contexte. L'absence d'intervention humaine directe dans la prise de décision rend effectivement complexe l'attribution de responsabilité pour les actions de la machine.

Malgré les risques, les politiques existantes du Pentagone ne prohibent pas explicitement le déploiement d'armes autonomes. C'est pourquoi, le rapport de Public Citizen critique cette approche. D'une part, il pointe du doigt les insuffisances dans l'encadrement éthique et légal des armes autonomes. D'autre part, il souligne également les dangers de leur utilisation en termes de violation des droits humains et des principes du droit international.

Récemment, le Pentagone a émis des directives dont l'objectif cherche à encadrer l'utilisation de l'IA dans les systèmes d'armes. Ces instructions promettent, certes, une conformité avec les principes éthiques. Néanmoins, des critiques, telles que Human Rights Watch et la Harvard Law School International Human Rights Clinic, ont relevé des failles importantes dans ces politiques. Il existerait une possibilité d'outrepasser certaines procédures en cas de « besoin militaire urgent ».

Les questions éthiques concernant l'utilisation des robots tueurs en conflit

Les débats sur l'éthique de l'utilisation de l'IA dans les conflits militaires expriment une tendance à déshumaniser l'adversaire, indépendamment de la technologie utilisée. Jeremy Moses nous rappelle que cette déshumanisation précède l'utilisation des armes. Il souligne, entre autres, que la responsabilité ultime des actions militaires repose sur les décideurs humains, non sur la technologie elle-même.

Puis vient Gaza qui est cité comme un exemple. L'utilisation de robots militaires et d'autres technologies d'intelligence artificielle y a été expérimentée. Ces technologies, bien qu'elles puissent être présentées comme des moyens de réduire les pertes humaines, posent des questions éthiques profondes sur la manière dont elles sont utilisées pour rationaliser ou justifier les actions militaires.

Alors que l'intégration de l'IA dans les armées avance rapidement, les débats éthiques et les préoccupations en matière de responsabilité restent au premier plan. La nécessité d'un cadre légal et éthique robuste est impérative. C'est le seul moyen d'encadrer l'utilisation de telles technologies, sachant que l'innovation ne doive pas précéder les principes fondamentaux des droits humains et du droit de la guerre.

- Partager l'article :