Google dévoile VideoPoet ! Une incroyable IA générative de vidéos qui repose sur les LLM (larges modèles de langage) au même titre que Bard ou ChatGPT. Cette approche innovante lui permet notamment de représenter le mouvement ou d'éditer une vidéo à l'aide de prompts textuels ! Découvrez son fonctionnement et les exemples impressionnants partagés par les chercheurs…

Après la vague d'outils d'IA générative d'images comme MidJourney, DALL-E ou Stable Diffusion, la prochaine étape est celle des générateurs de vidéos. Plusieurs solutions convaincantes ont déjà vu le jour, telles que Runway ou Meta Make-a-Video.

Toutefois, l'un des points faibles des IA déjà existantes et la capacité à produire de larges mouvements cohérents. Même les meilleurs modèles se contentent de générer de petits mouvements, car les mouvements plus larges présentent des artefacts clairement visibles.

Afin de surmonter cette limite, Google vient de lancer VideoPoet : un LLM (large modèle de langage) capable de créer des vidéos à partir de texte et d'images, ou même de modifier le style ou de compléter une vidéo existante.

Il est par exemple possible d'ajouter des détails à l'intérieur de la vidéo (inpatinting) ou d'étendre son cadre (outpainting).

Pour la stylisation, le modèle se base sur une autre vidéo représentant la profondeur et le flux optique pour le mouvement et peint du contenu pour produire le style demandé via prompt.

Un seul LLM pour la création de vidéo et d'audio à partir de texte ou d'image

Contrairement aux outils existants, VideoPoet ne repose pas sur la technologie de diffusion comme Image Video (l'autre générateur de vidéos créé par Google).

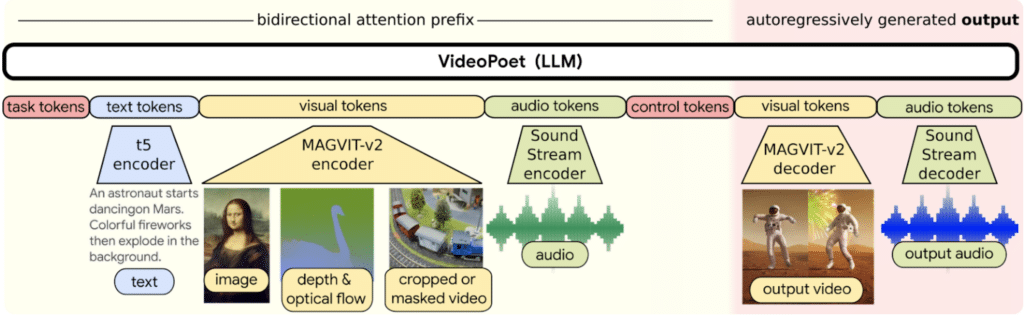

Plutôt que de s'appuyer sur différents composants entraînés séparément et spécialisés chacun sur une tâche, toutes les capacités de génération de vidéo ont été intégrées dans un seul LLM.

Cette IA est capable de prendre du texte en guise d'input pour guider la génération pour le text-to-video, l'image-to-video, le video-to-audio, la stylisation ou les tâches d'outpainting.

L'un des avantages majeurs de l'utilisation des LLM pour l'entraînement est qu'il est possible de réutiliser les améliorations d'efficacité introduites par l'infrastructure d'entraînement des LLM existante.

Cependant, les LLM reposent sur des tokens discrets et cela peut compliquer la génération de vidéos. Il existe heureusement des « tokenizers » audio et vidéo permettant d'encoder les clips audio et vidéo sous forme de tokens discrets. Ils peuvent ensuite être convertis à nouveau vers la représentation originale.

Ainsi, VideoPoet entraîne un modèle de langage auto-régressif à apprendre les modalités de vidéos, d'image, d'audio et de texte via l'utilisation de multiples tokenizers. Ceci inclut MAGVIT V2 pour la vidéo et l'image, et SoundStream pour l'audio.

Dès que le modèle génère des tokens conditionnés sur un contexte, ils peuvent être à nouveau convertis en une représentation visible à l'aide des décodeurs.

Que vaut VideoPoet face aux autres générateurs de vidéos ?

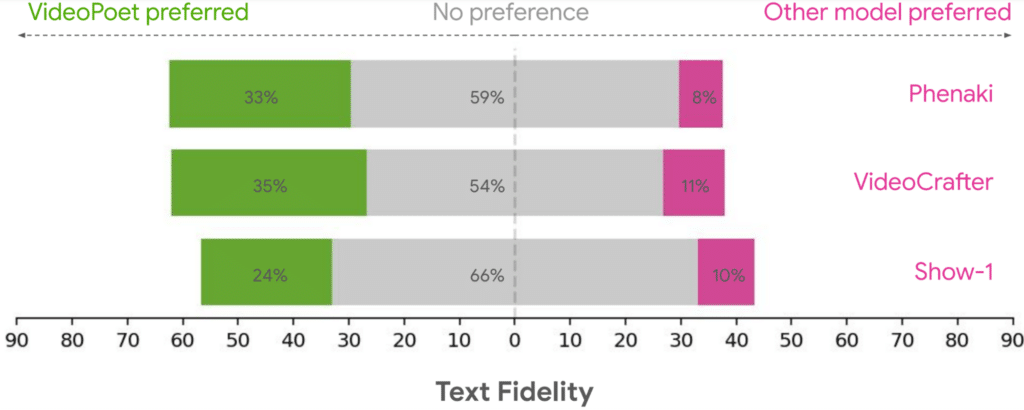

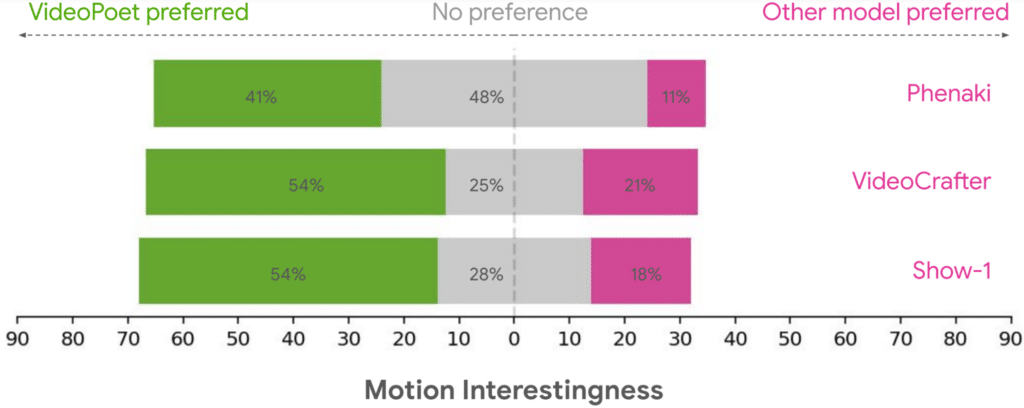

Pour évaluer VideoPoet, Google s'est appuyé sur une large variété de benchmarks pour comparer les résultats avec d'autres approches employées par la concurrence.

Tous les modèles ont été exécutés sur une grande diversité de prompts afin d'assurer une neutralité totale. Des personnes ont été sollicitées pour choisir leurs préférences.

Plusieurs critères ont été pris en compte. En moyenne, VideoPoet est choisi dans 24 à 35% des cas pour la fidélité au prompt textuel contre 8 à 11% pour les modèles rivaux.

De même, il est préféré dans 41 à 54% des cas pour l'intérêt du mouvement produit. En comparaison, les autres modèles n'ont été choisi que dans 11 à 21% des exemples.

Les exemples de vidéos produites par VideoPoet

Afin d'illustrer les prouesses de sa nouvelle IA, Google a partagé plusieurs exemples sur un site web dédié. On constate que les vidéos peuvent avoir une durée variable, et appliquer divers mouvements et styles en fonction du prompt textuel.

Dans une optique de responsabilité, Google indique clairement le style et les œuvres d'art dont s'inspire chaque vidéo générée. Le but est d'éviter les controverses ayant mené des artistes à porter plainte contre MidJourney pour plagiat.

Par défaut, le modèle génère des vidéos au format portrait semblable aux vidéos TikTok ou YouTube Shorts. Toutefois, il peut aussi générer des vidéos plus longues en conditionnant la dernière seconde d'une vidéo et en prédisant la suivante.

Enchaîner ce processus permet non seulement d'étendre la vidéo, mais aussi de préserver l'apparence de tous les objets présents dans la scène.

En guise de démonstration, les chercheurs ont utilisé Bard pour inventer une histoire et l'ont ensuite illustrée scène par scène en générant des vidéos avec VideoPoet.

Cette IA peut aussi générer de l'audio par dessus une vidéo sans même avoir besoin de prompt. Avec un seul modèle, il devient donc capable de créer la vidéo et l'audio qui l'accompagne.

La caméra peut être guidée via des prompts textuels

Il est également possible d'éditer les vidéos générées par VideoPoet, en changeant le mouvement des objets pour effectuer différentes actions. Cette manipulation d'objets peut être centrée sur le premier cadre ou les cadres du milieu pour un plus haut degré de contrôle.

On peut par exemple générer aléatoirement des clips à partir de l'input vidéo, et de sélectionner le prochain clip souhaité. De même, le mouvement peut être appliqué à l'image d'input pour éditer son contenu vers l'état désiré à l'aide d'un prompt.

Les mouvements de caméra peuvent aussi être contrôlés en ajoutant le type souhaité au prompt textuel. Pour cet exemple, les chercheurs ont ajouté à leur prompt : « zoom out, dolly zoom, pan left, arc shot, crane shot, FPV drone shot ».

Vers une révolution pour le cinéma et les vidéos YouTube ?

Avec VideoPoet, Google a prouvé que les LLM sont une excellente approche pour la génération de vidéo, notamment en ce qui concerne le mouvement.

Pour le futur, les chercheurs envisagent d'étendre cette IA pour lui permettre de générer n'importe quel type de contenu : text-to-audio, audio-to-video, sous-titrages de vidéos…

Les générateurs de vidéos IA évoluent à une vitesse ahurissante, et il ne fait aucun doute que cette technologie va totalement bouleverser les domaines tels que le cinéma ou les plateformes comme YouTube.

D'ici quelques années, voire même quelques mois, n'importe qui pourra créer une vidéo sans avoir besoin d'une caméra ou d'un logiciel de montage. On peut donc imaginer l'émergence de films dignes des blockbusters d'Hollywood créés par de simples amateurs à l'aide de l'IA.

Néanmoins, le revers de la médaille pourrait être une avalanche de DeepFakes plus vrais que nature sur le web et les réseaux sociaux. Le réel va devenir de plus en plus difficile à distinguer du fictif…

- Partager l'article :