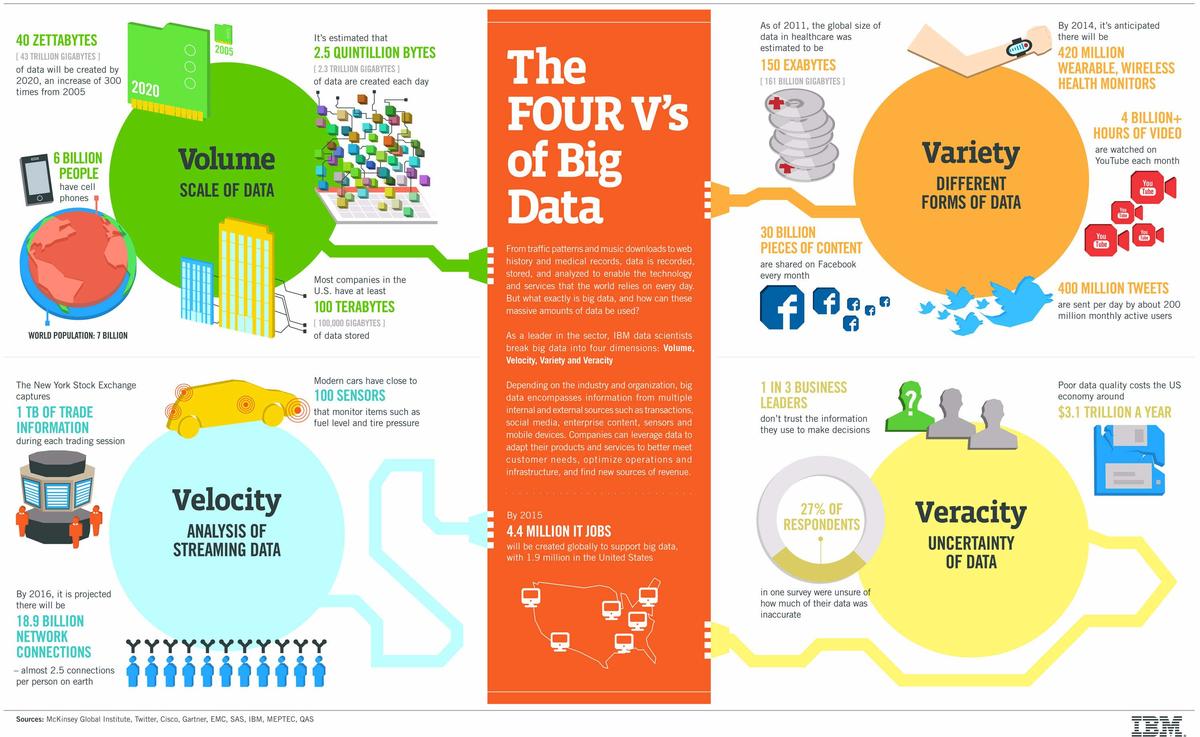

Selon de nombreux spécialistes, la notion de Big Data peut être définie par les quatre V : Volume, Variété, Vitesse et Véracité. Ces quatre dimensions la caractérisent, et distinguent les données volumineuses des données ordinaires. À travers l'infographie présentée dans cet article, IBM met en lumière ces spécificités.

C'est avec l'essor du numérique qu'est née la notion de Big Data. L'usage accru d'internet et de ses déclinaisons a engendré une augmentation des données, en termes de volume, mais également de variété et de vitesse, ainsi qu'une perte de précision. Cette évolution des données est, aux yeux des Data Scientists d'IBM, celle qui caractérise et définit le Big Data.

Dans le cadre de son infographie sur ce sujet, IBM commence par rappeler comment est apparue cette transformation des données. Le principal facteur de ce changement est bien entendu l'apparition des réseaux sociaux, des appareils mobiles intelligents, des objets connectés, mais également la multiplication des transactions sur internet.

Le géant de l'informatique rappelle par ailleurs comment les entreprises peuvent exploiter ces données. Le Big Data peut servir à adapter ses produits et ses services aux besoins des consommateurs, à optimiser les opérations et l'infrastructure, ou encore à trouver de nouvelles sources de revenus. La firme californienne dévoile ainsi que 4,4 millions d'emplois relatifs au Big Data ont été créés dans le monde en 2015, dont 1,9 million aux États-Unis.

Les quatre V

Pour comprendre le Big Data, IBM synthétise ce phénomène par quatre spécificités majeures : les 4 V. Le Volume, la Variété, la Vélocité et la Véracité.

Volume

Le volume est la principale caractéristique du Big Data. Le terme est en effet directement tiré de l'immense masse de données générées au quotidien. Selon IBM, une moyenne de 2,5 quintillions de bytes de données sont créés chaque jour, soit environ 2,3 trillions de gigabytes.

D'année en année, la quantité de data augmente considérablement. Sur l'ensemble de l'année 2020, 40 zettabytes de données seront créés, soit 43 trillions de gigabytes. Ceci représente une quantité 300 fois plus importante qu'en 2005.

Ces données proviennent à la fois des entreprises et des particuliers. Aux États-Unis, la plupart des entreprises ont au moins 100 terabytes de données, soit environ 100 000 gigabytes entreposés dans leurs systèmes de stockage. De plus, sur 7 milliards d'individus, 6 milliards possèdent actuellement un téléphone portable.

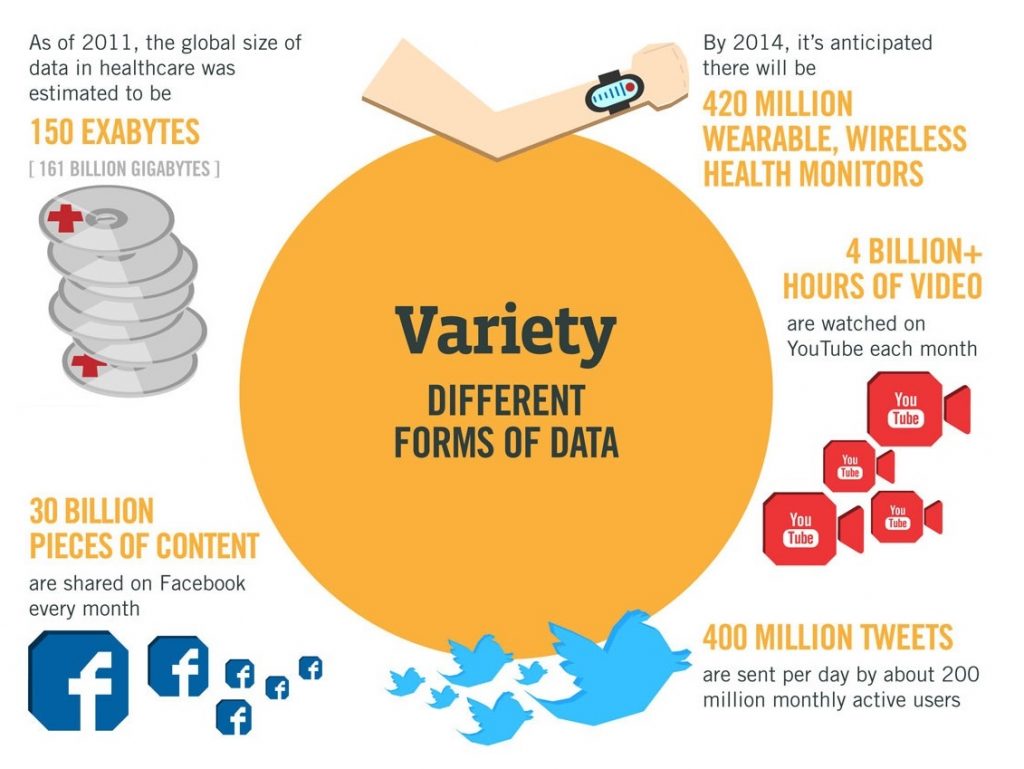

Variété

Par delà la simple quantité, ces données sont également plus diversifiées que jamais. Ce phénomène est lié à la diversification des usages d'internet et du numérique. La provenance des données, leur format, mais également le domaine auquel elles sont liées connaissent une variété sans précédent.

En 2011, on dénombrait déjà 150 exabytes, soit 161 milliards de gigabytes, de données relatives à la santé. En 2014, se sont ajoutées à cette somme les données en provenance d'environ 420 millions d'objets connectés tels que les traqueurs d'activité et autres appareils sans fils permettant d'analyser l'état de santé d'un utilisateur.

Les différents réseaux sociaux génèrent également une immense masse de data. Chaque mois, 30 milliards de publications sont partagées sur Facebook. Sur Tweeter, les 200 millions d'utilisateurs actifs émettent environ 400 millions de tweets par jour. De même, les 4 milliards d'heures de vidéo visionnées chaque mois sur YouTube représentent également une nouvelle forme de données non structurées.

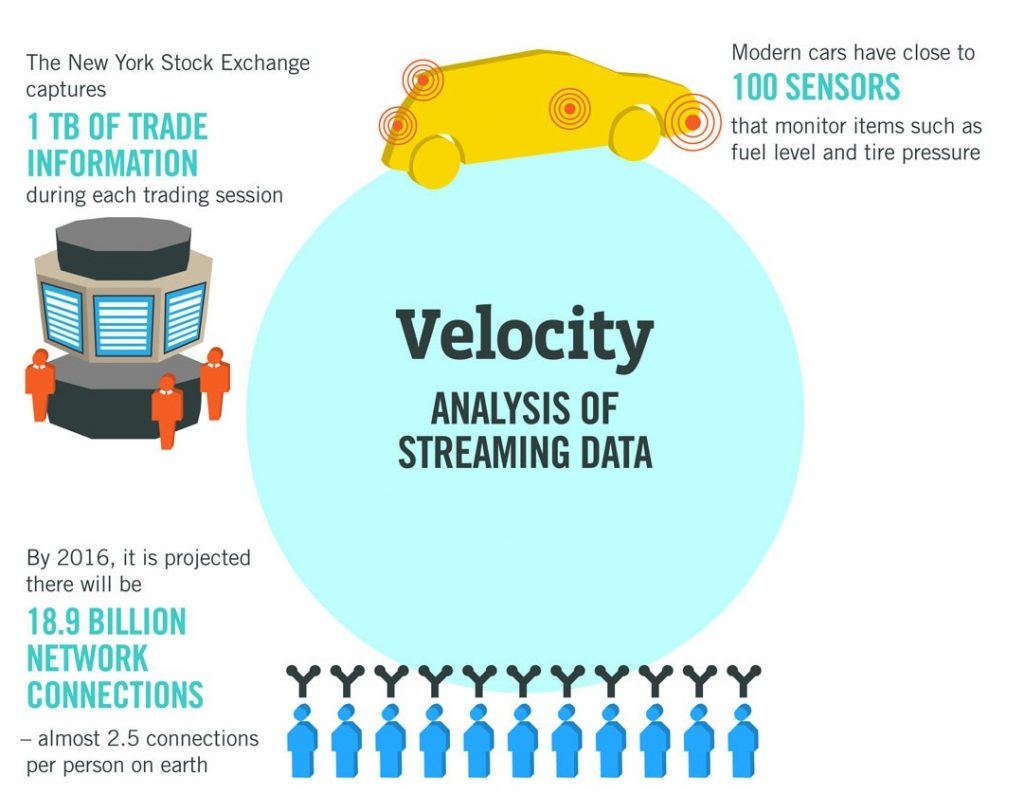

Vélocité

Les données sont également collectées plus rapidement, puisqu'elles sont désormais reçues sous forme de flux. Pour illustrer cette accélération, certains parlent à présent de Fast Data comme la prochaine étape après la maîtrise du Big Data.

Ainsi, IBM prend l'exemple des voitures modernes, équipées en moyenne de 100 capteurs capables de mesurer en temps réel le niveau d'essence, la pression des pneus et bien d'autres données. Le phénomène est également illustré par l'exemple du New York Stock Exchange, qui enregistre environ 1 terabyte de données durant chaque session.

Chaque activité réalisée sur internet est désormais traquée avec précision, grâce à un total de 18,9 milliards connections en réseau dans le monde, soit environ 2,5 pour chaque individu sur Terre. Internet n'a jamais été aussi rapide.

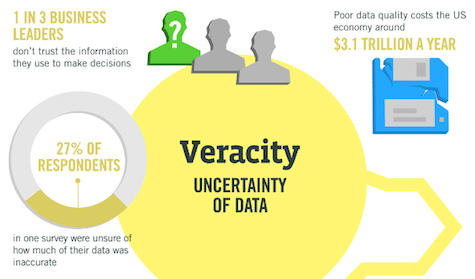

Véracité

La véracité, l'exactitude des données demeurent aujourd'hui le principal défi du Big Data. À l'heure actuelle, ces données ne sont pas encore suffisamment maîtrisées, et la précision des analyses s'en trouve affectée.

Ainsi, dans le cadre d'un sondage réalisé par IBM, 27% des entreprises interrogées avouent ne pas être certaines de l'exactitude des données qu'elles collectent. De même, un chef d'entreprise sur trois utilise les données pour prendre des décisions, mais n'a pas vraiment confiance. Ce manque de véracité et de qualité des données coûte environ 3,1 trillions de dollars par an aux États-Unis.

En conclusion, le Big Data se caractérise par le volume, la variété, et la vitesse des données. La véracité des données reste quant à elle un enjeu majeur, tant sur le plan économique que comme un moteur pour l'innovation au sein des entreprises.

- Partager l'article :