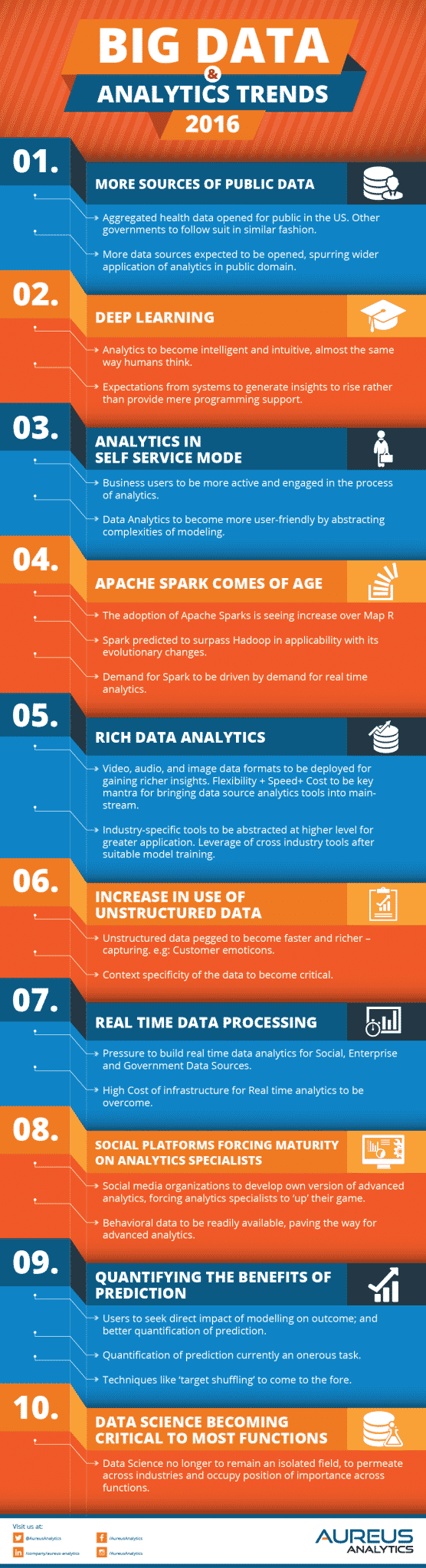

Pour la troisième année consécutive, Aureus Analytics présente son rapport des tendances 2016 du Big Data et de l'analytique sous la forme d'une infographie claire et lisible. Découvrez les changements et les nouveautés à prévoir pour cette année.

Depuis maintenant trois ans, l'entreprise indienne Aureus Analytics présente ses prévisions des tendances du Big Data et du Data Analytics pour l'année en cours. Ce spécialiste du Big Data de l'analyse prédictive offre une vision claire de l'évolution de ce marché en perpétuelle transformation.

Cette année, le mot d'ordre semble être au Self-Service Analytics, alors que de plus en plus d'entreprises utilisent les analyses en temps réel pour prendre des décisions majeures. Les Data Scientists eux-mêmes doivent désormais comprendre les enjeux de l'entreprise. Dans ce contexte, de nouveaux outils et autres écosystèmes devraient apparaître sans tarder.

Les prévisions d'Aureus Analytics pour 2016

1 – De nouvelles sources de données publiques

Aux États-Unis, les données de santé agrégées sont désormais ouvertes au public par l'intermédiaire du National Center for Health Statistics du CDC. D'ici peu de nombreux autres pays devraient emprunter la même direction. En conséquence, ces données peuvent à présent être librement exploitées par les entreprises. Outre la santé, d'autres domaines devraient également prochainement ouvrir l'accès à leurs données.

2 – Deep Learning

Grâce au Deep Learning, les outils analytiques vont progressivement devenir plus intelligents, autonomes et intuitifs. Leur fonctionnement va peu à peu se rapprocher de celui de l'esprit humain et de sa façon de penser.

3 – Self-Service Analytics

Afin de compenser le manque de spécialistes qualifiés, et dans le but de gagner du temps, les entreprises vont peu à peu prendre en charge par elles-mêmes les analyses de données grâce aux outils de Self-Service Analytics. Dans cet ordre d'idée, les outils traditionnels de Data Analytics devraient également devenir plus accessibles et user-friendly.

4 – La maturité d'Apache Sparks

Avec l'adoption croissante de la plate-forme MapR, Apache Spark est logiquement plus utilisé. Grâce à ses changements évolutifs, Spark pourrait même peu à peu surpasser Hadoop, notamment pour répondre aux demandes d'analyse en temps réel.

5 – Rich Data Analytics

Afin d'obtenir des informations plus complètes, les données issues de formats tels que la vidéo, l'audio ou les images vont être de plus en plus analysées. À mesure que les coûts seront réduits, et que la flexibilité et la vitesse de traitement augmenteront, les outils nécessaires à ces analyses se populariseront.

6 – Les données non structurées de plus en plus exploitées

Les données non structurées, par exemple les émoticônes utilisées par les internautes, vont être collectées et analysées plus rapidement et plus profondément. Par ailleurs, le contexte précis d'émission des données va devenir une information essentielle.

7 – Le traitement des données en temps réel

Les données issues des réseaux sociaux, des gouvernements ou encore des entreprises elles-mêmes doivent désormais être analysées en temps réel pour plus d'efficacité. Le coût des infrastructures nécessaires, principal obstacle à ce gain de temps, devrait être surmonté cette année.

8 – Les réseaux sociaux forcent les spécialistes de l'analyse à évoluer

Peu à peu, les réseaux sociaux vont développer leurs propres outils analytiques. Pour rester compétitifs, les Data Analysts vont donc devoir redoubler d'efforts et d'inventivité. Par ailleurs, les données comportementales issues des réseaux sociaux vont être plus facilement accessibles.

9 – Quantifier les bénéfices des analyses prédictives

Afin de déterminer l'utilité d'une analyse prédictive, les entreprises souhaitent de plus en plus pouvoir quantifier son impact. Dans ce contexte, les techniques comme le Target Shuffling sont amenées à être de plus en plus utilisées. Pour l'heure, la quantification des effets d'une analyse prédictive reste une tâche coûteuse.

10 – La science des données devient essentielle dans tous les secteurs de l'entreprise

La Data Science n'est plus une notion isolée. Elle gagne en importance dans les tous les secteurs d'entreprise, et même au sein de toutes les fonctions. Les Data Scientists doivent donc gagner en polyvalence.

- Partager l'article :