Microsoft dévoile VASA-1 : une IA capable de transformer n'importe quelle photo en vidéo animée et synchronisée avec un discours audio ! Un outil idéal pour donner vie à des images de personnages virtuels… ou pour créer des DeepFakes de ses ennemis et les humilier publiquement.

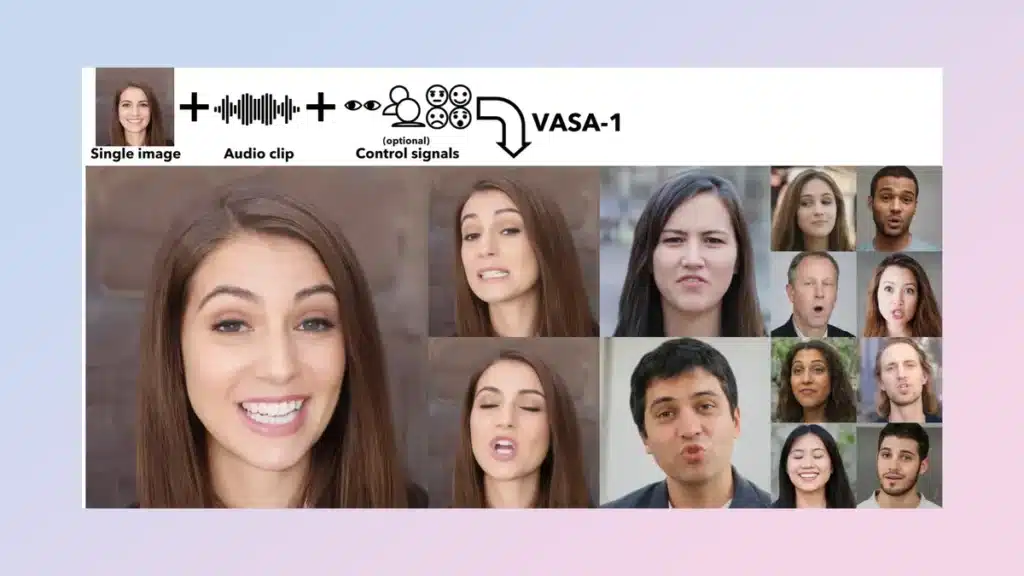

Les GAFAM continuent à mitrailler le monde de nouvelles intelligences artificielles toutes plus bluffantes les unes que les autres ! Le mardi 16 avril 2024, Microsoft a dévoilé sa nouvelle IA dénommée VASA-1 : Visual Affective Skills Animator.

Celle-ci est capable de créer une vidéo animée synchronisée d'une personne parlant ou chantant… à partir d'une simple photo et d'une piste audio !

L'IA qui rend les photos vivantes comme dans Harry Potter

Le framework VASA utilise le Machine Learning pour analyser une image statique et un clip audio. Elle peut ensuite générer une vidéo réaliste avec des expressions faciales très précises, des mouvements de tête, et une synchronisation des lèvres avec l'audio.

Un large spectre de nuances faciales et de mouvements de tête naturels peuvent être capturés, afin de créer une illusion parfaite d'authenticité et de vie.

Elle ne clone pas les voix, comme le fait OpenAI Voice Engine ou d'autres outils, mais se contente d'utiliser un audio existant enregistré spécialement pour l'occasion ou dans n'importe quel contexte.

D'après le papier scientifique qui accompagne VASA-1, cette IA va « paver la voie pour des engagements en temps réel et des avatars vivants émulant les comportements de conversation humains ».

Un entraînement sur des vidéos YouTube

Afin d'entraîner VASA-1, les chercheurs de Microsoft ont utilisé le dataset VoxCeleb2 créé en 2018 par trois chercheurs de l'Université d'Oxford.

Ce jeu de données contient plus d'un million de discours de 6112 célébrités, extraits à partir de vidéos disponibles sur YouTube.

Suite à cet entraînement, l'IA est capable de générer ses propres vidéos de définition 512×512 à 40 images par seconde en deux minutes avec GPU Nvidia RTX 4090. Elle pourrait donc être utilisée pour des applications en temps réel, comme les visioconférences.

Un rival pour l'IA chinoise Alibaba EMO

Selon Microsoft, ce nouveau modèle de génération de mouvements de tête et de dynamique faciale surpasse totalement les précédentes méthodes d'animation de discours en termes de réalisme, d'expressivité ou même d'efficacité.

Voilà plusieurs années que les chercheurs du monde entier tentent d'utiliser l'IA pour animer une photo d'une personne ou d'un personnage, mais ils se focalisent désormais sur la synchronisation automatique d'une vidéo avec une piste audio.

En février 2024, l'Institute for Intelligent Computing du géant chinois Alibaba a fait beaucoup de bruit en dévoilant une IA similaire à VASA-1 : EMO (Emote Portrait Alive).

Elle se base sur une méthode semblable, dénommée Audio2Video, et permettant de synchroniser une photo animée avec un audio.

Parmi les autres technologies similaires, on peut citer Runway et Nvidia Audio2Face. Toutefois, l'approche de Microsoft est beaucoup plus réaliste et la qualité est nettement supérieure avec des artefacts de bouche largement réduits.

La technique d'animation guidée par l'audio rappelle le modèle VLOGGER AI, récemment présenté par Google Research pour les avatars virtuels.

De plus, VASA se distingue en permettant à l'utilisateur de choisir où le personnage regarde, de rogner sa tête, ou même de sélectionner les émotions comme la joie, la colère ou la surprise.

Notons aussi que cette IA n'a pas besoin d'une image de style portrait facial pour fonctionner. Elle peut animer n'importe quel type de photo, y compris des tableaux de peinture.

Les chercheurs eux-mêmes ont été surpris par la capacité de VASA-1 à synchroniser parfaitement les lèvres d'un personnage sur une chanson, reflétant à merveille les mots du chanteur malgré l'absence de musique dans le dataset d'entraînement…

Première démo impressionnante de VASA-1

Afin de présenter les capacités de cette IA, Microsoft a mis en ligne plusieurs démos vidéo de personnes chantant ou parlant en synchronisation avec des pistes pré-enregistrées sur une page dédiée.

Ceci permet de voir comment le modèle peut être contrôlé pour exprimer différentes humeurs ou changer de regard.

Les chercheurs se sont lâchés, avec des exemples insolites comme Mona Lisa qui rappe ou Anne Hathaway qui chante du Lil Wayne chez Conan O'Brien.

Par souci de confidentialité, chaque photo d'exemple a été générée à l'aide des IA StyleGAN2 ou DALL-3. Toutefois, il est tout à fait possible d'appliquer cette technologie à des photos de vraies personnes.

Cela devrait toutefois mieux fonctionner sur des photos de célébrités déjà présentes dans le dataset d'entraînement.

Un grave danger de DeepFake ?

Cet outil va permettre de créer des avatars virtuels à l'image de leurs créateurs. Les chercheurs vantent notamment des applications positives pour l'éducation, l'accessibilité, ou encore la compagnie thérapeutique.

Il pourrait aussi permettre de créer des personnages pour les jeux vidéo contrôlés par l'IA, avec des mouvements de lèvres naturels pour renforcer l'immersion dans le monde virtuel.

Toutefois, VASA-1 pourrait aussi être détourné pour prendre la photo d'une personne sur les réseaux et lui faire dire n'importe quoi en vidéo…

On peut craindre que des personnes malveillantes falsifient des discussions vidéo, fassent dire à autrui des choses qu'ils n'ont jamais dites, ou provoquent des vagues de harcèlement injustifiées.

Néanmoins, les chercheurs affirment que leur objectif n'est pas de permettre le deepfaking de véritables humains. Ils souhaitent plutôt donner vie à des personnages virtuels.

Par ailleurs, il s'agit uniquement d'une démonstration scientifique et Microsoft ne prévoit pas de lancer de produit ni même d'API afin d'éviter les dérives…

Notons aussi que les vidéos générées avec VASA contiennent des artefacts identifiables, et que l'analyse numérique suffit à voir qu'il ne s'agit pas d'une vidéo authentique.

Rappelons que Microsoft est en collaboration avec OpenAI, et la technologie VASA pourrait donc être directement incorporée au futur générateur de vidéos Sora très attendu.

Malheureusement, Microsoft n'est pas le seul groupe à développer une telle technologie. De toute évidence, un outil similaire sera bientôt disponible en open source et rien ne semble pouvoir empêcher l'avènement de l'ère du DeepFake…

Et vous, qu'en pensez-vous ? Allons-nous bientôt devoir douter de tout ce que nous voyons sur internet ? Comment éviter les graves conséquences potentielles ? Partagez votre avis en commentaire !

- Partager l'article :