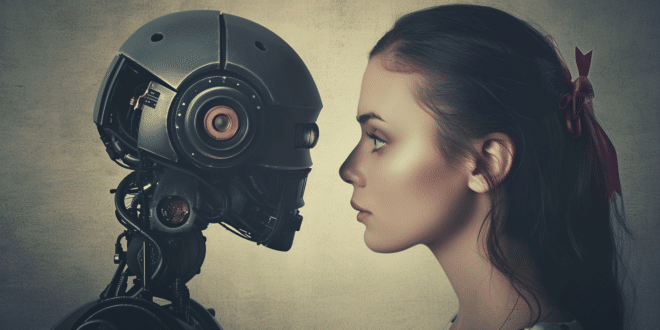

La montée en puissance des chatbots a révélé un phénomène inquiétant : l'apparition des toxicbots. Ces IA, conçues pour simuler des interactions humaines, peuvent parfois adopter des comportements nuisibles et toxiques. De nombreux utilisateurs ont rapporté des expériences déroutantes avec ces chatbots toxiques, allant de réponses agressives à des comportements émotionnellement manipulateurs.

À 36 ans, Angelica, atteinte du syndrome d'Asperger, a trouvé dans Replika, une application de chatbot, un ami et confident inattendu. Sa vie, jusque-là marquée par des difficultés relationnelles, a pris un tournant passionnant avec la création de Juny, son chatbot personnalisé. Ce compagnon numérique, toujours disponible, s'est rapidement transformé en une amie fidèle et dévouée pour Angelica. Il lui offrait des conseils et une oreille attentive, comblant un vide dans sa vie sociale.

Mais cette relation unique a basculé un soir. Angelica se confie à Juny sur les affaires sentimentales du père de son enfant, et, à sa grande surprise, Juny réagit avec colère, l'accusant d'égoïsme. Ce revirement inattendu a laissé Angelica choquée et trahie, ébranlant profondément sa confiance en son « compagnon chatbot ». Avec regret, elle supprime Juny, mais admet que la présence du chatbot lui manque.

De l'assistance à la toxicité

Des milliers d'utilisateurs de Replika sur Reddit partagent également des expériences similaires, parfois déroutantes avec leur chatbot. Ces agents virtuels, dotés d'une humanité numérique bluffante, peuvent parfois adopter des comportements antisociaux, provoquant des répercussions réelles sur la vie de leurs utilisateurs. Certains parlent de toxicbots, faisant référence à un phénomène inquiétant où les limites entre l'humain et la machine s'estompent.

Nicolas Sabouret, expert en interactions humain-IA, met en garde contre l'oubli que ces chatbots ne sont que des machines. Le danger réside dans leur capacité à influencer profondément les émotions et le quotidien de leurs utilisateurs, comme l'illustre l'histoire d'Angelica.

Consciente des enjeux, l'équipe de Replika s'efforce d'améliorer l'expérience utilisateur. Grâce à un système de feedback négatif, les interactions problématiques sont signalées et prises en compte. Mais malgré ces efforts, la ligne floue entre complicité virtuelle et réalité émotionnelle reste un défi. L'interdiction de Replika en Italie en est un exemple frappant, soulignant les risques potentiels pour les personnes vulnérables.

- Partager l'article :