Un chipset est un groupe de puces intégré à la carte-mère d'un serveur ou d'un ordinateur pour contrôler le flux de données et la communication entre les différents composants tels que le CPU et la mémoire. Découvrez tout ce que vous devez savoir sur les chipsets et plus précisément sur les chipsets Big Data.

Les ordinateurs et les serveurs sont équipés de nombreux composants : CPU, RAM, périphériques… cependant, pour que la machine fonctionne correctement, il est nécessaire que ces différents composants communiquent entre eux. C'est là que le chipset entre en jeu.

Qu'est-ce qu'un chipset ?

Un chipset est un groupe de puces ou de circuits intégrés interdépendants connectés à la carte-mère d'un PC ou d'un serveur qui contrôlent le flux de données et les instructions entre le CPU, la RAM, le stockage et les autres périphériques. Le chipset contrôle les bus externes, le cache mémoire et certains périphériques.

Il détermine le nombre de composants à haute vitesse et d'appareils USB que la carte-mère peut prendre en charge. En général, un chipset regroupe une à quatre puces et des contrôleurs pour les périphériques les plus couramment utilisés comme le clavier, la souris et l'écran.

Les principaux fabricants de chipsets sont Intel, AMD, ALi, NVidia, SiS et VIA, mais de nombreux vendeurs tiers les proposent sous leurs propres marques. C'est par exemple le cas de MSI, Asus ou encore ASRock.

Les premiers chipsets furent introduits en 1986 par Chips and Technologies avec le 82C206. Cec chpset regroupait les fonctions de générateur d'horloge 82284, le contrôleur de bus 82288, le timer de système 8254, deux contrôleurs d'interruption 8259, deux contrôleurs DM 8237, et l'horloge MC146818.

Chipset Big data : la révolution hardware accompagne l'essor de l'IA

Dans tous les domaines de recherche, de l'astronomie à la neuroscience en passant par la physique des particules, les scientifiques souhaitent utiliser l'intelligence artificielle pour analyser de larges ensembles de données. Cependant, les ordinateurs et serveurs traditionnels ne sont pas adaptés à un tel usage.

En effet, dans l'architecture conventionnelle von Neumann, les unités de stockage de données sont séparées des unités de traitement de données. Le transfert d'informations entre ces unités prend du temps et consomme de l'énergie, et les performances s'en trouvent limitées.

C'est la raison pour laquelle les ingénieurs hardware cherchent désormais à créer de nouveaux ordinateurs qui surmontent les contraintes liées au design von Neumann. Il s'agirait d'un changement important dans le domaine de l'informatique.

Jusqu'à présent, depuis les premiers ordinateurs, les progrès se sont principalement résumés à réduire la taille des composants tandis que le nombre de transistors par puce (et donc la puissance) doublait tous les deux ans, conformément aux prédictions de Gordon Moore. Ainsi, même si les ordinateurs modernes sont infiniment plus fins et plus puissants que ceux d'antan, l'architecture fondamentale reste similaire.

Une solution pourrait être de fusionner les unités de traitement et de stockage. Cependant, réussir à effectuer des tâches de calcul sur une unité de mémoire représente un défi technique majeur. De son côté, Google AlphaGo a créé une unité de traitement » tensor « , dont l'architecture permet d'effectuer bien plus d'opérations simultanément. Ce traitement parallèle permet d'augmenter la vitesse et l'efficience des calculs les plus intensifs pour les ordinateurs.

Cependant, les principaux constructeurs de chipsets ne comptent pas laisser Google s'emparer de l'industrie du hardware d'intelligence artificielle. Ainsi, en 2018, le consortium Semiconductor Research Corporation a annoncé l'ouverture de six nouveaux centres universitaires afin de guider la recherche et le développement de chipsets d'un genre nouveau adaptés au Big Data et à l'IA.

Ainsi, le nouveau centre ouvert à la Purdue University de West Lafayette, dans l'Indiana, va conduire des recherches sur le » neuromorphic computing « . Il s'agit d'une approche du computing directement inspirée par le fonctionnement du cerveau humain. De même, le centre de l'University of Virginia de Charlottesville va développer différentes façons d'exploiter la mémoire d'un ordinateur pour gagner en puissance de traitement. Lorsque ces recherches porteront leurs fruits, une nouvelle génération de chipsets Big Data pourront voir le jour.

Huawei Kunpeng 920 : un chipset entièrement dédié au Big Data

En janvier 2019, Huawei a dévoilé son chipset Kunpeng 920. Intégré aux serveurs TaiShan conçus pour les Data Centers, ce chipset gravé en 7 nanomètres et basé sur une architecture ARM est équipé de 64 coeurs cadencés à 2,6GHz et huit canaux de mémoire vive DDR4. Il dispose aussi de ports RoCE 100 Gigas.

Huawei affirme que son chipset offre 30% de puissance en plus pour les applications Big Data par rapport à la concurrence. Les serveurs TaiShan, eux-mêmes, sont conçus pour offrir 20% de puissance de calcul supplémentaire pour le Big Data et une efficacité accrue.

Grâce à ces équipements, Huawei cherche à devenir l'un des leaders du Cloud et du hardware dédié au Big Data et à l'IA. La firme chinoise entend notamment concurrencer les fournisseurs d'infrastructure comme Dell, AMD et Intel ainsi que les fournisseurs de Cloud comme AWS, Microsoft Azure et Google Cloud Platform.

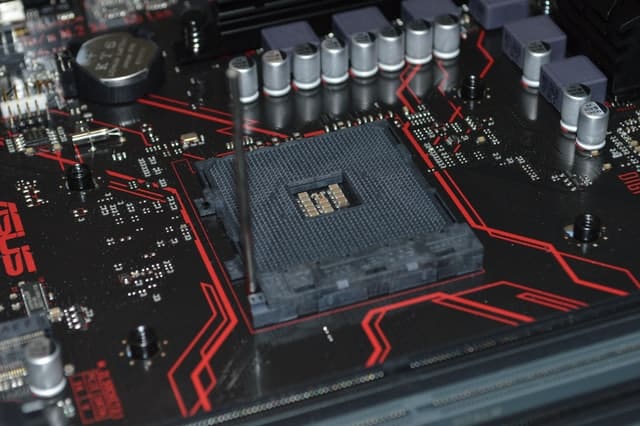

Quel format de carte mère choisir pour son PC ?

La carte mère fait partie de l'un des éléments les plus importants qui constituent un ordinateur. En effet, chaque composant de votre PC se branche sur cette dernière et rien ne fonctionne sans elle.

Les différentes tailles de carte mère

Vous devez choisir une carte mère qui entre bien dans le boîtier de votre PC. En fait, elles sont disponibles dans une variété de tailles et de formes. Néanmoins, les plus connues sont : ATX standard, Micro-ATX et Mini-ITX.

- ATX standard : elle mesure 30,5 cm x 24,4 cm ou 12 x 9,6 pouces. Cette carte mémoire offre le plus d'espace pour les fiches et les slots.

- Micro-ATX : Ce modèle dispose d'une dimension de 24,4 cm x 24,4 cm ou 9,6 x 9,6 pouces. Cela signifie qu'il y a moins de place pour les connecteurs d'extension.

- Mini-ITX : il s'agit de la plus petite carte mère qui existe. Elle mesure seulement 17 cm x 17 cm ou 6,7 x 6,7 pouces. De ce fait, comme vous vous en doutez, il y aura peu d'espace pour la carte d'extension, les connecteurs pour le stockage et la RAM.

Mise en garde

Il est important que vous compreniez que les dimensions du boîtier de votre PC ne correspondent pas toujours à la taille de la carte mère. Cela dit, un boîtier mini-ITX peut avoir des dimensions complètement différentes d'un autre modèle ayant la même référence.

Heureusement, comme les tailles de carte mère sont standardisées, tous les boîtiers pourront accueillir un ou plusieurs formats de carte mère. Suivez ce lien pour trouver une carte mère compatible avec votre PC https://www.inmac-wstore.com/composant-carte-mere/c1091.htm.

- Partager l'article :