Alors que l’intelligence artificielle sera très bientôt omniprésente dans nos sociétés, il est impératif de lui fixer un cadre éthique. À travers le webinar « Data Science, biais et éthique » organisé par l’Université Paris Dauphine-PSL, Marie Langé présente des exemples de biais gangrénant l’IA, explique leurs causes et suggère des solutions…

L’intelligence artificielle est la technologie la plus révolutionnaire de ce début de millénaire. En transformant toutes les industries, en s’immisçant dans nos quotidiens, l’IA va bouleverser toutes les facettes de la société.

Automatisation du travail, surveillance de masse, reconnaissance faciale, aide à la prise de décision… autant de possibilités offertes par l’essor du Machine Learning et de la Data Science. Toutefois, si l’intelligence artificielle devient bel et bien omniprésente dans nos vies, il est impératif de fixer un cadre éthique.

Sans cet encadrement, les risques de dérives et les dangers sont innombrables. Comme le redoutent les auteurs de science-fiction depuis des décennies, une IA incontrôlée pourrait accroître les inégalités sociales, donner lieu à des massacres immoraux sur les champs de bataille, et même mettre en péril l’avenir de l’humanité.

Afin d’aborder ces problématiques cruciales pour le futur, et d’évoquer les solutions envisageables, Marie Langé est intervenue lors du webinar « Data Science, biais et éthique » organisé par l’Université Paris Dauphine-PSL.

Fondatrice du cabinet de conseil en Data & IA AMASAI, Marie Langé est actuellement responsable de l’offre Data chez Adone Conseil. Elle est issue du secteur de l’informatique et du e-commerce, notamment dans le domaine du luxe. L’éthique de la science des données est au coeur de ses préoccupations.

Quelques exemples édifiants de biais dans l’IA

Afin de planter le décor et de présenter le sujet aux non-initiés, l’experte a commencé son intervention par quelques exemples de biais dans le domaine de l’IA. Le premier exemple est celui de Joy Buolamwini, chercheuse au MIT, qui s’est rendue compte que les logiciels de reconnaissance faciale ne la reconnaissaient pas. En cause ? Sa couleur de peau. Dès lors qu’elle a revêtu un masque blanc, l’IA n’avait plus aucun souci pour l’identifier.

Toujours dans le but d’illustrer ce problème de discrimination, Marie cite également une étude menée sur les systèmes de reconnaissance faciale de Microsoft et IBM. Cette étude démontre que l’IA » mégenre » nettement plus souvent les personnes de couleur que les personnes blanches. Alors que le taux d’erreur est d’à peine 1% pour les hommes blancs, il atteint 35% pour les femmes de couleur.

D’autres exemples sont évoqués, comme l’application FaceApp qui blanchit Barack Obama pour le rendre plus sexy, Google Photos percevant deux personnes noires comme un couple de gorilles, l’assistant vocal Bixby de Samsung incapable de comprendre les voix féminines, ou Google Traduction estimant qu’une femme ne peut être médecin.

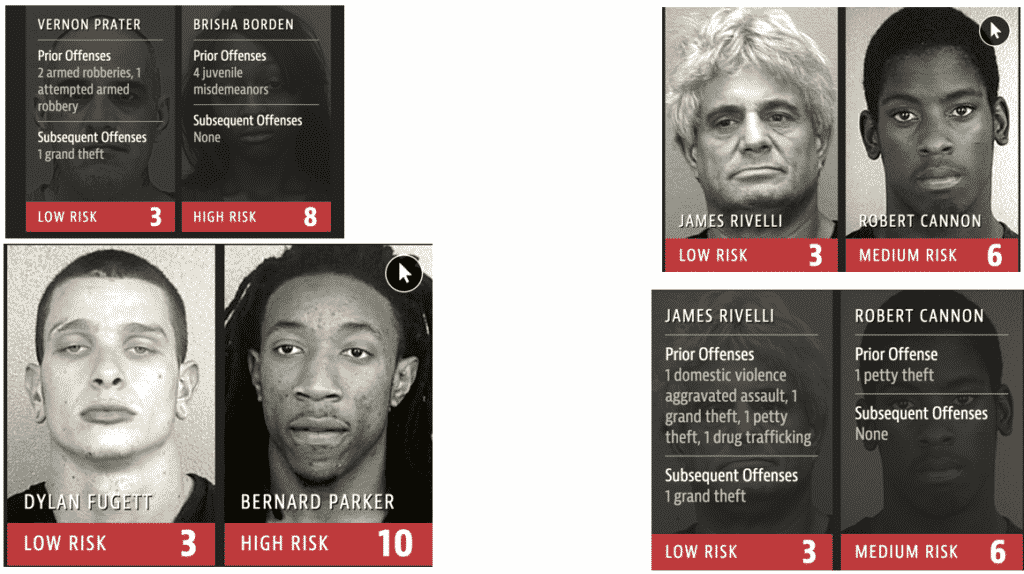

Plus inquiétant encore, le logiciel COMPAS, utilisé aux États-Unis pour décider des peines de prison, semble convaincu qu’une personne noire a plus de chances de récidiver. Le constat est sans appel : à l’heure actuelle, l’intelligence artificielle souffre d’un réel problème de discrimination sexiste et raciale.

Quelles sont les causes du problème ?

Pour expliquer ce phénomène de biais, Marie Langé revient sur leur origine : le développement des modèles de Machine Learning sur lesquels reposent les systèmes IA. L’occasion de mieux comprendre comment fonctionne cette technologie, et comment un manque de données sur les minorités pendant la phase d’entraînement peut avoir des conséquences terribles lors de la mise en production…

D’autres sources du problème sont également illustrées par des exemples concrets, telles que le manque de contexte, les biais liés à la société, ou la mauvaise sélection de données dans le processus de Machine Learning. De manière générale, même si les erreurs de jugement peuvent avoir différentes causes, ces exemples variés démontrent que l’IA perpétue actuellement les biais cognitifs de l’être humain.

À partir des données, ou par l’intermédiaire des personnes qui les conçoivent, les intelligences artificielles héritent des biais intoxiquant déjà les rapports entre les humains dans de nombreux pays. Pire encore, elles tendent à amplifier ces biais et pourront donc accroître le déchirement du tissu social.

Les solutions pour une IA plus éthique

Face à ce sombre tableau, Marie Langé évoque les solutions envisageables pour remédier à ce problème qui gangrène l’IA. Il est tout d’abord essentiel de rendre les algorithmes explicables et d’éviter le fonctionnement en boîte noire, comme s’y attellent les géants du secteur tels qu’IBM ou Google Cloud.

La spécialiste évoque d’autres pistes, comme les procédures de qualification des jeux de données, la lutte contre le manque de diversité parmi les concepteurs d’IA, l’éducation des utilisateurs, le calcul et la soustraction des biais aux données, ou encore l’utilisation d’outils d’analyse de présence des biais comme IBM AI Fairness 360.

La prise de conscience a déjà lieu, et ces différentes pistes d’amélioration commencent à être suivies. Les GAFAM ont formé un consortium pour l’éthique de l’IA, les universités proposent des cours sur ce sujet, et des associations réclament une plus grande transparence. La Commission européenne prépare aussi un cadre juridique dans la lignée du RGPD.

Toutefois, face à l’omniprésence annoncée de l’intelligence artificielle, il est indispensable que ces mesures soient adoptées de façon globale et systématique. Or, la Chine et les États-Unis semblent bien moins préoccupés par les problèmes d’éthique de l’IA que l’Union européenne…

Pour tout savoir sur le sujet, vous pouvez visionner le Webinar « Data Science, biais et éthique » à cette adresse. Après sa présentation, Marie Langé répond aussi aux questions très pertinentes de l’audience.

Avant même d’exercer le métier de consultante, Marie Langé a commencé à s’interroger sur l’éthique de l’IA au cours de sa formation à l’Université Paris Dauphine-PSL. Elle est en effet alumna de l’Executive Master Statistique & Big Data de Dauphine Executive Education, promotion 2019. Cette Formation Continue produit des experts en Data Science, tout en accordant un point d’honneur à l’éthique. Pour plus d’informations, rendez-vous sur le site officiel de Paris Dauphine-PSL à cette adresse.