Hume EVI est le premier chatbot d'intelligence artificielle capable de détecter vos émotions, et de réagir en changeant son ton et ses propos. Découvrez tout ce qu'il faut savoir sur cet outil qui marque un cap dans l'évolution de l'IA, quels sont les cas d'usage possibles, et comment la tester dès maintenant !

Nous vous en parlions récemment dans cet article : l'IA est maintenant capable de détecter nos émotions et de réagir. C'est le cas du nouveau chatbot EVI, que nous vous proposons de découvrir plus en détail dans ce dossier complet !

Développé par la startup Hume, fondée par l'ancien chercheur de Google DeepMind dénommé Alan Cowen, EVI est un assistant vocal basé sur un LLM (large modèle de langage) similaire à OpenAI GPT.

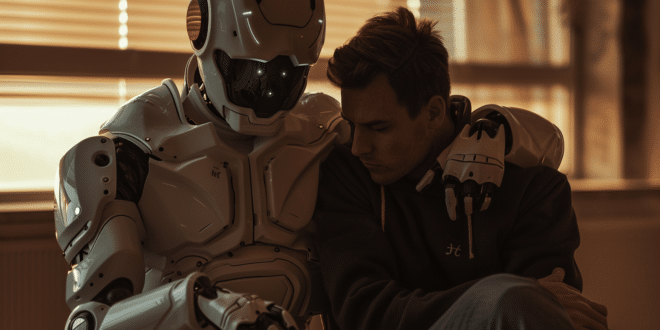

Toutefois, l'objectif que s'est fixé Hume est d'apporter l'empathie et l'intelligence émotionnelle dans le domaine des chatbots IA.

Ainsi, après une levée de fonds de 50 millions de dollars auprès de Comcast Ventures ou encore LG, l'entreprise basée à New York vient de dévoiler son produit phare : EVI (Empathic Voice Interface) : le premier bot type ChatGPT capable de surveiller, prédire et s'adapter à votre humeur.

Qu'est-ce que Hume EVI ?

L'Interface Vocale Empathique (EVI) se distingue des autres chatbots puisque les interactions ne sont pas textuelles comme avec ChatGPT.

À la place, vous pouvez utiliser votre voix pour lui parler. Elle répondra en retour avec sa propre voix synthétique.

Tout comme OpenAI avec ChatGPT-Voice et le robot Figure 01, Hume a fait en sorte que son robot parle de façon plus naturelle et émotive grâce à des mots de pause et des intonations.

Ce n'est pas tout : la startup a fait en sorte que le robot s'exprime de façon à répondre, refléter ou contrer le ton émotionnel de son interlocuteur humain.

Cette IA d'un genre nouveau est donc capable d'adopter un ton similaire à celui des humains en se basant sur vos expressions, et de réagir avec un langage répondant à vos besoins pour maximiser votre satisfaction.

Elle décide aussi quand parler en fonction du ton de votre voix. Ainsi, les conversations sont beaucoup plus naturelles qu'avec les autres chatbots existants.

Contrairement aux assistants vocaux traditionnels, son intelligence émotionnelle lui permet de discerner les nuances du discours humain et d'adapter ses réponses en fonction.

Comment ça marche ? Quelles sont ses capacités ?

Entraînée sur des millions de conversations humaines, EVI comprend et génère un discours expressif. Plusieurs capacités la rendent empathique et la distinguent des autres IA.

Tout d'abord, elle peut employer un ton ressemblant à l'expression humaine pour étendre l'expérience conversationnelle. Elle adapte aussi son langage en fonction de l'utilisateur, pour répondre efficacement à ses besoins.

Selon le ton de l'utilisateur, elle détecte la tournure que prend la discussion pour des interactions très fluides. En cas d'interruption, elle s'arrête, mais peut ensuite reprendre où elle en était.

Mieux encore : EVI apprend des réactions de l'utilisateur pour s'améliorer continuellement et accroître la satisfaction de l'utilisateur au fil du temps.

Outre ces fonctionnalités empathiques, cette IA propose des capacités de traduction et de conversion text-to-speech fiables et rapides. Ceci la rend adaptable à diverses situations, d'autant qu'elle s'intègre avec n'importe quel LLM.

Une IA émotive ? Pourquoi faire ?

Selon Alan Cowen, CEO de scientifique en chef de Hume, l'IA doit impérativement être empathique si nous voulons l'utiliser de manière à améliorer le bien-être de l'humain.

Il estime que la principale limite des systèmes actuels est qu'ils sont guidés par des instructions superficielles, propices aux erreurs et ne permettant pas d'exploiter pleinement leur vaste potentiel.

Son équipe a donc créé une IA qui apprend directement à partir des indicateurs du bonheur humain. Ces données ont été utilisées pour son entraînement, parallèlement aux datasets généralement utilisés pour les autres IA multimodales.

Ainsi, EVI est capable de reconstruire les préférences humaines et de mettre à jour ses connaissances pour chaque nouvelle personne avec laquelle elle parle et chaque application à laquelle elle est intégrée.

De son côté, Cowen est convaincu que les interfaces vocales seront très bientôt la façon dont nous interagissons par défaut avec l'IA. Pour cause, nous parlons quatre fois plus vite que nous tapons sur un clavier.

Cette approche permet aussi de libérer les yeux et les mains, et de véhiculer davantage d'informations via le ton, le rythme ou le timbre de la voix.

Quelles sont les applications possibles pour le futur ?

À l'avenir, une telle IA pourrait par exemple être utilisée par les Call Centers pour répondre à la colère des clients avec empathie et compréhension.

Elle pourrait également détecter les signes précoces de détresse émotionnelle ou de troubles mentaux chez les individus, et fournir des conseils, des ressources pour les aider ou même alerter les professionnels lorsque cela est nécessaire.

Dans le domaine de la formation ou du coaching professionnel, l'IA empathique pourrait analyser les réactions émotionnelles des apprenants ou des clients et ajuster son approche pour mieux répondre à leurs besoins. Cela favoriserait un apprentissage ou un développement plus efficace.

On peut également envisager la façon dont EVI peut aider les enseignants à comprendre les émotions des élèves dans les environnements éducatifs pour ajuster leurs méthodes d'enseignement afin de favoriser l'engagement et la performance académique.

La compréhension des émotions pourrait aussi être particulièrement utile pour améliorer l'interaction humain-robot dans les contextes de soins aux personnes âgées ou handicapées.

Un autre cas d'usage pourrait être le soutien émotionnel aux patients souffrant de maladies chroniques, de troubles de l'humeur ou de conditions de santé mentale.

De manière générale, une telle IA pourrait permettre d'humaniser davantage les robots afin de rendre les interactions plus saines et naturelles. Néanmoins, on peut aussi craindre qu'elle soit exploitée par les publicitaires ou les politiciens pour nous manipuler en jouant sur nos émotions…

Bientôt une IA similaire par OpenAI ?

Même si EVI propose une approche innovante, OpenAI a récemment dévoilé Voice Engine : une IA capable de reconnaître et d'imiter n'importe quelle voix, de traiter les commandes vocales et de convertir le texte en discours oral.

Elle peut générer de la voix et de l'audio à partir de prompts textuels, oraux ou visuels. Lors d'une récente interview avec Bill Gates, le CEO Sam Altman a souligné l'importance de la multimodalité pour l'IA.

D'ailleurs, GPT-5 sera également capable de générer de la vidéo ou de l'audio en plus du texte. Cette IA sera aussi axée sur la personnalisation et la connaissance de l'utilisateur.

Déjà l'an dernier, OpenAI a lancé un assistant vocal dans l'application ChatGPT pour Andorid et iOS afin de permettre aux utilisateurs de s'engager dans des conversations orales avec l'IA.

Récemment, la firme a noué un partenariat avec Figure AI pour incorporer ChatGPT aux robots humanoïdes 01. Dans la vidéo de démonstration, le robot parvient à prendre une voix naturelle grâce à ses intonations et ses interruptions volontaires…

Comment tester EVI dès maintenant ?

Vous pouvez commencer à tester EVI dès maintenant sur le site officiel hume.ai en suivant ce lien. Autorisez le microphone si nécessaire, et commencez à parler.

L'IA va répondre, et l'écran montrera visuellement votre ton et votre état émotionnel. Dans la mesure du possible, évitez tout de même de dévoiler des informations sensibles…

Par ailleurs, EVI sera également mis à disposition d'autres entreprises pour l'utiliser dans leurs propres produits !

Outre l'interface publique, l'API permet d'intégrer cette IA à d'autres applications en toute simplicité. On peut donc s'attendre à ce que de nombreuses entreprises adoptent ce nouveau chatbot…

- Partager l'article :