Afin d’apprendre aux robots à prendre des objets dans les mains des humains, les chercheurs de Nvidia se tournent vers l’intelligence artificielle. Une IA a été développée pour reconnaître les différentes manières de tendre un objet et s’y adapter en temps réel.

Au fil des années à venir, la collaboration entre humains et robots, notamment dans les entrepôts, va continuer à se développer. Les Hommes et les machines seront de plus en plus souvent amenés à se côtoyer et à travailler ensemble.

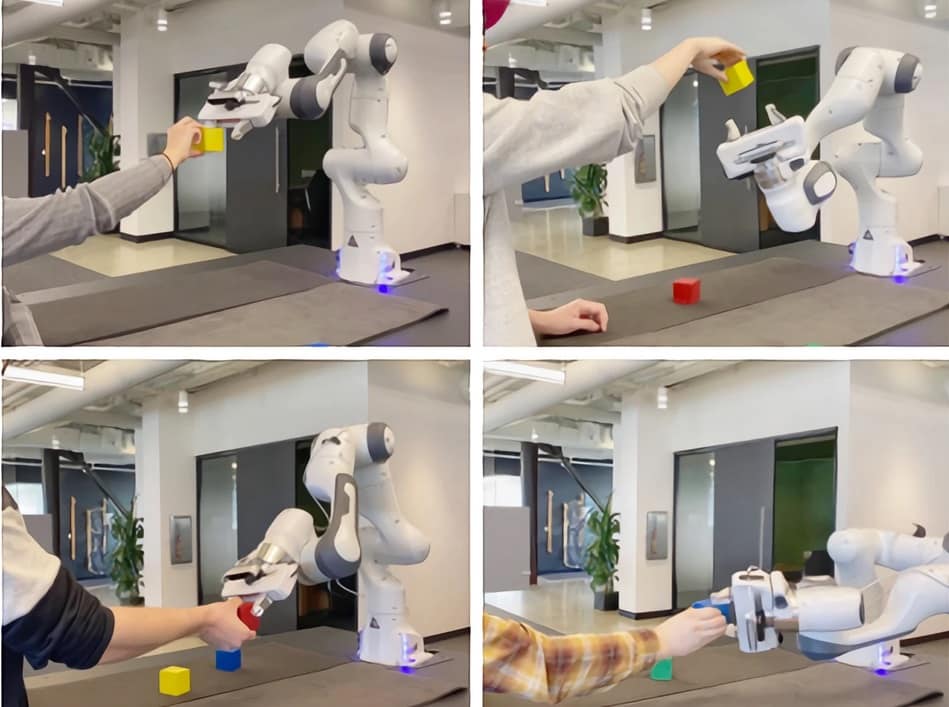

Dans ce contexte, les chercheurs de Nvidia utilisent l’intelligence artificielle pour apprendre aux robots à saisir un objet tendu par un humain de façon plus naturelle. Les travaux ont été publiés dans un article paru cette semaine sur Arxiv.org.

De nombreux chercheurs tentent d’améliorer la façon dont les robots tendent les objets aux humains. Cependant, contrairement à ce que l’on pourrait penser, il n’est pas toujours évident pour un humain de placer un objet dans la main d’un robot.

La précision de la pose de l’objet peut être affectée par l’occlusion, et l’humain doit généralement prêter attention à une autre tâche tout en transférant l’objet. La productivité peut donc s’en trouver réduite.

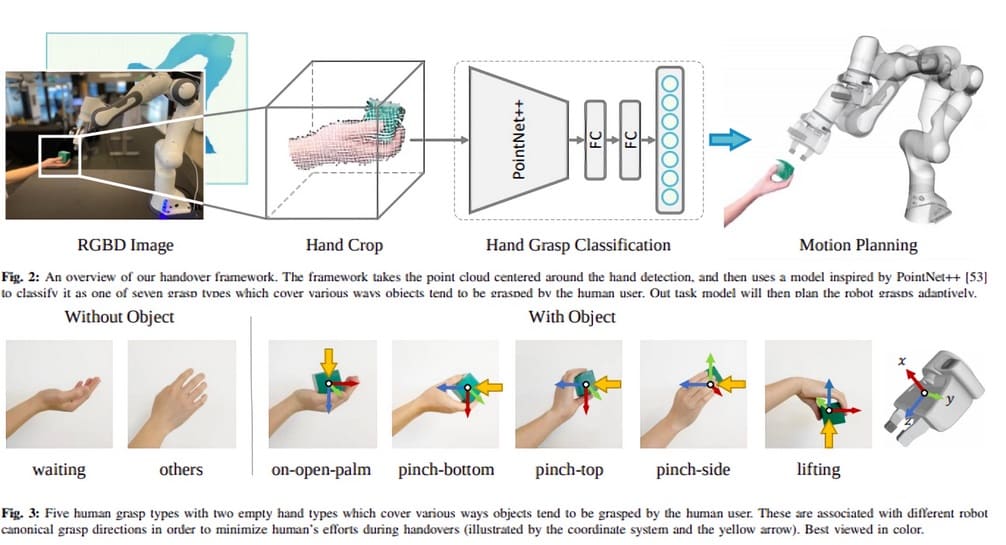

Pour remédier à ce problème, l’approche de Nvidia consiste à ce que le robot classifie la saisie de l’humain et planifie sa trajectoire pour prendre l’objet dans la main de ce dernier. Ainsi, l’équipe de chercheurs a décomposé les façons dont un humain peut tenir des petits objets en plusieurs catégories. Par exemple, lorsqu’une main saisit un bloc, elle peut être catégorisée » paume ouverte « , » pincement » vers le bas, le haut ou le côté, ou encore » soulèvement « .

Nvidia entraîne son IA à reconnaître les saisies d’objet avec une caméra Microsoft Kinect

Par la suite, une caméra Microsoft Azure Kinect a été utilisée pour compiler un ensemble de données afin d’entraîner le modèle IA à classifier une main tenant un objet dans l’une de ces différentes catégories. Pour chacune d’entre elles, une personne a été chargée de saisir un objet pendant 20 à 60 secondes tout en bougeant son corps et sa main dans différentes positions afin de diversifier les angles de la caméra. Au total, la main gauche et la main droite ont été capturées 151 551 fois pour chaque type de saisie.

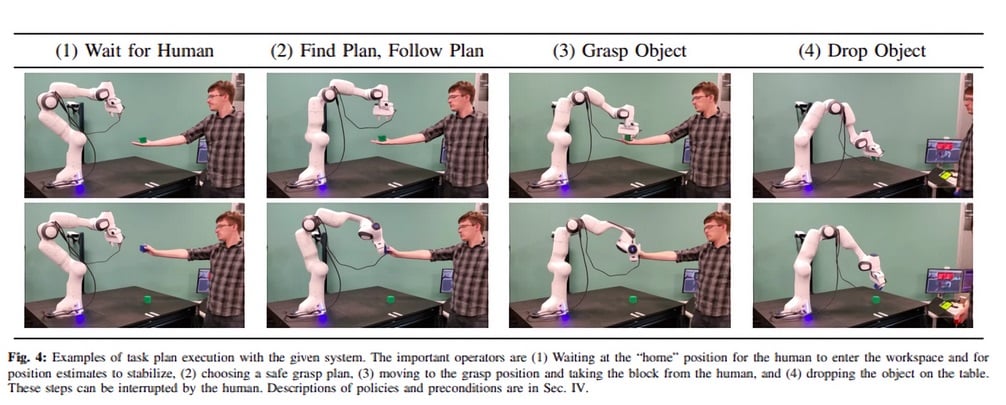

La tâche a été modélisée sous forme de » système logique-dynamique robuste » générant des projets de mouvement pour éviter le contact entre le robot et la main en fonction de la classification. Ce système s’adapte aux différentes possibilités de saisie et réagit en choisissant la meilleure façon d’approcher l’humain et de lui prendre l’objet. Jusqu’à obtenir une estimation fiable de la façon dont l’humain veut présenter le bloc, il reste en position initiale et attend.

Lors d’expériences menées avec deux robots Panda de Franka Amika, les auteurs de l’étude ont pu constater que leur méthode augmente le taux de réussite et réduit le temps d’exécution et la durée des essais par rapport aux approches existantes. Son taux de succès pour la saisie s’élève à 100% contre seulement 80% pour la meilleure méthode jusqu’à présent. La planification quant à elle atteint un taux de succès de 64,3% contre seulement 29,6%. En outre, seules 17,34 secondes sont nécessaires pour planifier et exécuter les actions contre 20,93 secondes pour le deuxième système le plus rapide.

A l’avenir, les chercheurs de Nvidia prévoient de permettre aux systèmes d’apprendre différents types de saisie à partir de données plutôt que de règles spécifiées manuellement. Ainsi, les robots pourraient réagir de façon plus naturelle à n’importe quelle façon dont un objet est tendu…

- Partager l'article :