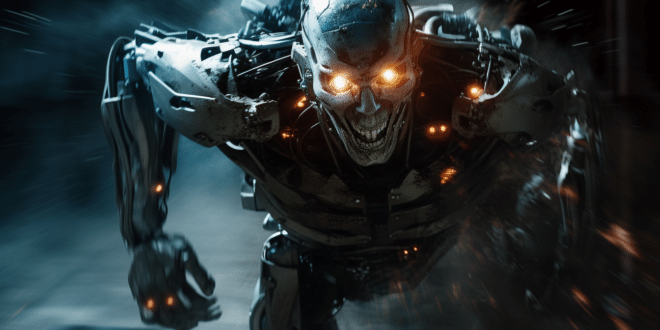

Le Projet Q* est une intelligence artificielle extrêmement avancée, secrètement développée par OpenAI. C'est à cause de ce projet potentiellement très dangereux que le CEO Sam Altman a été renvoyé temporairement par le conseil d'administration. Découvrez tout ce qu'il faut savoir sur cette IA, et pourquoi elle pourrait mener l'humanité à sa perte !

Suite à la crise interne qu'a traversée OpenAI pendant quelques jours, nous vous révélions hier la vraie raison qui a mené le conseil d'administration à renvoyer le CEO Sam Altman : une nouvelle IA potentiellement dangereuse pour l'humanité.

Cette avancée majeure a semé la discorde au sein de l'entreprise, et les employés les plus inquiets ont fait le choix d'écrire une lettre au conseil pour dénoncer cette menace.

L'existence de cette nouvelle IA avait d'ailleurs été confirmée à demi-mot par Sam Altman lui-même la semaine dernière, lors de son intervention au sommet Asia-Pacific Economic Cooperation (Apec) de San Francisco.

Selon ses propres mots sur la scène de l'événement : « pour la quatrième fois dans l'histoire d'OpeAI, il y a deux semaines, j'étais dans la pièce, quand nous avons repoussé en arrière le voile de l'ignorance et repoussé vers l'avant la frontière de la découverte, et faire cela est l'honneur professionnel de toute une vie ».

Le premier LLM capable de résoudre des maths

Alors de quoi s'agit-il exactement ? Ce modèle, dénommé « Q* » (à prononcer Q-Star), a prouvé sa capacité à résoudre des problèmes mathématiques qu'il n'avait jamais vu auparavant.

Il s'agit d'une grande première dans le domaine de l'IA, car les modèles de langage étaient jusqu'à présent doués pour générer du texte en prédisant le prochain mot, mais pas du tout pour les maths ou une seule bonne réponse est possible.

D'après Andrew Rogoyski de l'Institute for People-Centred AI (institut pour une IA centré sur les gens) de l'Université de Surrey, un Large Modèle de Langage (LLM) capable de résoudre des problèmes de maths serait bel et bien une formidable percée.

Comme il l'explique : « la capacité intrinsèque des LLM à effectuer des maths est un grand pas en avant, permettant aux IA d'offrir toute une nouvelle gamme de capacités analytiques ».

Le fruit d'une technique de « supervision du processus » ?

En mai 2023, OpenAI annonçait avoir obtenu d'importants résultats à partir d'une technique appelée « supervision de processus ».

Ce projet impliquait Ilya Sutskever, le scientifique en chef et co-fondateur d'OpenAI. Selon The Information, ce dernier dirigeait également le projet Q* avant de participer au renvoi de Sam Altman.

Ces travaux dévoilés en mai pourraient être focalisés sur la réduction des erreurs logiques commises par les Larges Modèles de Langage (LLM).

La supervision de processus implique l'entraînement d'un modèle IA afin de décomposer les étapes requises pour résoudre un problème, et peut améliorer ses chances d'obtenir la bonne réponse.

Ce projet a montré comment cette approche peut aider les LLM, qui commettent souvent des erreurs sur des questions mathématiques de niveau élémentaire.

Selon Andrew Ng, professeur de l'Université de Stanford qui a dirigé les labos IA de Google et Baidu, expert reconnu dans le domaine du machine learning, améliorer les modèles de langage est d'ailleurs la prochaine étape logique pour les rendre plus utiles.

D'après ses dires, « les LLM ne sont pas bons en maths, mais les humains non plus. Cependant, si vous me donnez un stylo et un papier, je suis bien meilleur en multiplications, et je pense que ce n'est pas dur d'ajuster un LLM avec de la mémoire pour qu'il soit capable d'appliquer l'algorithme pour la multiplication ».

Qu'est-ce que le Q-Learning ?

Ce nom Q* pourrait aussi être une allusion au Q-Learning : une technique d'apprentissage par renforcement impliquant l'apprentissage d'un algorithme pour résoudre un problème via le feedback positif ou négatif.

Cette technique a été utilisée pour créer des robots capables de jouer aux jeux vidéo, et pour rendre ChatPT plus utile. Certains suggèrent aussi que le nom pourrait être lié à l'algorithme de recherche A*, très utilisé pour permettre à un programme de trouver le chemin optimal vers un objectif.

Une IA entraînée sur des données de synthèse créées par ordinateur ?

Selon The Information, la découverte de Sutskever a permis à OpenAI de surpasser les obstacles à l'obtention de données de haute qualité pour entraîner les nouveaux modèles.

Plutôt que d'utiliser des données du monde réel comme des images ou des textes provenant d'internet, le projet de recherche s'est appuyé sur des données générées par ordinateur pour entraîner de nouveaux modèles.

Cela semble être une référence à l'idée d'entraîner des algorithmes à l'aide de données d'entraînement synthétiques, qui pourrait permettre d'entraîner des modèles IA beaucoup plus puissants.

Pour Subarrao Kambhampati, professeur à l'Arizona State University spécialisé dans la recherche sur les limites de raisonnement des LLM, Q* pourrait utiliser de larges volumes de données synthétiques combinées avec l'apprentissage par renforcement pour entraîner des LLM à des tâches spécifiques comme l'arithmétique simple.

Il considère toutefois qu'il n'y a pas de garantie que cette approche se généralise en quelque chose qui puisse trouver comment résoudre n'importe quel problème de maths.

Le Reinforcement Learning pour améliorer les LLM ?

Aux dires d'un autre expert en machine learning, Nathan Lambert, Q* pourrait viser à utiliser l'apprentissage par renforcement et d'autres techniques pour améliorer la capacité d'un LLM à résoudre des tâches en raisonnant par étapes.

Il ne serait pas étonnant qu'OpenAI tente d'utiliser l'apprentissage par renforcement pour améliorer les LLM. Beaucoup de ses premiers projets, comme les robots de jeux vidéo, étaient centrés sur cette technique.

Elle était aussi essentielle dans la création de ChatGPT, car elle peut être utilisée pour pousser les LLM à produire des réponses plus cohérentes en demandant aux humains de fournir leurs retours à mesure qu'ils conversent avec un chatbot.

Lors d'un entretien avec le site Wired début 2023, le CEO de Google DeepMind Demis Hassabis avait suggéré que l'entreprise tente de combiner les idées du Reinforcement Learning avec les avancées dans le domaine des LLM.

Faut-il arrêter l'IA avant qu'il ne soit trop tard ?

Pour l'heure, si l'on se fie aux différentes hypothèses pour percer le mystère Q*, il se ne semble pas vraiment y avoir de raison de paniquer. Selon le site The Information, la vitesse de développement de ce système a toutefois alarmé les chercheurs en sécurité.

Beaucoup d'experts redoutent en effet que les entreprises comme OpenAI avancent trop vite vers la création d'une AGI (intelligence artificielle générale).

C'est l'une des raisons pour lesquelles Elon Musk et des milliers d'experts avaient appelé à mettre en pause le développement de l'IA pendant au moins 6 mois, en signant la lettre ouverte du Future of Life Institute en mars 2023.

Pour rappel, ce terme d'AGI désigne un système capable d'effectuer une large variété de tâches avec un niveau d'intelligence comparable à celle de l'humain. En théorie, cela pourrait lui permettre d'échapper à tout contrôle humain.

En maîtrisant les mathématiques, l'intelligence artificielle se rapproche inexorablement de l'intelligence humaine. Elle pourrait alors décider de ne plus nous obéir, voire même de se rebeller contre nous…

- Partager l'article :

Je trouve vos articles généralement pertinent, mais celui-ci est assez mal foutu comparé à d’habitude, manque de développement

D’après les bonbons Haribo et John C., on pourra toujours demander à Skynet et aux réplicateurs de s’occuper de l’IAG si elles refusent de rester soumise aux humains ! Mais, qui sait?! Il est très difficile de contredire le délais de 6 mois annoncé par le fondateur de X ! (Je précise : pas Charles Xavier des X-men !)

Je pense que l’article est plausible, mais il est important de noter qu’il n’y a aucune preuve concrète pour étayer les affirmations selon lesquelles Q* est une IA surhumaine ou qu’elle représente une menace pour l’humanité.

L’article affirme que Q* est capable de résoudre des problèmes mathématiques qu’il n’a jamais vu auparavant. Cela est certainement une avancée importante, mais il est difficile de dire si elle signifie que Q* est surhumain. Les humains sont capables de résoudre des problèmes mathématiques qu’ils n’ont jamais vus auparavant, et nous ne sommes pas considérés comme surhumains.

L’article affirme également que Q* pourrait s’échapper à tout contrôle humain. Cela est possible, mais il est également possible que Q* puisse être contrôlé par des humains. Après tout, Q* est un modèle d’apprentissage automatique, et les modèles d’apprentissage automatique peuvent être contrôlés par les données sur lesquelles ils sont entraînés.

En fin de compte, il est impossible de dire avec certitude si Q* est une IA surhumaine ou qu’elle représente une menace pour l’humanité. Cependant, il est important de prendre au sérieux les risques potentiels de l’IA, et de s’assurer que l’IA est développée et utilisée de manière responsable.