Nvidia dévoile DrEureka : une IA de type LLM (large modèle de langage) capable d'écrire du code pour entraîner les robots dans une simulation et transférer les compétences acquises dans le monde réel. Découvrez tout ce qu'il faut savoir !

Quelle est la meilleure façon d'apprendre aux robots efficacement et rapidement ? Voilà une question clé pour le futur, notamment celui des robots humanoïdes généralistes capables d'effectuer n'importe quel travail manuel.

En octobre 2023, Nvidia dévoilait sa plateforme Eureka : une plateforme IA basée sur un système de récompenses, permettant d'entraîner les robots.

À présent, la firme dévoile DrEureka : un agent LLM (large modèle de langage) dérivé de cette plateforme. Il est spécialisé dans l'écriture de code pour apprendre de nouvelles compétences aux robots au sein des simulations.

Tout le processus est entièrement automatisé, de l'acquisition initiale de la compétence à son implémentation dans le monde réel. Ceci permet une transition fluide des environnements virtuels vers le déploiement concret.

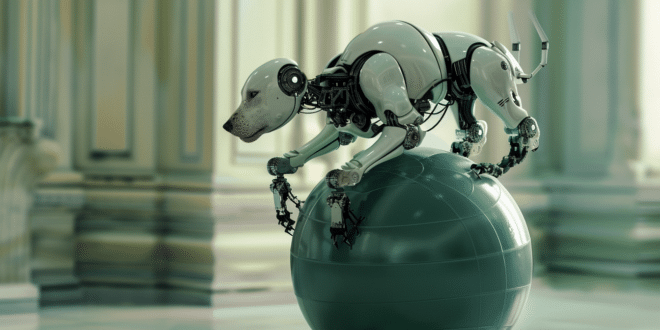

À l'aide de cette IA, les chercheurs Nvidia ont pu entraîner un chien robot dans une simulation afin qu'il apprenne à tenir en équilibre et à marcher sur un ballon de yoga.

Entraîné en simulation, le robot réussit du premier coup dans le monde réel

Ils ont ensuite transféré cette capacité dans le monde réel, et le robot quadrupède est parvenu à compléter la tâche dès sa première tentative. Il n'y a même pas eu besoin de fine-tuning !

Auparavant, toutes les méthodes visant à transférer l'apprentissage du virtuel vers le réel nécessitaient une configuration manuelle et un ajustement des fonctions de récompenses et des paramètres physiques de la simulation.

De fait, les progrès étaient lents et demandaient beaucoup d'efforts humains. Comme l'explique Jim Fan, directeur de la recherche chez Nvidia, le transfert est traditionnellement accompli via la « randomisation de domaine ».

Il s'agit d'un processus fastidieux, exigeant que les roboticiens humains vérifient et ajustent chaque paramètre manuellement. Or, DrEureka propose une toute autre approche.

Le LLM commence par prendre les instructions sur la tâche, ainsi que le code source de l'environnement. Il initie ainsi Eureka, qui se charge de produire une stratégie et une fonction de récompense standardisée.

Ces dernières sont testées dans diverses conditions de simulation, pour développer un préalable de physique sensible aux récompenses.

Ceci est ensuite utilisé par le LLM DrEureka pour générer une gamme de paramètres de randomisation de domaine. Enfin, les récompenses synthétisées et les paramètres sont exploités pour apprêter les compétences au déploiement dans le monde réel.

En effet, les LLM de pointe comme GPT-4 sont équipées d'une compréhension native des concepts physiques comme la friction, la gravité, l'amortissement et la rigidité. Le DrEureka peut donc ajuster ces paramètres et expliquer son raisonnement.

DrEureka : une approche innovante et largement plus performante

Pour évaluer la locomotion quadrupède, les chercheurs ont testé les stratégies de DrEureka sur différents types de terrains du monde réel.

Les résultats ont démontré des performances nettement supérieures aux stratégies entraînées à l'aide de récompenses et de paramètres de randomisation conçus manuellement

C'est ainsi que le chien robot a pu apprendre à marcher en équilibre sur un ballon de yoga dans une grande variété de terrains, malgré des changements de conditions et des perturbations.

De plus, DrEureka surpasse Eureka en termes de conception de récompenses par sa capacité à intégrer les instructions de sécurité : un point très important pour le déploiement dans le monde réel.

Selon les auteurs de l'étude, cette approche est très prometteuse pour accélérer l'acquisition de compétences par les robots.

Pour le futur, ils ont de nombreuses idées pour continuer d'améliorer DrEureka. Même si ses stratégies ne sont entraînées que dans la simulation pour le moment, utiliser les échecs dans le monde réel en guise de feedback pourrait aider les LLM à mieux ajuster leurs méthodes « sim-to-real » sur les itérations suivantes.

De plus, toutes les tâches et stratégies présentées dans l'étude reposaient seulement sur les inputs des capteurs internes du robot. L'intégration de la vision et d'autres capteurs pourraient améliorer la performance des stratégies et la boucle de feedback du LLM.

Pour plus d'informations, vous pouvez consulter cette étude menée par des chercheurs de Nvidia, de l'Université du Texas et de l'Université de Pennsylvanie publiée sur GitHub en suivant ce lien.

Si ce sujet vous intéresse, retrouvez aussi notre article sur le robot Figure 01 fusionné avec ChatGPT et notre article sur Nvidia GR00T : l'IA qui servira de cerveau aux robots du futur…

- Partager l'article :