Le mardi 2 avril 2019 se tenait la version parisienne du AWS Summit. L'événement rassemblait 6 000 visiteurs autour des technologies du géant du Cloud. Voici ce qu'il faut retenir de ce sommet parisien.

La grande tournée AWS Summit a commencé la semaine dernière à Santa Clara. Le géant du Cloud a profité de ce premier événement pour présenter ses nouveautés technologiques et les partenariats établis avec de grands groupes, notamment Standard Bank et Volkswagen.

Logiquement, on ne s'attendait pas à de grandes annonces lors du AWS Summit parisien s'étant déroulé hier. La division technologique de la firme de Jeff Bezos a tout de même annoncé un partenariat avec l'École d'Affaires publiques de Sciences Po. Le laboratoire d'innovation publique utilisera les services du fournisseur de Cloud afin de réaliser des prototypes dans les domaines de la santé des personnes âgées, la mobilité des citoyens et la gestion des Jeux olympiques de 2024. L'objectif, imaginer des solutions de demain qui transformeront l'administration française.

Hormis cette actualité, la conférence d'ouverture se résumait à la présentation du catalogue des services entrecoupés de retours d'expérience. Malheureusement, Adrian Cockcroft, Vice President Cloud Architecture Strategy chez AWS n'a pas réussi à maintenir l'attention de l'assemblée, qui au bout de deux heures commençait à sortir de la grande salle du Palais des Congrès. En revanche, les interventions d'Antoine Larmanjat, CIO chez Euler Hermes, de Florian Douetteau, cofondateur et CEO de Dataiku et de Gilles Chevry, responsable de l'infrastructure de l'éditeur de jeux mobile Gameloft se sont avérés fort instructives.

“Grosso Modo”, les porte-paroles expliquaient en quoi les technologies proposées par AWS accélèrent leur transformation et celles de leurs clients. Antoine Larmanjat a notamment évoqué la transformation du groupe spécialisée dans l'assurance-crédit pour les entreprises. Il doit notamment faire face à des contraintes liées à la gestion des transactions de 30 millions de sociétés. Selon le CIO, 82 % d'entre elles sont réalisées en temps réel. Cela demande donc une logistique informatique solide, “une transformation IT assez profonde”, déclare-t-il. “Le Cloud devient une évidence, parce que c'est très important pour nous de répondre rapidement aux demandes de nos clients et de leur fournir des outils sans les faire attendre”.

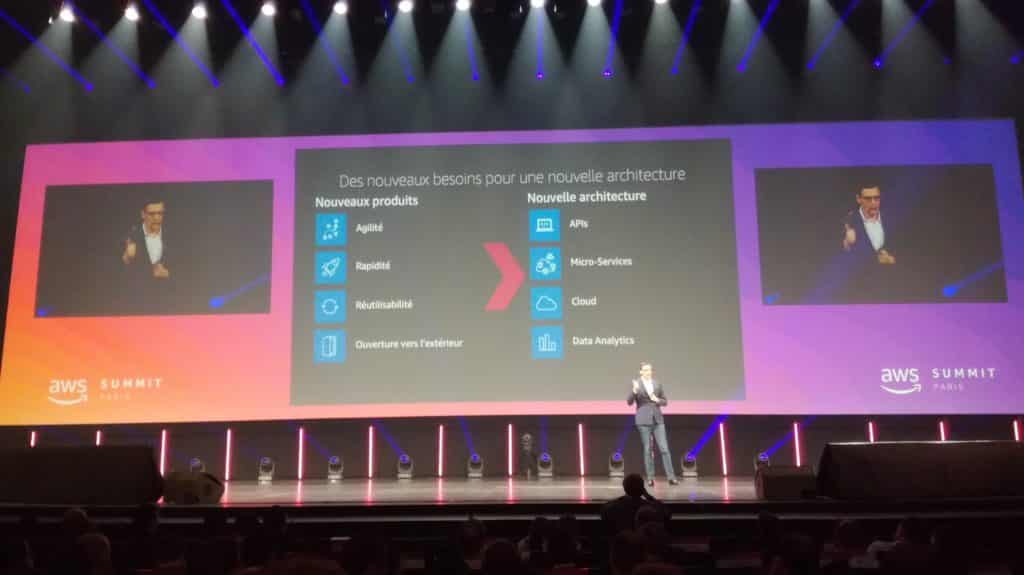

AWS Summit : Euler Hermès fait émerger de nouveaux services grâce au Cloud

Antoine Larmanjeat évoque les quatre piliers de cette transformation. Premièrement, Euler Hermès mise sur la conception d'API qui s'interfacent aux systèmes d'informations de ses clients, notamment dans les marketplaces, les ERP et les plateformes. Ensuite, l'entreprise “a cassé ses monolithes en petits morceaux” grâce aux microservices. “Cela nous permet de tirer la meilleure valeur des fonctionnalités de nos applications”, assure le CIO. Le Cloud s'avère être le troisième élément cité. Enfin, la data analytics anime l'entreprise afin de suivre au mieux les interactions avec ses clients.

Le choix d'AWS correspond à cette démarche. Euler Hermes voulait être “Serverless First”. Ensuite, elle ne voulait pas déployer et agrandir les containers par elle-même, mais plutôt de profiter des services gérés par le spécialiste du Cloud. L'utilisation d'une infrastructure plus classique comme les instances EC2 se fait quand elle ne peut pas utiliser les deux premières solutions. L'entreprise utilise notamment les services Lambda, des containers ECS avec Fargate et des bases de données gérées comme DynamoDB. “De même, nos applications sont adaptées aux exigences du Cloud avant leur migration”, affirme Antoine Larmanjeat.

L'adoption de la culture DevOps et des technologies ont permis une meilleure maîtrise des coûts, car chaque élément de l'infrastructure est répertorié. Surtout, cela permet de proposer de nouveaux produits. Euler Hermès a notamment lancé en octobre 2018 Single Invoice Cover. Cet API permet à une fintech d'assurer une transaction en temps réel en vérifiant si elle est assurable contre le risque d'impayé et à quel tarif. La filiale d'Allianz propose également Ma Caution en Ligne, une plateforme Web qui permet aux acteurs du BTP de souscrire à des cautions de marché unitaires en ligne afin d'accéder à la totalité de la somme prévue à la livraison du chantier. En effet, les donneurs d'ordre appliquent en général une retenue de 5 % du budget total pour se protéger des malfaçons. Auparavant, cette démarche de souscription à une assurance demandait du temps. Aujourd'hui, tout se règle en dix minutes, d'après la communication d'Euler Hermès.

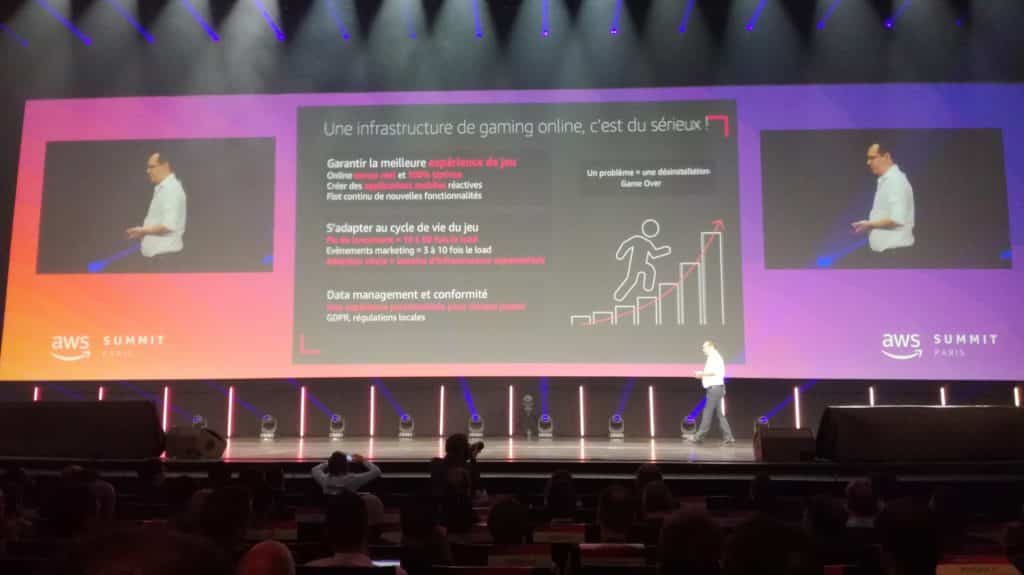

Gameloft : du jeu premium au freemium online, il y a le Cloud

Un autre acteur a vanté les services AWS comme vecteur de transformation numérique : Gameloft. L'éditeur de jeux mobile racheté par Vivendi en 2016 gère pas moins de 190 titres, et emploie plus de 4600 développeurs dans 19 studios. L'émergence des expériences en ligne l'a d'abord poussé à passer d'un modèle premium au freemium. Évidemment,cela lui a permis de s'imposer comme le grand champion du jeu mobile. Selon Gilles Chevry, responsable de l'infrastructure chez Gameloft, la société a dû petit à petit faire grossir ses salles serveur. Finalement, elle a mis en place trois centres de données pour couvrir le monde. Deux d'entre eux sont d'ailleurs installés en Chine centrale et en Asie, le troisième au Canada. Malheureusement, l'expérience utilisateur en a pâti pendant un temps.

L'installation progressive de serveurs a évidemment pesé sur les finances de l'entreprise : “On a racké, on a racké, mais au final qu'est-ce que l'on a raqué”, plaisante Gilles Chevry. Enfin, les équipes en charge de construire la plateforme de jeux ne se concentraient plus sur l'innovation, mais sur la maintenance et la stabilité opérationnelle. Le lancement de nouveaux jeux, les pics de téléchargements, les événements spéciaux, les modes en ligne de plus en plus sophistiqués ont finalement créé “de la dette technique”. Il fallait réagir. Gameloft a donc migré la partie Game Server, là où les joueurs viennent se connecter, vers les infrastructures AWS Cloud, en Virginie du Sud.

Petit à petit, les problèmes de latences rencontrés à travers le monde ont incité l'éditeur à augmenter son panier client chez le fournisseur. L'ouverture de la région à Paris et les autres structures ont permis d'améliorer le service en ligne avec une seule communauté mondiale, diminuer les coûts et d'alléger la charge de travail de l'équipe. “Nous n'avons plus à jouer au devin pour estimer le succès d'un jeu. Nous disposons d'une infrastructure flexible qui nous permet de nous adapter à la vie d'un titre”, explique le responsable infrastructure. De plus, les conseils et le support fournis permettent de s'adapter à la demande du marché.

AWS Summit : For Honor, sauvé par des serveurs dédiés

En dehors de la conférence, des développeurs de For Honor édité par Ubisoft présentaient leur titre commercialisé depuis février 2017. Eux aussi, ils ont dû faire face à des problèmes liés au mode en ligne. En effet, celui-ci utilisait la connexion peer to peer. Cela permet de relier les joueurs dans les meilleures conditions possibles dans le cadre d'un affrontement un contre un. C'est la méthode utilisée par la plupart des studios japonais comme ceux de Capcom, en charge de la série Street Fighter.

Or, le coeur du titre se trouve dans son mode Domination qui rassemble huit joueurs. Malheureusement, si l'un d'eux quittait la partie avant la fin, cela provoquait des instabilités de connexion, voire une interruption de service. Ce problème repéré lors de la bêta, puis devenu réellement problématique au lancement du jeu a poussé les équipes de développement à utiliser les instances de serveurs dédiés d'AWS pour les modes à plus de deux participants.

Les parties en Duel profitent, elles, d'une connexion P2P. Cette transition a tout de même duré huit mois, de la prise de décision à la mise en place des serveurs auprès des utilisateurs, selon les dires des membres de l'équipe. En octobre dernier, For Honor dépassait les 15 millions de joueurs, preuve du succès de cette transition.

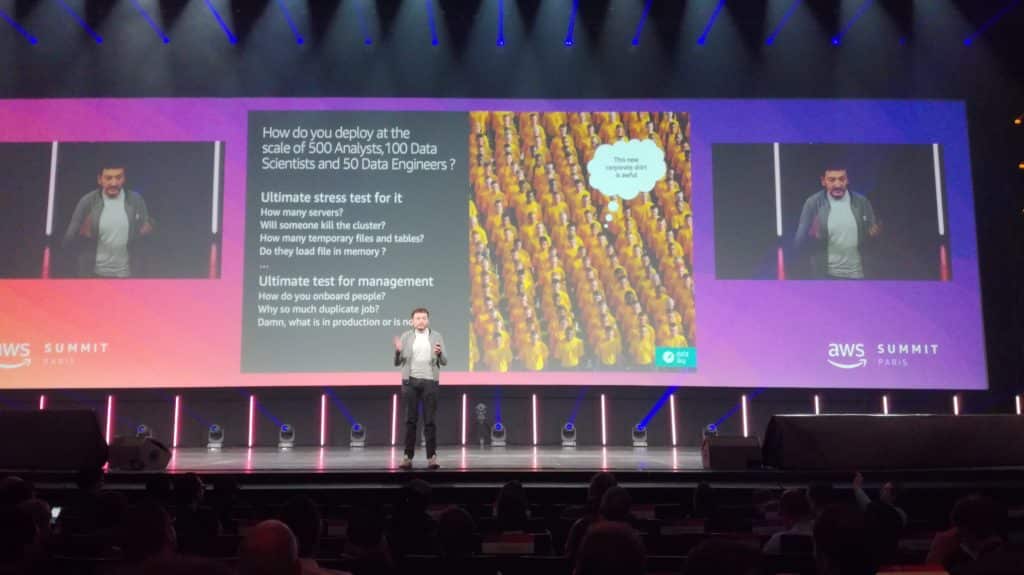

AWS Summit : Dataiku veut rendre la data analytics collaborative

Dans un domaine tout à fait différent, Florian Douetteau, cofondateur et PDG de Dataiku, venait présenter sa vision de l'analytique et du machine learning. L'éditeur conçoit une plateforme collaborative de data science afin de faciliter la conception d'outils d'analyse de données et de modèles algorithmiques en mode itératif.

Cela permet de développer des applications pour les divisions marketing qui analysent et prédisent les résultats des campagnes. Dans l'industrie de haute technologie comme la fabrication des téléphones, des avions ou des véhicules, les sociétés optimisent les coûts et le suivi de la conception. Enfin, les services financiers effectuent de la détection de fraude.

Lors de la conférence d'ouverture, le responsable appuyait sur l'interdépendance entre les analystes, les développeurs, et les data scientists. L'outil proposé par sa société permet notamment d'avoir “une vision unique” des éléments en production, en test ou en cours de conception. Parmi les 200 clients et 20 000 utilisateurs, plus de 50 % d'entre eux font leurs calculs dans le Cloud. “Ce n'était pas le cas il y a 18 mois”, assure Florian Douetteau.

En effet, avec Dataiku, les processus d'analyse sont principalement effectués sur des infrastructures on premice existantes des entreprises, comme des clusters Hadoop maîtrisés par le département IT d'une entreprise. Petit à petit, ces éléments sont transférés dans le Cloud.

Dataiku se connecte nativement aux clusters Amazon EMR (Elastic MapReduce) ainsi que sur Redshift et sur les clusters Kubernetes S3 Stockage. “EMR est utilisé pour des transformations de données lourdes, potentiellement sur des bases de données non structurées”, nous précise le PDG en entretien. Redshift permet de réaliser les mêmes calculs utilisés dans la business intelligence. Les clusters Kubernetes exécutent eux des processus de machine learning qui peuvent appeler des outils basés sur TensorFlow, par exemple, et supporter des environnements de programmation interactifs en Python en R ou en Scala.

Mais le “Full Cloud” n'est pas la norme. “Les infrastructures hybrides sont majoritairement utilisées par les grands groupes”. Selon le PDG de Dataiku, c'est un choix rationnel des entreprises qui doivent faire face à des contraintes réglementaires fortes et respecter des processus internes. De même ceux qui ont commencé la migration de leurs outils traditionnels, lancent leurs nouvelles applications nativement dans le Cloud et vivent un entre-deux.

“Cela peut créer des frictions dans l'adoption des technologies”, déclare Florian Douetteau. Dataiku veut donc proposer une plateforme qui s'adapte à ces contraintes pour continuer à grandir.

La startup qui a levé 101 millions de dollars en série C au cours du mois de décembre espère doubler son nombre de salariés, de clients et son chiffre d'affaires d'ici la fin 2019. “L'enjeu pour Dataiku à l'horizon de trois ans, c'est d'être une entreprise saine et sereine. Nous voulons rester indépendants, probablement passer en bourse et avoir près d'un millier d'employés”, assure le PDG.

L'AWS Summit est un parfait moyen de rencontrer de potentiels clients et “de créer de la notoriété de la marque”. L'autre enjeu pour Dataiku, consiste à gagner de la popularité “en dehors de Paris”, pour cela elle compte attirer du monde lors de ses propres conférences EGG 2019 prévues à New York, Londres et à Paris.

- Partager l'article :