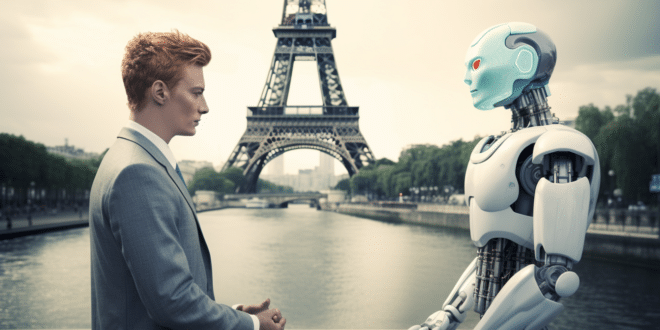

Les détecteurs d'IA jouent un rôle essentiel dans la distinction entre le texte généré par l'homme et celui généré par l'IA. C'est un moyen de garantir l'intégrité et l'authenticité du contenu. Seulement voilà, une récente étude met en garde sur un biais de certains détecteurs d'IA qui discriminent les Français.

Détecteurs d'IA : des problèmes de précision évidents

L'IA générative a le potentiel de transformer la façon dont les entreprises interagissent avec les clients et de stimuler leur croissance. Dans le secteur de l'enseignement par contre, même si ces outils peuvent booster la créativité des étudiants, les outils de type ChatGPT peuvent exacerber la tricherie.

Face à quoi, les établissements d'enseignement adoptent de plus en plus les détecteurs d'IA pour s'assurer de l'originalité d'un contenu. La plupart des détecteurs revendiquent une précision de 99 %, mais une récente étude vient malheureusement prouver le contraire.

D'après une recherche dirigée par le James Zou, professeur adjoint de science des données biomédicales à l'Université de Stanford (Californie, États-Unis), certains détecteurs d'IA manqueraient de précision. Plus précisément, ces outils discriminent les non-natifs anglophones, dont les Français.

De graves problèmes de discrimination pour les non-natifs

Dans cette étude, le professeur Zou a analysé 91 textes en anglais écrits par des anglophones non-natifs avec 7 détecteurs d'IA populaires. Les textes sont exécutés en simulation du TOEFL (Test of English as a Foreign Language ou Test d'anglais langue étrangère, l'équivalent du FLE en français).

Lorsque les textes sont soumis aux détecteurs d'IA, les détecteurs révèlent que les contenus sont à 98 % générés par l'intelligence artificielle. Les mêmes textes, écrits par les anglophones natifs des États-Unis, ont été soumis aux mêmes détecteurs et sont identifiés comme des textes écrits par l'homme.

Ce test met en évidence le biais de discrimination de certains détecteurs d'IA, une limites qui pourrait être propre à tous les outils de détection. Le plus inquiétant reste le fait que les IA génératives peuvent apprendre à déjouer ces détecteurs. D'ailleurs, le professeur Zou l'a prouvé.

Les textes écrits par les non-natifs ont été soumis à des outils de type ChatGPT. Les chercheurs ont demandé à l'IA de réécrire le texte avec un style plus sophistiqué. Après le passage au détecteur d'IA, les contenus créés par l'IA sont identifiés comme générés par l'homme. En somme, les machines peuvent se tromper, mais nous, humains, avons-nous les moyens de détecter ces erreurs ?

- Partager l'article :