Les GPU ou cartes graphiques sont d'une extrême importance dans les domaines du Big Data, du Machine Learning et du Deep Learning. Découvrez tout ce que vous devez savoir sur le rôle majeur des processeurs graphiques dans l'IA et la Data Science.

La Data Science requiert une immense puissance de calcul. De puissantes machines sont requises pour traiter les ensembles de données Big Data ou pour effectuer des calculs sur de vastes matrices.

Par le passé, les Data Scientists exploitaient principalement la puissance des processeurs CPU pour utiliser les bibliothèques en langage Python comme Pandas ou NumPy. Toutefois, les GPU ou Graphics Processing Units, communément appelés processeurs graphiques ou tout simplement cartes graphiques en français, sont de plus en plus utilisés.

Qu'est-ce qu'un GPU ?

Un GPU ou Graphics Processing Unit (processeur graphique ou carte graphique en français) sert à l'origine au rendu graphique. Ce sont ces composants qui permettent à nos ordinateurs d'afficher des images sur les écrans.

On peut considérer le GPU comme une version miniature d'un ordinateur complet, uniquement dédiés à une tâche spécifique. Une carte graphique est équipée de son propre processeur intégré à une carte-mère, couplée à une video RAM et des composants dédiés au refroidissement et à la ventilation.

Le terme » Graphics » fait référence au rendering d'une image à des coordonnées spécifiques dans un espace 2D ou 3D. Les GPU peuvent aussi traiter des formes géométriques complexes, des vecteurs, des sources de lumière, des formes ou encore des textures.

Toutefois, leurs hautes performances et leur coût relativement bas ont amené les Data Scientists à les utiliser pour la science des données. Aujourd'hui, les GPU occupent une place cruciale dans les domaines du Big Data et de l'IA.

Qu'est-ce que le GPU Computing ?

Le GPU Computing consiste à utiliser des processeurs graphiques en complément des CPU pour accélérer les applications de Data Science et de Machine Learning. En effet, un GPU se démarque par son architecture parallèle.

Chaque GPU est composé d'un certain nombre de coeurs, et chacun de ces coeurs a un nombre d'unités fonctionnelles. Pour traiter chaque thread, une ou plusieurs de ces unités fonctionnelles peuvent être utilisées. On appelle ces unités » thread processors « .

Tous les thread processors du coeur d'un GPU partagent la même unité de contrôle. Ils sont donc en mesure d'effectuer la même instruction. Par exemple, dans le cadre du traitement d'image, la même instruction pourra être exécutée sur chaque pixel d'une image en parallèle.

GPU vs CPU

Jusqu'à récemment, les workflows de Data Science reposaient sur les CPU pour charger, filtrer, manipuler les données, ou encore pour entraîner et déployer des modèles de Machine Learning. Toutefois, les CPU ne sont pas adaptés au traitement de volumes massifs de données.

Un ensemble de données de 100GB peut regrouper plusieurs milliards de points de données. Or, même les CPU les plus puissants n'ont pas suffisamment de coeurs pour un traitement parallèle efficace d'un tel volume.

Par exemple, même un CPU à 20 coeurs ne peut traiter que 20 points de données simultanément. Il est préférable d'utiliser un GPU pour de telles tâches.

De manière générale, un CPU peut être considéré comme le cerveau d'un ordinateur, tandis que le GPU agit comme un microprocesseur spécialisé. Le computing » CPU to GPU » permet de gagner en vitesse en combinant les deux puissances de traitement.

Les GPU améliorent l'architecture CPU en accélérant des portions d'une application, tandis que le reste continue à s'exécuter sur le CPU. Un CPU reste un processeur fiable pour les computing généraliste, tandis que le GPU est plus adapté au calcul intensif.

Chaque coeur de CPU est plus rapide et plus performant qu'un coeur de GPU, mais un CPU est limité à quelques dizaines de coeurs. Un CPU excelle pour prendre en charge des tâches multiples, mais un GPU est plus puissant et peut effectuer des tâches spécifiques très rapidement. Avec plusieurs dizaines de milliers de coeurs, un GPU offre un parallélisme massif idéal pour les tâches répétitives et hautement parallèles.

De nombreuses opérations répétitives sont effectuées sont de larges ensembles de données à l'aide de bibliothèques comme Pandas, NumPy ou Scikit-Learn. Un GPU s'avère idéal pour de tels traitements.

Les processeurs graphiques permettent en effet de réduire les coûts en infrastructures. Ils offrent aussi des performances supérieures pour les workflows grâce aux bibliothèques open source RAPIDS. Pour accélérer la Data Science, il est possible d'utiliser un GPU sur un ordinateur, dans un Data Center local, mais aussi sur le Cloud ou sur le Edge.

Comment fonctionne le GPU ? Pourquoi l'utiliser pour le Big Data ?

Les GPU sont très rapides et performants, car ils sont efficaces pour la multiplication de matrices et la convolution. En guise d'explication, on cite souvent le parallélisme. Ce n'est toutefois pas la seule raison.

L'une des caractéristiques du GPU est qu'il est optimisé en bande passante, au contraire du CPU optimisé en latence. On peut donc comparer le CPU à une Ferrari, tandis que le GPU peut être perçu comme un camion.

Le CPU a donc moins de latence, mais sa capacité est inférieure à celle du GPU. En d'autres termes, le CPU peut apporter de petits montants de mémoire rapidement tandis que le GPU peut apporter de larges quantités de mémoires.

Concrètement, les meilleurs CPU ont environ 50GB par seconde de bande passante alors que les meilleurs GPU atteignent 750GB par seconde. Plus une opération de calcul requiert de mémoire, plus un GPU est avantagé face au CPU.

Le problème de la latence est résolu par le parallélisme de threads, reposant sur l'utilisation de multiples GPU. En résumé, les GPU ont l'avantage en termes de bande passante et évitent les inconvénients de latence grâce au parallélisme.

Un autre avantage est que la mémoire L1 des GPU est facilement programmable. Pour toutes ces raisons, les processeurs graphiques sont idéaux pour le Deep Learning et les traitements Big Data.

Les avantages des GPU pour la Data Science

L'utilisation des GPU pour la Data Science comporte plusieurs avantages. Elle permet de réduire le temps passé à attendre pour recevoir des insights, et d'accélérer le retour sur investissement.

L'utilisation est également plus simple. Il est possible d'accélérer l'intégralité de la chaîne d'outils Python grâce une intégration logicielle open-source et des changements de code minimes.

Par ailleurs, l'entraînement des modèles de Machine Learning peut être effectué 215 fois plus rapidement. Davantage d'itérations peuvent être effectuées, plus rapidement pour de meilleurs résultats et des performances accrues.

Enfin, les GPU permettent de réduire les coûts en matière d'infrastructure de Data Science et d'accroître l'efficacité du Data Center. Elle permet aussi de réduire les coûts d'infrastructure du Data Center de façon drastique.

Qu'est-ce que l'analyse de données accélérée par GPU ?

L'analyse accélérée par GPU, aussi appelée GPU analytics, consiste à exploiter le parallélisme massif des cartes graphiques afin d'accélérer les opérations intensives comme la Data Science, le Deep Learning, le Machine Learning ou autres applications Big Data.

Pour faire simple, cette méthode consiste à assigner une portion d'une tâche de calcul intensive à un GPU. Le parallélisme permet de fortement réduire les coûts par rapport à un système analytique traditionnel reposant sur un CPU.

En outre, les Data Scientists sont ainsi dispensés de tâches comme le downsampling, l'indexing, ou la pré-agrégation. Les ensembles de données sont intégralement ingérés par le système, et les utilisateurs peuvent effectuer des requêtes interactives, visualiser les données, et exécuter des workloads de Data Science sur des milliards d'enregistrements.

Les GPU sont devenus essentiels pour traiter de gigantesques ensembles de données et en extraire des insights rapidement et efficacement. En effet, les systèmes analytiques traditionnels ne sont pas capables d'ingérer des millions d'enregistrements par seconde, avec souvent des données spatio-temporelles ou des données non structurées d'une haute complexité.

Les cartes graphiques sont également le meilleur choix pour les architectures Data Lake, consistant à conserver de vastes volumes de données brutes dans leur format natif jusqu'à en avoir besoin. Seul un GPU permet l'analyse de vastes volumes de données sans latence.

Les GPU se distinguent par des fonctionnalités comme le rendering de données server-side et le rendering à grande échelle pour la visualisation de données. Aujourd'hui, l'analyse accélérée par GPU est utilisée dans de nombreuses industries comme la finance, l'automobile, l'énergie, le marketing ou la logistique.

RAPIDS : une suite de bibliothèques pour accélérer la Data Science grâce aux GPU

La suite de bibliothèques logicielle RAPIDS est conçue pour accélérer la Data Science grâce aux GPUS. Elle utilise un code CUDA de bas niveau pour des implémentations d'algorithmes rapides et optimisées par GPU, avec une couche de Python pour conserver une simplicité d'utilisation.

Cette suite d'outil est intégrée avec différentes bibliothèques de Data Science comme Pandas et ses dataframes. Elle exploite par ailleurs plusieurs bibliothèques Python : cuDF pour les DataFrames GPU, cuML pour les algorithmes Machine Learning, ou encore cuGraph pour le traitement de graphiques.

GPU et Deep Learning

Au cours de la dernière décennie, les GPU ont pris une place essentielle dans des domaines comme le jeu vidéo, les cryptomonnaies et les superordinateurs. Toutefois, ils sont aussi très utilisés pour le Deep Learning.

Pour cause, les modèles de Deep Learning requièrent beaucoup de temps pour être entraînés. Les CPU ne sont pas suffisamment efficaces pour effectuer tant de calculs simultanément. Les GPU les surpassent grâce au parallélisme.

Les réseaux de neurones, eux-mêmes, reposent sur le calcul parallèle. Les opérations telles que le calcul de poids et les fonctions d'activation de chaque couche du réseau ou la rétropropagation peuvent être effectués en parallèle.

Qu'est-ce que CUDA ?

Il existe différents frameworks pour la programmation GPU. L'un des plus populaires est CUDA : Compute Unified Device Architecture. Initialement lancé en 2007, ce framework permet d'exploiter pleinement la puissance du GPU pour le calcul parallèle de manière optimisée pour de meilleures performances.

La boîte à outils CUDA est un package complet. Elle se compose d'un environnement de développement, utilisé pour créer des applications reposant sur les GPU. Ce » toolkit » comporte notamment un compilateur C/C++, un débogueur, et des bibliothèques.

Le runtime CUDA a ses propres pilotes, lui permettant de communiquer avec le GPU. En outre, CUDA est aussi un langage de programmation spécialement conçu pour donner au GPU des instructions pour effectuer une tâche.

C'est ce qu'on appelle la programmation GPU. Précisons que le langage CUDA ne peut être utilisé avec les cartes graphiques NVIDIA.

Qu'est-ce que OpenCL ?

L'autre principal framework de programmation GPU est OpenCL. À la différence de CUDA, il s'agit d'un standard ouvert qui n'est donc pas restreint aux puces NVIDIA.

Il permet le calcul parallèle sur différents appareils. Outre les GPUs, il est possible de l'utiliser pour les CPUs et les FPGAs.

Qu'est-ce que cuDNN ?

La bibliothèque de réseau de neurones cuDNN est optimisée pour le GPU et peut tirer pleinement profit des cartes graphiques Nvidia. Elle se compose d'une implémentation de convolution, de propagation avant et arrière, de fonctions d'activation, et de pooling.

Sans cette bibliothèque, il est impossible d'utiliser les GPU pour entraîner les réseaux de neurones. Il s'agit donc d'un outil indispensable.

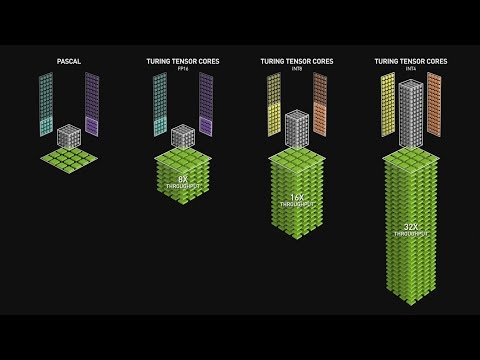

La révolution des coeurs Tensor

En 2018, Nvidia a lancé une nouvelle gamme de GPU : la série 2000, aussi appelée RTX. Ces cartes se distinguent par leurs coeurs » Tensor « , basés sur l'architecture Volta et spécialement dédiés au Deep Learning.

Les coeurs Tensor sont capables d'effectuer des multiplications de matrices FP16 4×4 et des additions de matrices FP16 ou FP32 4×4 en semi-précision. Le résultat sera une matrice FP16 ou FP32 4×4 à précision complète.

Cette nouvelle génération de coeurs Tensor basés sur l'architecture Volta est beaucoup plus rapide que les coeurs CUDA basés sur l'architecture Pascal. C'est un réel avantage pour le Deep Learning.

Plus récemment encore, Nvidia a annoncé la nouvelle série 3000 de GPU basés sur l'architecture Ampere. Cette nouvelle architecture multiplie les performances des coeurs tensor par deux. En outre, le nouveau TF32 fonctionne comme le FP32 mais multiplie la vitesse par 20. En conséquence, le temps d'entraînement des modèles Deep Learning est réduit à seulement quelques heures au lieu de plusieurs semaines.

Nvidia vs AMD

Dans l'industrie des cartes graphiques, Nvidia et AMD sont les deux leaders. Mais lequel choisir pour la Data Science et le Deep Learning ?

Les GPU AMD sont excellents pour le jeu vidéo. Toutefois, Nvidia domine largement en ce qui concerne le Deep Learning. Le logiciel et les pilotes sont optimisés à cet effet, et des mises à jour fréquentes sont déployées.

De plus, CUDA et cuDNN permettent d'accélérer encore les calculs. Des bibliothèques populaires comme Tensorflow et PyTorch sont compatibles avec CUDA, ce qui signifie que des GPUs d'entrée de gamme peuvent être utilisés. Au contraire, peu de logiciels sont compatibles avec les GPUs AMD.

Enfin, en termes de hardware, Nvidia a créé les coeurs Tensor spécialement pour le Deep Learning. De son côté, AMD a créé ROCm pour l'accélération, mais ne peut rivaliser. De nombreuses bibliothèques ne sont d'ailleurs pas compatible ROCm. Pour toutes ces raisons, Nvidia est la référence dans le domaine du Deep Learning sur GPU.

Les GPUs sur le Cloud

Les GPUs offrent de nombreux avantages pour la Data Science, le Machine Learning et le Deep Learning. Toutefois, leur prix est élevé et peut s'avérer dissuasif.

Heureusement, de nombreux fournisseurs de Cloud proposent des » GPU en tant que service « . Ceci permet d'utiliser et d'exploiter les performances des cartes graphiques directement via le Cloud.

Plusieurs fournisseurs ont noué des partenariats avec Nvidia pour délivrer la puissance de ses GPU via leurs infrastructures en nuage. On peut notamment citer Google Cloud, AWS, Microsoft Azure, IBM, Oracle, le chinois Alibaba ou encore le Français OVHCloud.

L'avantage des GPU » as-a-service » est que la facturation est flexible et proportionnelle aux ressources utilisées. Les machines peuvent aussi être personnalisées en fonction des besoins.

Au fil des années à venir, le marché des GPU va continuer à évoluer. De nouvelles innovations vont impacter le Deep Learning, le Machine Learning ou encore le HPC. On peut aussi espérer que les prix baissent, pour que davantage de développeurs et de Data Scientists puissent profiter des possibilités offertes…

- Partager l'article :