Autrefois spécialisé dans les cartes graphiques dédiées au gaming, NVIDIA est devenu, en quelques années, un géant du Big Data et un acteur majeur de l'industrie des Data Centers. Découvrez les coulisses de cette transformation, et les différentes solutions proposées aujourd'hui par la firme américaine…

Lorsqu'une entreprise s'attaque à un nouveau marché, la transition peut se solder par un échec cuisant. Toutefois, elle peut aussi être couronnée de succès.

En décidant de s'attaquer au marché des Data Centers, du Big Data et de l'IA, NVIDIA a réalisé un véritable coup de maître lui permettant de se préparer au monde de demain. À travers de dossier, découvrez comment le fabricant de cartes graphiques est devenu un géant de l'industrie du Big Data…

NVIDIA et le HPC

Tout commence en 2006. C'est à cette époque que l'Université de Stanford découvre que l'utilisation des GPUs (Graphics Processing Units) pour les tâches les plus intensives offre de meilleures performances par watt que les processeurs CPU traditionnels.

En effet, les éléments utilisés pour traiter les pixels peuvent être utilisés pour les calculs scientifiques : c'est ce que l'on appelle alors le » GPU Compute « . Plusieurs responsables de NVIDIA, dont Bill Dally et John Nicholls, décident de saisir cette opportunité pour se lancer sur le marché du » High-Performance Compute » (HPC).

Pour y parvenir, NVIDIA ajoute de nouvelles fonctionnalités dédiées aux workloads HPC dans ses GPU. Elle développe aussi la gamme de produits Tesla (plus tard renommée Ampere), en se basant sur sa gamme de workstations professionnelles Quadro.

Cette percée sur le marché du HPC sera un véritable succès, et équipe aujourd'hui 127 superordinateurs du TOP500 dont les deux superordinateurs les plus rapides du monde appartenant au US Department of Energy : Summit, situé au Oak Ridge National Laboratory, et Sierra, au Lawrence Livermore National Lab.

Par la suite, des chercheurs en intelligence artificielle décidèrent d'utiliser les GPU pour accélérer les algorithmes de Machine Learning de type » Deep Convolutional Neural Networks » (réseaux de neurones convolutifs).

En combinant les DCNN et les GPU, l'entraînement de l'intelligence artificielle a fortement gagné en vitesse et en précision. C'est ce qui a mené à l'explosion de la recherche et des applications IA, et propulsé NVIDIA en chef de file.

La firme américaine a rapidement adapté ses GPU à ces nouveaux workloads, en ajoutant des fonctions mathématiques et des éléments de traitement dédiés appelés » Tensor Cores « . Elle a aussi développé des bibliothèques logicielles sous le nom cuDNN optimisées pour son framework de programmation CUDA et pour les réseaux de neurones.

Nvidia et les Data Centers

En mars 2019, NVIDIA annonce l'acquisition de Melannox, l'entreprise de networking de Data Center, pour la somme de 6,9 milliards de dollars. Une annonce surprenante pour de nombreux experts, mais aussi et surtout une excellente décision stratégique.

Cet achat est le plus important réalisé par NVIDIA depuis sa fondation, aussi bien en termes de prix que de conséquences. En acquérant Mellanox, NVIDIA est officiellement devenue une entreprise de Data Center.

L'entreprise est convaincue que les Data Centers seront de plus en plus indispensables pour traiter les exabytes de données générées par les nouvelles technologies telles que les véhicules autonomes.

Pour répondre à ces besoins en science des données, NVIDIA a développé plusieurs projets de serveurs basés sur le networking en rack de Mellanox. En effet, la technologie de Mellanox permet de rendre un Data Center suffisamment flexible pour faire face à l'évolution des workloads, à l'hyperscaling et à la conteneurisation.

L'une des pièces maîtresses de cette technologie est l'utilisation des accélérateurs plutôt que des CPU pour les tâches de networking. A l'avenir, la firme comte aussi ajouter de l'intelligence artificielle à ses produits de switching pour transférer les données plus efficacement.

Au deuxième trimestre 2020, pour la première fois, les revenus liés aux activités Data Center de Nvidia ont surpassé ceux générés par ses produits » gaming « . Il s'agit donc d'un véritable tournant pour l'entreprise.

Les GPU Ampere

Au fil du temps, NVIDIA a développé de nombreux produits dédiés au Big Data et aux Data Centers. Tout d'abord, la firme propose des GPU spécialement dédiés aux Data Centers. Cette gamme portait jadis le nom de » Tesla « , mais a récemment été rebaptisée » Ampere » pour éviter la confusion avec la marque automobile éponyme d'Elon Musk.

Le petit dernier de ce catalogue n'est autre que le A100 Tensor Core. Ce GPU délivre des capacités d'accélération inégalables pour les workflows d'analyse de données, de HPC et d'IA. Il permet d'interconnecter des milliers de GPU ou au contraire de partitionner un GPU en sept instances avec la technologie MIG.

Les systèmes DGX

Lors du keynote GTC 2019, le CEO et fondateur de NVIDIA, Jensen Huang, estime que la Data Science est devenue le 4ème pilier de la méthode scientifique. Or, face à la pénurie de Data Scientists et de chercheurs en IA à l'échelle mondiale, il considère essentiel de maximiser la productivité de ces experts.

Pour permettre à davantage de développeurs de profiter de ses ressources de Data Science, NVIDIA conçoit les workstations et serveurs DGX embarquant tous les outils et bibliothèques CUDA-X pour la recherche en Machine Learning. Avec l'aide de plusieurs fabricants comme Dell, HP et Lenovo, elle commercialise de nouvelles plateformes de Data Science.

Avec ses systèmes DGX, NVIDIA propose aux entreprises des solutions pour la configuration et la mise à niveau des infrastructures d'intelligence artificielle et de Deep Learning.

Cette gamme de systèmes est entièrement conçue pour les workflows d'intelligence artificielle. Elle regroupe les stations de travail et serveurs NVIDIA DGX, mais aussi la solution d'infrastructure évolutive DGX POD.

La plateforme de calcul accéléré NVIDIA HGX A100

Avec sa plateforme HGX A100, NVIDIA propose la plateforme de serveur la plus performante du monde pour l'accélération des calculs multi-précision sur les workflows Deep Learning, Machine Learning et HPC.

Cette plateforme combine jusqu'à huit GPU A100 Tensor Core à la technologie NVSwitch dans un accélérateur unifié. De quoi résoudre les calculs les plus complexes et avancés.

NVIDIA EGX pour le calcul en Edge Computing

Alors que les entreprises opèrent de plus en plus à la périphérie des réseaux, NVIDIA répond à une nouvelle demande avec sa plateforme NVIDIA EGX. Celle-ci permet de profiter de la puissance de calcul accéléré par l'IA directement en périphérie (edge) via le Cloud.

Cette plateforme de calcul accélérée par GPU dédiée au déploiement et à la gestion des applications IA est entièrement évolutive. Elle offre par ailleurs une faible latence et une utilisation simplifiée à l'extrême.

Le hub logiciel NGC

Le hub NGC regroupe de nombreux logiciels accélérés par GPU pour le Deep Learning, le Machine Learning et le calcul haute performance. Les workflows professionnels s'en trouvent simplifiés, et les Data Scientists peuvent ainsi se focaliser sur la création de solutions innovantes.

On retrouve des graphiques Helm permettant d'automatiser les déploiements, des conteneurs sur mesure pour déployer plus rapidement les frameworks IA, des modèles pré-entraînés et des scripts d'apprentissage.

NVIDIA accélère Apache Spark 3.0

En mai 2020, NVIDIA a fait le choix de collaborer avec la communauté open-source en apportant son accélération GPU à Apache Spark 3.0 : la nouvelle version du moteur d'analyse Big Data utilisé par plus de 500 000 Data Scientists dans le monde.

Cette accélération GPU concerne l'ensemble du pipeline de Spark 3.0, du processus ETL jusqu'à l'entraînement de l'IA, qui peut désormais être traité sur le même cluster Spark plutôt que sur une infrastructure séparée. En utilisant la version preview de Spark 3.0 sur Databricks, Adobe a multiplié ses performances par 7 et réduit ses coûts de 90%.

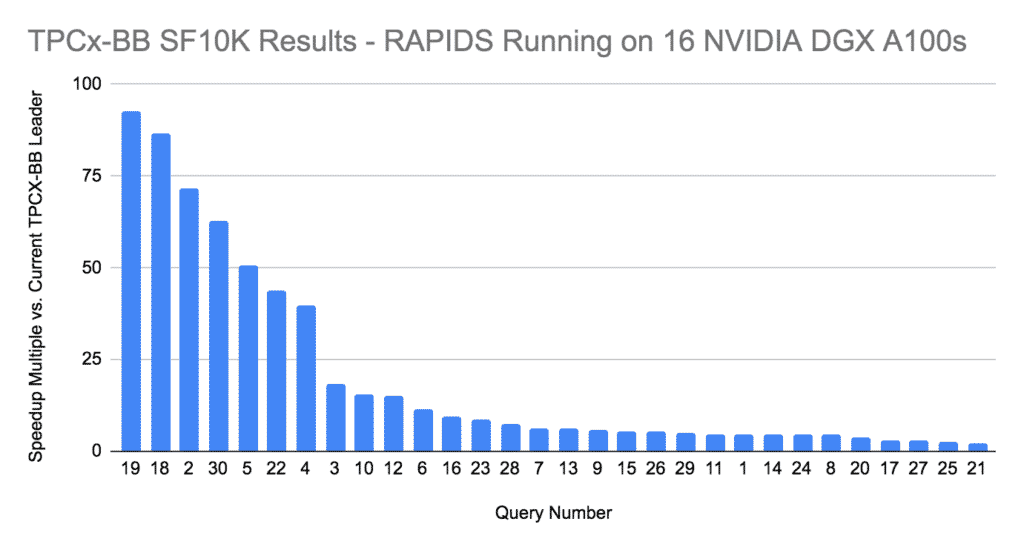

NVIDIA bat le record de performances d'analyse Big Data

En juin 2020, NVIDIA a battu le record de vitesse d'analyse Big Data sur le benchmark standard TPCx-BB. Plus précisément, la firme a réalisé des performances 20 fois plus élevées que les précédents records.

Cette prouesse a été réalisée grâce à la suite de bibliothèques logicielles de Data Science open-source RAPIDS, propulsées par 16 systèmes DGX A100. Au total, les systèmes cumulaient 128 GPU A100 et utilisaient la technologie de networking de Mellanox. Le benchmark a été exécuté en seulement 14,5 minutes grâce à cette configuration, tandis que le précédent record était de 4,7 heures sur un système CPU.

NVIDIA, le Deep Learning et l'intelligence artificielle

L'intelligence artificielle et le Deep Learning permettent aux ordinateurs d'apprendre de manière autonome. Ces technologies nécessitent une puissance de calcul colossale pour l'entraînement des modèles et l'inférence.

Plutôt que les CPU, on utilise les GPU équipés de coeurs Tensor pour leur capacité de parallélisme. Chaque coeur peut effectuer une tâche différente en simultané.

Naturellement, NVIDIA est donc devenu un acteur majeur du Deep Learning au même titre que AMD. Leurs GPU sont utilisés par tous les ingénieurs en intelligence artificielle.

NVIDIA propose l'accélération GPU pour le Deep Learning aussi bien sur PC que via le Cloud. Les systèmes DGX pour Data Centers sont les premiers superordinateurs conçus pour l'IA.

Sur le Cloud, l'accélération GPU est proposée sous forme de services par les principaux fournisseurs comme Amazon, Google, IBM et Microsoft. En outre, le hub NGC permet l'accès aux principaux frameworks Deep Learning pour l'entraînement de modèles : TensorFlow, PyTorch, MXNET…

Pour le Deep Learning sur PC, NVIDIA commercialise son GPU TITAN-V qui est actuellement la carte graphique pour PC la plus puissante à ce jour. Elle repose sur l'architecture Volta de dernière génération.

Un autre produit Nvida dédié au Deep Learning est le DRIVE PX2 : un ordinateur de bord pour les voitures autonomes. Ce système permet d'accélérer la production de véhicules sans pilote.

Le NVIDIA Jetson est une carte permettant d'intégrer l'IA et le Deep Learning aux appareils intelligents. Elle offre des capacités de vision par ordinateur (Computer Vision), de hautes performances avec l'architecture Maxwell (1 Teraflops) et une faible consommation d'énergie de moins de 10 watts.

Côté software, NVIDIA propose le stack logiciel CUDA-X AI entièrement dédié au Deep Learning et destiné aussi bien aux chercheurs qu'aux développeurs. Cet outil permet de développer des applications haute performance accélérées par GPU pour les assistants vocaux, les systèmes de recommandation ou la vision par ordinateur. Les différentes bibliothèques délivrent des performances inégalées pour l'entraînement et l'inférence.

Nvidia GTC 2021 : tour d'horizon des annonces Data Centers

L'édition 2021 de la GPU Technology Conference annuelle de Nvidia était particulièrement riche, avec plusieurs dizaines d'annonces. Plusieurs nouveautés majeures ont notamment été annoncées pour les Data Centers.

Lors de la précédente édition, Nvidia avait dévoilé son nouveau GPU phare : le Ampere A100. Cette puce surpuissante est idéale pour les superordinateurs, le HPC ou l'IA à grande échelle… mais peut être à la fois trop performante et trop chère pour des projets de moindre envergure.

Afin de rectifier le tir, l'entreprise vient de dévoiler deux nouvelles puces plus modestes basées sur le A100. Le Ampere A30 est destiné aux serveurs IA et analytiques, et le A10 est conçu pour le mixed compute et les workloads graphiques.

Une autre nouveauté annoncée par Nvidia est la possibilité de » louer » le superordinateur Nvidia DGX Station A100 pour une courte période de temps. Il s'agit du programme » Nvidia Financial Solutions « , destiné aux individus et entreprises dont les besoins ponctuels ne justifient pas l'achat d'une machine à plusieurs millions de dollars.

En guise d'alternative, via le Cloud, il sera possible d'accéder à un DGX SuperPod constitué de plusieurs ordinateurs DGX Station. C'est donc un superordinateur » cloud-native « , proposé sous la forme d'un serveur dédié bare-metal.

Loin de se reposer sur ses lauriers, Nvidia a aussi dévoilé son ambitieuse feuille de route pour les prochaines puces. D'ici 2025, la firme compte lancer six générations de hardware dans les gammes Ampere, Grace et Bluefield. La prochaine génération de GPU, prévue pour 2022, porte le nom de code Hopper.

Le CPU Grace est quant à lui prévu pour 2023, tandis que son successeur Grace Next sera lancé en 2025. Concernant les puces de Data Processing de gamme Bluefield, les prochaines itérations (3 et 4) sont attendues pour 2022 et 2024 avec des performances multipliées par 10 et 100 par rapport à l ‘actuelle mouture.

Comment Nvidia projette-t-il de dominer le marché des puces pour data center avec l'IA ?

Nvidia, l'entreprise aux trois puces, tente de se tailler une place sur le marché des centres de données et d'en prendre le contrôle. Pour ce faire, elle prévoit de faire fonctionner les data centers 10 fois plus vite et à un coût 10 fois inférieur.

Nvidia élabore une stratégie visant à rénover :

- les centres de données sur site,

- les clouds publics

- et les installations de calcul en périphérie.

Elle s'appuie sur la forte position de l'entreprise dans les architectures d'intelligence artificielle. Les clés de cette stratégie de bout en bout comprennent une vision claire, des compétences massives en conception de puces. Elles incluent de nouvelles architectures basées sur Arm. Ces dernières intègrent la mémoire, les processeurs, les E/S et la mise en réseau, et un modèle de consommation logicielle convaincant.

En outre, NVIDIA a élargi sa gamme de processeurs. Elle a également fait l'acquisition de Mellanox, une entreprise spécialisée dans le développement de systèmes de mise en réseau performants. Depuis ce rachat, NVIDIA a conçu une DPU Bluefield-3 unité de traitement des données rendant sa plateforme informatique puissante.

NVIDIA a dévoilé une troisième puce : le processeur Grace. Il exploite un cœur ARM à faible consommation d'énergie offrant une vitesse dix fois plus élevée que celle des serveurs les plus puissants.

- Partager l'article :