Stability AI vient de reprendre sa ceinture de champion des générateurs d’images IA ! La startup lance Stable Diffusion 3 en accès anticipé, et cette nouvelle version surpasse tous ses rivaux grâce à une nouvelle approche similaire à OpenAI Sora… découvrez la comparaison avec MidJourney, DALL-E 3 ou encore Google ImageFX !

A l’heure où Google se ridiculise avec son IA raciste anti-blanc, Stability AI vient de prendre l’industrie de vitesse avec Stable Diffusion 3 (SD3).

Quelques jours après son tout nouveau modèle Stable Cascade, la startup annonce la preview de la troisième version de son célèbre générateur d’images Stable Diffusion.

Selon ses propres dires, il s’agit du « modèle text-to-image le plus capable » jusqu’à présent. C’est la première mise à jour majeure de Stable Diffusion, après SXDL Turbo en novembre 2023.

Même si Stability régnait déjà en maître sur le royaume de l’IA open source, elle vient de franchir un nouveau cap. Désormais, elle peut même se vanter de surpasser les outils fermés les plus avancés comme DALL-E 3 et MidJourney V6.

Le meilleur générateur d’images pour l’intégration de texte ?

Les principales améliorations sont une meilleure génération de texte, une forte adhérence aux prompts, et une résistance au « prompt leaking ». En d’autres termes, les images générées correspondront davantage à la requête.

En outre, SD3 prend en charge les inputs multimodaux. Il sera donc possible d’entrer des images ou même de l’audio en guise de prompts, mais cette nouveauté sera dévoilée lors d’un futur rapport technique.

Les premiers testeurs sont très enthousiastes. Selon MattVidPro, YouTuber spécialisé dans l’IA, « ce générateur d’image IA est le meilleur que nous ayons vu en termes de compréhension des prompts et de génération de texte ».

Il affirme qu’il est « plusieurs bonds au dessus du reste, et réellement époustouflant ». De même, l’ingénieur en machine learning Ralph Brooks confirme que ses capacités de génération de texte sont « incroyables ».

SD3 vs MidJourney : qui peut prétendre à la couronne ?

Pour le moment, seule une poignée de partenaires triés sur le volet peuvent essayer Stable DIffusion 3. Néanmoins, Stability AI et les testeurs partagent déjà des comparaisons entre les images qu’elle produit et les résultats de MidJourney, DALL-E 3 et SDXL sur des prompts similaires.

Il semble clair que SD 3 surpasse tous ses concurrents en termes de qualité globale. Voyez par vous-même, en commençant par MidJourney.

Voici une comparaison sur le prompt : « Illustration d’anime épique représentant un sorcier au sommet d’une montagne la nuit jetant un sort cosmique dans le ciel sombre qui dit ‘ Stable Diffusion ’ composé d’énergie colorée »

Lors de ce test, SD3 a suivi le prompt à la lettre tandis que MidJourney n’a pas généré le texte, n’a pas dépeint la montagne, et n’a même pas laissé le sorcier jeter son sort cosmique.

SD3 vs ImageFX : l’IA de Google à nouveau humiliée

Alors que Google a mis son IA en pause après qu’elle ait généré des nazis noirs, les internautes ont eu le temps de la comparer avec SD3. Malheureusement pour Big G, ImageFX est de nouveau humiliée.

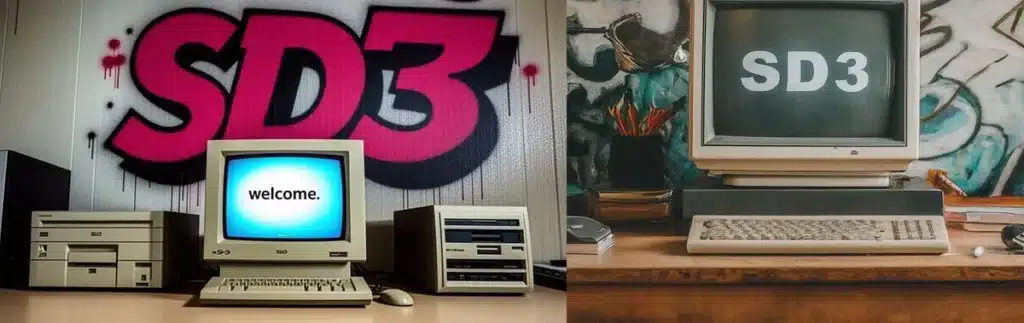

Voici une comparaison sur le prompt : « Photo d’un PC des années 90 sur un bureau. Sur l’écran de l’ordinateur, il est écrit ‘bienvenue.’. Sur le mur en arrière-plan, nous voyons de beaux graffitis avec le texte ‘SD3’ en très grand format sur le mur ».

Là encore, SD3 étonne par sa fidélité remarquable au prompt. De son côté, le générateur d’image intégré à Google Gemini commet un Prompt Leaking, génère le texte au mauvais endroit, ne respecte pas le style graffiti demandé et oublie d’écrire le mot « bienvenue ».

Qui plus est, l’esthétique générée par SD3 ressemble davantage à une photographie qu’à un rendu photoréaliste. Les effets visuels semblent aussi se fondre dans l’arrière-plan.

SD3 vs DALL-E 3 : OpenAI prend une leçon d’humilité

Même si OpenAI a popularisé l’IA générative avec ChatGPT, et vient encore de choquer tout le monde avec le générateur de vidéos Sora, SD3 semble également surpasser son générateur d’images DALL-E 3.

Observez cette comparaison sur le prompt : « Une peinture représentant un astronaute chevauchant un cochon portant un tutu tenant un parapluie rose, sur le sol à côté du cochon se trouve un rouge-gorge portant un haut-de-forme, dans le coin se trouvent les mots ‘Stable Diffusion’ ».

Là encore, on constate que Stable Diffusion a généré exactement ce qui était demandé dans le prompt tandis que DALL-E 3 a échoué à générer du texte, a créé un rendu 3D au lieu d’une peinture, et a généré un arrière-plan de galaxie sous prétexte que le prompt évoquait un astronaute.

SD3 vs SDXL : un héritier digne de ce nom ?

Pour terminer, comparons SD3 avec son prédécesseur SDXL. Voici comment les résultats produits par les 2 IA sur le prompt « sur la table de la cuisine se trouve un tissu brodé avec le texte ‘bonne nuit’ et un bébé tigre brodé. À côté du tissu se trouve une bougie allumée. L’éclairage est faible et dramatique ».

Les deux modèles ont su capturer l’essence du prompt, mais SDXL a échoué à générer le texte et a subi un prompt leaking. Il a généré deux tissus, et l’un s’est transformé en quelque chose d’autre. De plus, le tigre brodé est mieux représenté par SD3.

Nous avons donc un nouveau champion si l’on se fie à ces premiers tests ! Il faudra toutefois attendre de pouvoir tester l’IA pour en avoir le cœur net… à présent, voyons ce que cache cette amélioration d’un point de vue technique !

Qu’est-ce qui se cache sous le capot de SD3 ?

Selon Emad Mostaque, CEO de Stability AI, SD3 utilise un nouveau type de transformer par diffusion similaire à OpenAI Sora, combiné avec l’association de flux et d’autres améliorations.

Le « Flow Matching » est une technique IA pour la modélisation générative, basée sur un entraînement et une inférence plus rapide et stable que les méthodes alternatives telles que les GANs.

L’IA apprendre à générer des images en apprenannt comment effectuer une transition fluide du bruit aléatoire vers une image structurée. Nul besoin de simuler toutes les étapes du processus, puisqu’il suffit de se focaliser sur la direction générale, le flux que la création d’image doit suivre.

Ce sont ces nouvelles techniques qui permettent d’accroître l’habilité du modèle à accepter les inputs multimodaux, tout en pavant la voie pour son application dans la génération de vidéos et d’environnements 3D.

Les différents modèles de la famille vont de 800 millions à 8 milliards de paramètres. Ceci permet d’exécuter SD 3 localement sur divers appareils, allant du smartphone au serveur.

Le nombre de paramètres améliore la quantité de détails, mais les modèles plus larges requiert davantage de VRAM sur les accélérateurs GPU.

Le CEO précise aussi que sa vision pour SD3 inclus tout un écosystème d’outils conçu pour tirer parti des dernières avancées hardware tout en restant accessible et adaptable à divers domaines créatifs.

Comment tester Stable Diffusion 3 ?

Pour le moment, SD3 n’est malheureusement pas disponible pour le grand public. Néanmoins, Stability AI promet que ce nouveau modèle sera gratuit, open source, et disponible sous licence non-commerciale.

Si vous souhaitez l’essayer dès à présent et sans attendre, vous pouvez néanmoins déposer votre candidature pour un accès anticipé en devenant membre du programme de Stability AI en suivant ce lien !

- Partager l'article :