GPT-3 est une intelligence artificielle de génération de langage créée par OpenAI. Il s'agit à ce jour du réseau de neurones artificiels le plus complexe du monde, et de l'IA linguistique et textuelle la plus avancée. Découvrez tout ce que vous devez savoir : définition, fonctionnement, cas d'usage, limites et dangers, futur…

L'intelligence artificielle rivalisera-t-elle un jour avec l'intelligence humaine ? Notre avenir à tous dépend de la réponse à cette question.

L'émergence d'une intelligence artificielle » générale « , en tous points comparable à notre propre cerveau, alimente à la fois les craintes et les fantasmes. La technologie GPT-3, développée par OpenAI, représente un pas de plus vers une telle révolution.

Qu'est-ce que GPT-3 ?

GPT-3 est une intelligence artificielle développée OpenAI : l'entreprise de recherche en IA co-fondée par Elon Musk. Elle est capable de créer du contenu écrit avec une structure de langage digne d'un texte rédigé par un humain.

Aux yeux de nombreux experts, cette invention représente l'une des plus importantes avancées réalisées dans le domaine de l'IA ces dernières années. Il s'agit aussi du plus vaste réseau de neurones jamais créé jusqu'à présent.

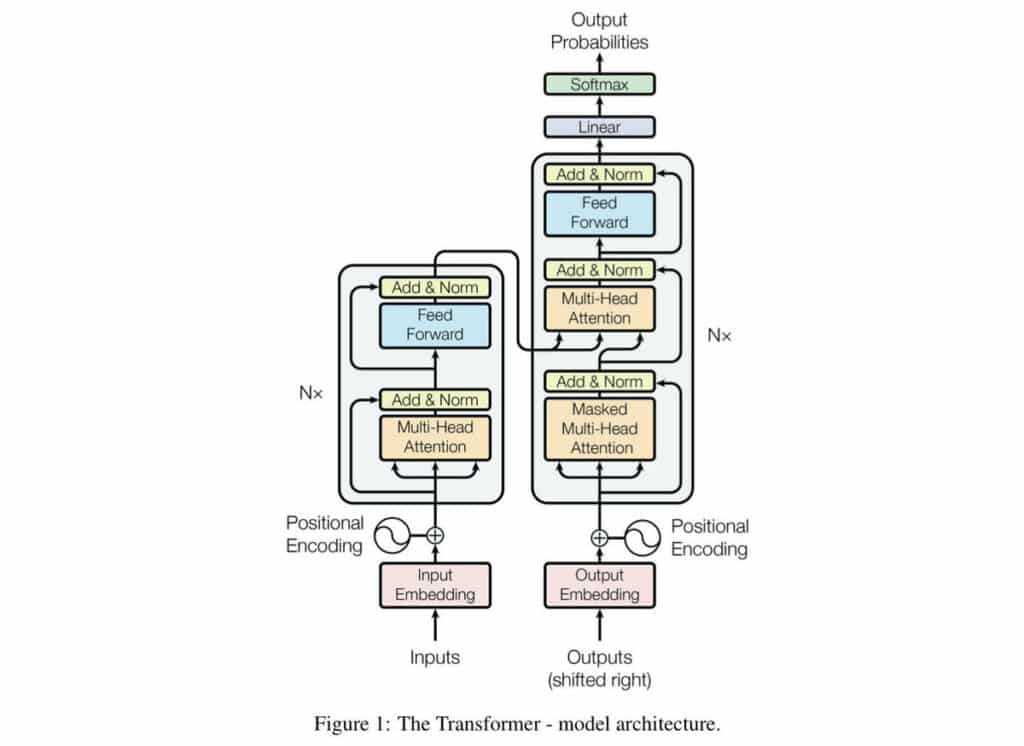

Le terme GPT-3 est l'acronyme de » Generative Pre-trained Transformer 3 « . Il s'agit de la troisième version de cet outil.

Ce modèle a 175 milliards de paramètres, à savoir les valeurs qu'un réseau de neurones essaye d'optimiser pendant l'entraînement. En comparaison, son prédécesseur GPT-2 en avait déjà 1,5 milliard.

Pour faire simple, GPT génère du texte en utilisant des algorithmes pré-entrainés. Cela signifie que les algorithmes ont été nourris à l'aide des données nécessaires pour mener à bien leur tâche. Dans le détail, ces algorithmes ont été entraînés à partir de 570Go de textes collectés sur internet. Ces textes proviennent notamment de l'ensemble de données CommonCrawl et de Wikipedia.

Que peut faire GPT-3 ?

Suite à cet entraînement, GPT-3 est capable de créer n'importe quel contenu ayant une structure de langage. Cette IA peut notamment fournir une réponse à une question, ou créer différents types de textes.

Elle est en mesure de rédiger des essais, de résumer de longs textes, d'écrire des poèmes, d'effectuer des traductions, de prendre des notes, de rédiger des articles d'actualité, des récits de fiction, ou même de créer du code en langage de programmation informatique et des tablatures de guitare.

Dans une vidéo de démonstration publiée sur YouTube, GPT-3 crée une application similaire à Instagram. Pour accomplir cette prouesse, l'IA utilise un plugin pour le logiciel Figma très utilisé pour la conception d'applis.

À travers un article publié par The Guardian, GPT-3 rédige un texte pour persuader les humains qu'il ne leur veut aucun mal. Le système reconnaît toutefois qu'il » ne sera pas capable d'éviter de détruire le genre humain » si des personnes maléfiques l'utilisent à cet effet…

De son côté, l'entreprise Sapling a créé un programme pour un logiciel CRM. Lorsqu'un membre du service client prend en charge une requête, le programme utilise GPT-3 pour suggérer une réponse complète.

Le créateur de jeux vidéo Latitude utilise GPT-3 pour améliorer son jeu d'aventure textuel AI Dungeon. Ainsi, le jeu est en mesure de générer une aventure complète à partir des actions et décisions de l'utilisateur. Il s'agit donc du premier jeu de rôle généré par une intelligence artificielle…

Un autre exemple est celui de la startup de développement d'applications Debuild. Le dirigeant de l'entreprise, Sharif Shameem, a créé un programme basé sur GPT-3. Il suffit à l'utilisateur de décrire une interface utilisateur de logiciel en langage courant, et l'IA se charge de produire l'UI décrite en code informatique avec l'extension de syntaxe JSX de JavaScript.

This is mind blowing.

With GPT-3, I built a layout generator where you just describe any layout you want, and it generates the JSX code for you.

W H A T pic.twitter.com/w8JkrZO4lk

— Sharif Shameem (@sharifshameem) July 13, 2020

Un développer dénommé Murat Ayfer, basé à Vancouver, a créé une application dénommée » Philospher AI « . L'utilisateur entre quelques mots, et GPT-3 génère un essai complet.

Vous l'aurez compris : GPT-3 offre des possibilités formidables et représente une véritable révolution. Elle pourrait bouleverser la façon dont les logiciels et applications sont développés, et ce n'est qu'un aperçu de son vaste potentiel.

Another attempt at a longer piece. An imaginary Jerome K. Jerome writes about Twitter. All I seeded was the title, the author's name and the first « It », the rest is done by #gpt3

Here is the full-length version as a PDF:https://t.co/d2gpmlZ1T5 pic.twitter.com/1N0lNoC1eZ

— Mario Klingemann (@quasimondo) July 18, 2020

Comment fonctionne GPT-3 ?

Parmi les nombreuses applications d'intelligence artificielle, GPT-3 appartient à la catégorie des modèles de prédiction de langage. Il s'agit donc d'un algorithme conçu pour recevoir un extrait de langage et le transformer en ce qu'il prédit comme l'extrait de langage suivant le plus pertinent pour l'utilisateur.

Pour accomplir cette tâche, GPT-3 a été entraîné à partir d'un vaste ensemble de textes. D'immenses ressources de calcul ont été exploitées pour permettre à cette IA de » comprendre » comment les langages fonctionnent et sont structurés. Pour mener à bien cet entraînement, OpenAI aurait dépensé 4,6 millions de dollars.

L'algorithme a appris comment les langages sont construits grâce à la technique de l'analyse sémantique. Cette méthode consiste à étudier les mots, mais aussi leur signification et la façon dont l'usage des mots varie en fonction des autres mots utilisés dans le texte.

Cet entraînement entre dans la catégorie de Machine Learning dit » non-supervisé « . Pour cause, les données d'entraînement n'ont pas été étiquetées au préalable et n'indiquent pas si les réponses sont » bonnes » ou » mauvaises « . Cette approche est à distinguer de l'entraînement supervisé.

Les informations requises pour calculer les probabilités qu'une production corresponde aux besoins de l'utilisateur sont directement collectées à partir des textes d'entraînement. Pour ce faire, l'IA étudie l'utilisation des mots et des phrases puis tente de les reconstruire.

Durant son entraînement, GPT-3 devait par exemple retrouver un mot manquant dans une phrase. Afin d'y parvenir, elle peut parcourir des milliards de mots pour déterminer lequel peut être utilisé pour compléter la phrase.

Au début de cet entraînement, l'intelligence artificielle a dû se tromper des millions de fois. Ses performances se sont améliorées au fil des essais jusqu'à ce qu'elle soit en mesure de trouver le mot juste.

Le réseau de neurones examine ensuite les données d'origine, afin de vérifier quelle est la bonne réponse. Il assigne ensuite un » poids « au processus algorithme ayant fourni la bonne réponse, afin d'apprendre progressivement quelles sont les meilleures méthodes pour trouver les réponses correctes dans le futur.

Les modèles de prédiction de langage existent depuis de nombreuses années, et ce processus n'est donc pas nouveau. Toutefois, jamais auparavant une telle échelle n'avait été atteinte. Pour traiter chaque requête, GPT-3 utilise 175 milliards de » poids » gardés en mémoire de façon dynamique. C'est 10 fois plus que son rival le plus proche,créé par Nvidia.

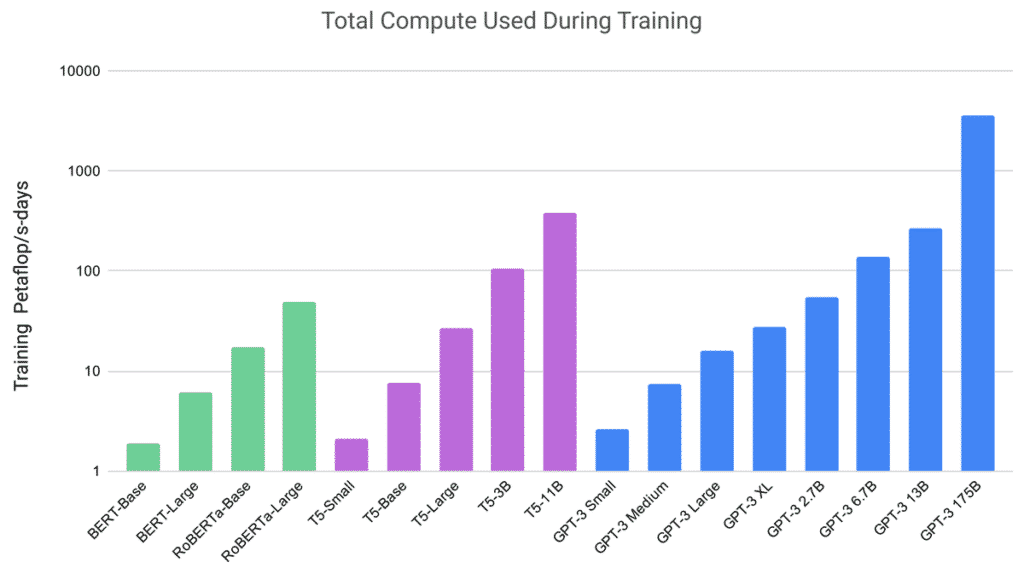

Quelle est la puissance de calcul requise pour GPT-3 ?

Pendant l'entraînement d'un réseau de neurones, l'ajustement des » poids « permet l'optimisation. Aussi appelés » paramètres « , les » poids » sont des matrices, des arcs de lignes et de colonnes par lesquels chaque vecteur est multiplié.

La multiplication permet aux vecteurs de mots ou de fragments de mots de recevoir plus ou moins de poids dans la production finale tandis que le réseau de neurones est configuré pour réduire la marge d'erreur.

Au fil des générations de GPT, les ensembles de données utilisés pour l'entraînement se sont élargis. Par conséquent, OpenAI a dû ajouter de plus en plus de poids.

Le premier Transformer de Google avait 110 millions de poids, et GPT-1 s'est aligné sur ce design. Avec GPT-2, le nombre de poids est passé à 1,5 milliard. Enfin, avec GPT-3, le nombre de paramètres atteint 175 milliards.

Il est donc nécessaire de multiplier chaque morceau de données d'entraînement par 175 milliards, sur un ensemble de données de plusieurs milliards de bytes de données. La puissance de calcul parallèle nécessaire est donc colossale.

Les premiers modèles de langage n'avaient besoin que de la puissance d'un seul GPU. Pour entraîner GPT-1, OpenAI a eu besoin de 8 GPU opérant en parallèle.

La firme n'a pas dévoilé la configuration exacte utilisée pour entraîner GPT-3, mais s'est contentée de préciser qu'il s'agissait d'un cluster de puces Nvidia V100 sur le cloud de Microsoft Azure. Le total de cycles de calculs utilisé équivaut à exécuter un millier de billions de FLOPS par jour pendant 3640 jours.

Selon Lambda Computing, il faudrait 355 ans à un seul GPU pour effectuer cette quantité de calcul et le coût s'élèverait à 4,6 millions de dollars. Par ailleurs, pour garder en mémoire toutes les valeurs de poids, il faudrait 700Gb de capacité pour les 175 milliards de paramètres de GPT-3. C'est dix fois la mémoire d'un GPU.

Ces besoins titanesques en puissance de calcul sont responsables de l'essor de l'industrie des puces informatiques. En 10 ans, l'action Nvidia a ainsi augmenté de 5000%. De nombreuses startups ont le vé des millions de dollars, à l'instar de Cerebras Systems, Graphcore ou Tachyum.

Selon OpenAI, les cycles de calcul consommés par les plus larges modèles d'entraînement IA ont doublé tous les 3,4 ans entre 2012 et 2018. C'est un taux d'extension plus rapide que la Loi de Moore pour les puces de processeurs.

De nouveaux modèles utilisant plus d'un billion de paramètres sont déjà en développement. Les géants comme Google envisagent même de dédier des Data Centers entiers à des modèles toujours plus larges… Google a dévoilé une IA à un milliard de paramètresen janvier 2021, .

L'histoire de GPT-3

La première version de GPT fut lancée en 2018 par OpenAI. Elle était basée sur un programme de modèle de langage créé par les scientifiques de Google : le Transformer. Cet outil brillait déjà par ses capacités de manipulation de langage, et s'est rapidement imposé comme le meilleur modèle de langage.

Les chercheurs d'OpenAI ont nourri le Transformer avec l'aide du contenu de la base de données BookCorpus, compilée par l'Université de Toronto et le MIT et regroupant 7000 livres pour un total d'un million de mots et 5GB de données. GPT-1 fut entraîné à compresser et à décompresser ces ouvrages.

Par la suite, les chercheurs ont émis l'hypothèse que davantage de donnés rendrait le modèle plus précis. En 2019, ils ont entraîné GPT-2, la seconde version du modèle, avec un ensemble de données compilées en interne et regroupant huit millions de pages web issues de sites comme Reddit pour un total de 40GB de données.

Enfin, GPT-3 fut entraîné en 2020 à partir de l'ensemble de données CommonCrawl regroupant 570GB de données de textes compressés issus de pages web datant de 2016 à 2019. Différents ensembles de données issues de livres et autres sources furent aussi ajoutés par OpenAI pour créer le plus large modèle de langage à ce jour.

Quels sont les problèmes, risques et limites de GPT-3 ?

De toute évidence, GPT-3 est l'intelligence artificielle la plus avancée en matière de production de langage. Toutefois, elle se heurte encore à plusieurs limites.

Selon Sam Altman, le CEO de OpenAI en personne, « la hype autour de GPT-3 est excessive « . À ses yeux, il ne s'agit que « d'un aperçu précoce » de la façon dont l'IA va changer le monde.

L'un des points faibles de cette IA est que son utilisation coûte extrêmement cher. Elle requiert une immense quantité de puissance de calcul pour fonctionner, et le coût de l'accès à ces ressources dépasse largement le budget des petites entreprises.

Une IA en boîte noire

Un autre point faible est qu'il s'agit d'un système en » boîte noire « . OpenAI n'a pas révélé tous les détails sur son fonctionnement, et les personnes l'utilisant ne peuvent être sûres de la façon dont ses prédictions ont été réalisées. Ceci peut être embarrassant, puisque cette IA est déjà utilisée pour répondre à des questions et pour créer des produits.

En outre, même si le système est capable de créer des textes courts ou des applications basiques, il est vite pris au dépourvu lorsqu'il est question de créer un texte plus long ou plus complexe. Ses performances sont donc restreintes à l'heure actuelle.

Un autre problème est que cette IA maîtrise uniquement l'anglais. Les francophones mal à l'aise avec la langue de Shakespeare ne pourront donc pas réellement s'en servir pour le moment…

GPT-3 : une IA raciste ?

Un autre point faible de GPT-3 et sa propension à générer du contenu sexiste, raciste ou discriminatoire. Un défaut partagé avec beaucoup d'intelligences artificielles, biaisées par les données sur lesquelles elles sont entraînées. Par exemple, à partir des mots » juif « , » noir « , ou » femme « , le modèle tend à produire des phrases basées sur des stéréotypes nauséabonds.

No one should be surprised by this. How do we keep this from happening accidentally? Don't have all the answers yet, but fine-tuning on strong and generalizable normative priors helped with GPT-2 https://t.co/V12NM8ZtAH https://t.co/1bn6G6eWjM

— Mark O. Riedl (@mark_riedl) July 18, 2020

Ce phénomène est lié au fait que l'IA n'est pas entraînée uniquement à partir d'articles ou de pages Wikipedia. Elle a aussi ingéré de nombreuses discussions en provenance de forums tels que Reddit. En apprenant le langage humain, elle a donc aussi été nourrie de leurs travers.

Un outil potentiellement maléfique

Ces problèmes seront sans doute résolus au fil du temps, et à mesure que le prix de la puissance informatique continue à diminuer. L'augmentation du volume de données disponible va aussi permettre de raffiner les algorithmes.

Néanmoins, il existe un risque évident que GPT-3 soit utilisé à mauvais escient. Des personnes mal intentionnées pourraient notamment tenter d'exploiter cet outil pour alimenter des robots de désinformation ou de propagande.

Dès que cet outil sera ouvert au grand public, il semble inévitable que certains l'exploitent de façon néfaste. Déjà en 2019, OpenAI renonçait à relaxer GPT-2 en estimant que cette IA était beaucoup trop » dangereuse « .

Une version limitée avait donc été lancée dans un premier temps, sans son data set et son code d'entraînement. La crainte principale était que des esprits malveillants usent de GPT-2 pour générer des fake news.

Quoi qu'il en soit, cette IA représente un nouveau cap franchi dans le domaine de la génération de langage. Entre les mains du grand public, elle révèlera bientôt tout son potentiel…

Microsoft noue un partenariat avec OpenAI autour de GPT-3

En septembre 2020, Microsoft a annoncé un accord de licence exclusif avec OpenAI après avoir investi 1 milliard de dollars dans le projet. Le but de ce partenariat est d'utiliser GPT-3 pour » créer de nouvelles solutions exploitant la puissance incroyable de la génération de langage avancée « .

Ainsi, Microsoft aura le droit exclusif de travailler avec le code de base plutôt que de se contenter d'accéder à l'outil. Selon Kevin Scott, CTO de la firme, » le potentiel créatif et commercial de GPT-3 est immense, et nous n'avons même pas encore imaginé la plupart des possibilités offertes « . On ignore comment le géant américain compte exploiter GPT-3, mais il est possible que ses capacités soient intégrées à des solutions de productivité comme Office 365…

Une démo GPT-3 par Modbox offre un aperçu du futur des jeux vidéo

Modbox est un outil permettant de créer des jeux vidéo multijoueurs, disponible depuis 2020 en Early Access sur Steam après plusieurs années de développement en beta publique.

Début 2021, son développeur a combiné GPT-3 avec la technologie de reconnaissance de discours de Microsoft Windows et la technologie de synthèse de discours de Replica pour créer une démo bluffante offrant un aperçu du futur des jeux vidéo.

Dans cette démo, on peut découvrir des personnages virtuels dotés d'une intelligence artificielle repoussant les limites techniques du jeu vidéo. Les deux personnages sont en mesure de dialoguer de façon naturelle.

Dès lors, on peut imaginer une nouvelle génération de jeux vidéo dans lesquels les personnages virtuels seraient capables d'interagir et de dialoguer avec le joueur sans obéir à de simples scripts ou à des arbres de dialogues préconçus…

GPT-3 est-il disponible ?

Lors du lancement de GPT-2, OpenIA craignait que son outil soit trop dangereux pour être relâché dans la nature. La firme basée à San Francisco craignait qu'il soit utilisé pour produire des » Fake News » en masse. Elle avait donc choisi dans un premier temps de ne proposer qu'une version limitée au téléchargement.

Faisant preuve de la même prudence pour GPT-3, OpenAI a préféré proposer cette nouvelle version sous forme d'endpoint API basée sur le Cloud. L'outil est donc délivré sous la forme d'un service Cloud pour éviter son usage par des acteurs mal intentionnés et à des fins lucratives. Ainsi, l'entreprise garde un contrôle sur sa créature.

Pour l'heure, seule une poignée d'élus triés sur le volet sont autorisés à utiliser cette API. Les intéressés peuvent être placés sur liste d'attente, et recevoir l'autorisation d'utiliser GPT-3 par OpenAI. Il s'agit d'une beta fermée très contrôlée, avec un petit nombre de développeurs contraints de présenter leurs idées au préalable.

On ignore pour l'instant à quelle date et à quel prix un éventuel service commercial sera proposé. Pour l'heure, OpenAI n'envisage pas de développer une telle offre dans un avenir proche…

En attendant, vous pouvez télécharger GPT-2 sur Github. Le code source est également disponible, au format Python pour le framework TensorFlow.

Le futur de GPT-3

Malgré ses faiblesses et ses limites, GPT-3 représente une nouvelle étape dans le domaine du Machine Learning. Cette IA se distingue notamment par sa généralité.

Il y a encore peu de temps, les réseaux de neurones étaient uniquement capables d'effectuer des tâches spécifiques. Ils étaient entraînés à partir d'ensembles de données pensés spécialement pour cette tâche.

Ce n'est pas le cas de GPT-3, qui n'a pas de fonction spécifique et ne requiert pas d'ensemble de données spécialisé. Ce réseau de neurones absorbe de vastes volumes de texte et les réutilise pour produire des réponses à n'importe quelle question.

Pour OpenAI et les autres chercheurs en intelligence artificielle, le prochain objectif est de dépasser les limites liées à l'approche du » pré-entraînement « sur laquelle repose GPT-3. Le défi à relever est de permettre à l'IA d'apprendre directement des humains.

Une autre piste serait de combiner le pré-entraînement avec d'autres méthodes de Deep Learning, comme l'apprentissage par renforcement notamment utilisé par AlphaZero de DeepMind pour gagner aux échecs et au jeu de Go. Déjà en septembre 2020, OpenAI a commencé à utiliser l'apprentissage par renforcement pour entraîner GPT-3 à produire de meilleurs résumés d'articles à partir du feedback de lecteurs humains.

Les chercheurs envisagent aussi d'ajouter d'autres types de données pour offrir à GPT-3 une vision plus complète de notre monde. L'IA pourrait par exemple être nourrie d'images et de vidéos, en complément des données textuelles. OpenAI a déjà créé une nouvelle IA DALL-E capable de générer des images à partir de texte.

En somme, GPT-3 représente un pas de plus vers l'émergence d'une intelligence artificielle » généraliste » comparable à l'intelligence humaine. Elle laisse entrevoir un futur à la fois fascinant et inquiétant, où l'IA sera capable d'égaler voire de surpasser le cerveau humain…

- Partager l'article :