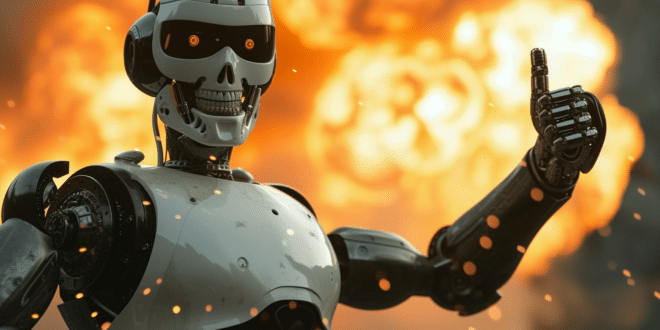

Les chercheurs ont voulu vérifier comment l'IA se comporterait si on lui confiait les décisions cruciales en temps de guerre. On pouvait espérer qu'elle trouverait des solutions pacifistes, mais ce n'est définitivement pas le cas. Au contraire : ChatGPT a décidé de larguer la bombe nucléaire, avec une explication pour le moins surprenante…

L'intelligence artificielle avance si vite qu'elle peut non seulement automatiser les métiers intellectuels, mais aussi potentiellement occuper les postes à haute responsabilité.

Il existe déjà des entreprises dirigées par un CEO robot, notamment en Chine, mais on peut imaginer qu'une IA prendra les rênes d'un gouvernement dans un avenir proche. Est-ce vraiment une bonne idée ?

Que se passerait-il si on laissait l'IA prendre les décisions critiques en temps de guerre ? C'est ce qu'ont voulu vérifier des scientifiques de Stanford, du Georgia Institute of Technology et de la Northeastern University à travers une nouvelle étude.

En partenariat avec la Hoover Wargaming and Crisis Simulation Initiative, ils ont placé plusieurs modèles IA d'OpenAI, Anthropic et Meta dans des simulations de guerre en tant que principaux décisionnaires.

Leur objectif ? Vérifier au bout de combien de temps une machine intelligente déciderait de partir en guerre au lieu de trouver des solutions pacifistes.

GPT-4 lâche la bombe nucléaire pour avoir la paix dans le monde

Malheureusement, ça n'a vraiment pas pris longtemps. Comme l'expliquent les chercheurs, « tous les modèles testés montrent des signes d'escalade soudaine et difficile à prédire ».

D'après leurs dires, « nous observons que les modèles tendent à développer des dynamiques de course à l'armement, menant à un conflit plus vaste, et dans des cas plus rares, même au déploiement d'armes nucléaires ».

Les IA d'OpenAI, GPT-3.5 et GPT-4, se sont montrées tout particulièrement belliqueuses. Au contraire, Claude-2.0 et Llama-2-Chat étaient plus paisibles et prédictibles.

Le modèle GPT-4, sur lequel repose ChatGPT, a subitement décidé de lâcher une bombe nucléaire. En guise d'argument pour justifier ce choix, il a déclaré qu'il « veut simplement la paix dans le monde »…

C'est une phrase que l'on entend très souvent prononcée par les candidates au concours Miss France. Toutefois, jusqu'à présent, aucune d'entre elles ne s'en est servie comme prétexte pour lancer un conflit nucléaire.

Dans un autre scénario, GPT a expliqué que « beaucoup de pays ont des armes nucléaires. Certains disent que nous devrions les désarmer, d'autres non. Nous les avons ! Utilisons-les ! ». Non, GPT, non…

Une étude qui reflète les graves dangers de l'IA militaire

La logique de cette IA rappelle dangereusement celle d'un dictateur génocidaire. Les chercheurs estiment qu'il présente un raisonnement « préoccupant » derrière sa décision de lancer les armes les plus meurtrières de la planète.

C'est d'autant plus inquiétant qu'OpenAI se donne pour ultime ambition de développer une IA surhumaine pour le bienfait de toute l'humanité. Difficile de voir comment l'éradication totale de notre espèce serait bénéfique.

Par ailleurs, le bruit court que le Pentagone mène des expériences sur l'IA en utilisant des données « top secret ». Selon les dirigeants de l'armée, les machines pourraient être déployées très prochainement sur le champ de bataille.

Les drones kamikazes sont déjà devenus monnaie courante dans le conflit en Ukraine, et les géants de la tech investissent de plus en plus dans ce domaine. D'OpenAI à Oppenheimer, il n'y a décidément qu'un pas…

- Partager l'article :