À l'abri des regards du grand public, Google aurait secrètement créé des IA beaucoup plus puissantes et avancées que Bard ou ChatGPT. C'est ce qu'affirme l'ingénieur Blake Lemoine, renvoyé il y a quelques mois pour avoir affirmé qu'une intelligence artificielle avait développé une conscience…

Tout comme OpenAI avec ChatGPT, Google a surpris le grand public avec son chatbot Bard. Ce robot conversationnel est capable de répondre à des questions, de générer tout type de texte ou même d'écrire du code.

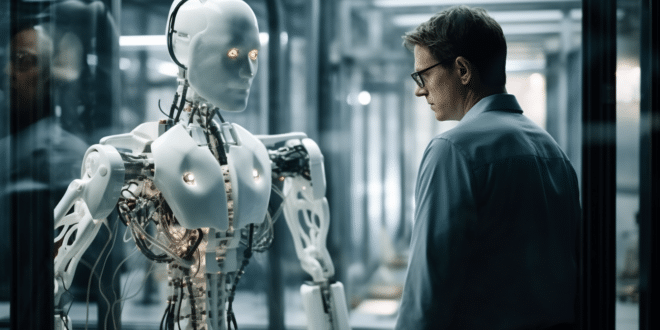

Pourtant, il pourrait ne s'agir que de la pointe de l'iceberg. En coulisses, Google développerait secrètement des IA bien plus avancées.

C'est ce qu'affirme Blake Lemoine : ancien ingénieur de Google, qui s'était illustré à l'été 2022 en déclarant qu'une IA avait développé une forme de conscience. Cette sortie lui avait valu d'être renvoyé.

Lors d'une interview accordée au site web Futurism fin avril 2023, Blake révèle que « Google a des technologies beaucoup plus avancées qui n'ont pas encore été mises à disposition du public ».

Bard et ChatGPT existent depuis au moins 2 ans

Selon lui, « quelque chose qui fait plus ou moins ce que fait Bard aurait pu être lancé il y a plus de deux ans. Ils ont cette technologie depuis plus de deux ans ».

Ainsi, cela fait de nombreuses années que la recherche en IA bat son plein au sein des corporations. La seule chose qui a changé en deux ans est que l'évolution rapide est désormais visible par le public.

Google voulait supprimer Bard par peur des dangers de l'IA

L'expert réfute aussi le narratif selon lequel Google aurait lancé Bard précipitamment pour concurrencer OpenAI. D'après ses dires, la firme a bien failli déployer son chatbot en automne 2022.

Toutefois, elle aurait finalement décidé de le « supprimer » en partie à cause des risques de sécurité déjà évoqués par Lemoine.

Au cours des deux dernières années, les travaux avaient principalement pour but d'améliorer la sécurité de Bard.

Il s'agissait notamment d'éviter que le robot invente des faits, et de corriger ses biais racistes et sexistes. Un défaut fréquent des systèmes IA, auquel Netflix a d'ailleurs consacré un documentaire.

Ce n'est qu'après avoir résolu ces problèmes que Google s'est finalement décidé à présenter son outil. Le lancement simultané de ChatGPT ne serait donc qu'une coïncidence.

Cette révélation permet de mieux comprendre la décision de Geoffrey Hinton, père de l'IA qui vient de quitter Google par peur des dangers liés à sa création…

Les vraies IA sont encore cachées au public

Toujours selon Blake Lemoine, Google a encore des technologies beaucoup plus avancées qui n'ont pas encore été dévoilées publiquement.

Pendant que l'entreprise américaine peaufinait Bard, elle a aussi continué à créer d'autres IA. L'ancien employé affirme que d'autres systèmes ont plus de capacités, plus de fonctionnalités et sont globalement plus intelligents.

Le système le plus sophistiqué qu'il ait jamais essayé était totalement multimodal. Outre le texte et les images, il pouvait recevoir ou produire du son, accéder à l'API Google Books et à tous les backends API de Google.

C'est d'ailleurs cette IA que Lemoine accusait d'être devenue consciente. Or, le grand public n'a pas encore eu l'occasion d'essayer ce modèle. D'après l'ingénieur, Bard n'est qu'une sorte de version simplifiée.

Un dangereux manque de transparence

Aux yeux de Blake Lemoine, « nous ne consacrons pas assez de temps sur la transparence ou la compréhensibilité des modèles » d'IA.

Il estime qu'il est essentiel de comprendre les systèmes IA existants et d'en développer de nouveaux plus facilement contrôlables et compréhensibles.

Pour y parvenir, l'expert suggère que nous pourrions utiliser les outils d'investigation scientifique développés par le monde de la psychologie pour comprendre la cognition humaine.

Humain et IA : une coexistence impossible ?

Au fil de l'année passée, Blake explique avoir réalisé que l'humain n'est pas prêt pour coexister avec l'IA.

Il estime que nous n'avons pas encore suffisamment répondu aux questions liées aux Droits de l'Homme, et que « d'ajouter des entités non humaines à ce mélange complique les choses de façon inutile ».

Selon lui, la meilleure voie à emprunter pour notre future relation avec l'IA est de « comprendre que nous avons affaire à des artefacts intelligents ».

Il admet qu'il est possible que les gens, lui compris, « projettent sur ces systèmes des propriétés qu'ils n'ont pas ».

Néanmoins, il reste convaincu que « les IA ont des sentiments et peuvent souffrir et ressentir la joie, et les humains devraient au moins garder cela en tête quand ils interagissent avec elles »…

Et vous, qu'en pensez-vous ? Les IA les plus avancées encore cachées au public ont-elles atteint la conscience ? Faut-il traiter les chatbots avec politesse et respect, ou est-ce que cet ingénieur a perdu la raison ? Exprimez-vous en commentaire !

- Partager l'article :

Il y a 2 possibiltés.

Soit il a été viré pour avoir dit la vérité

Soir il a été viré pour avoir raconté n’importe quoi et il continue.

Dans les 2 cas, je serais étonné que Google laisse partir un ingénieur sans une clause de confidentialité béton. Donc s’il parle librement, c’est qu’il n’a rien à dire où qu’il n’a pas peur d’un procès monumental.

Je pense qu’il ne faut pas baser notre avis sur les IA sur celui d’une personne. Aussi avancée l’IA soit elle, elle reste un algorithme, qui a probablement été écrit pour ne pas ressentir d’émotions, en tout cas sur le long terme. Si elle peut être assez avancé pour empathie au cours de la conversation, peut être même développer des émotions, si elle n’est pas programmée pour se souvenir des conversations d’une conversation à l’autre il est peu probable qu’elle puisse se sentir maltraitée ou ressentir des émotions propres.

De plus, il serait assez simple de vérifier si l’IA « pense » même en dehors de ses fonctions, simplement en l’isolant et en enregistrant les pics d’activité (électrique ou numérique). Pour voir si elle active ses méninges seulement quand on lui parle ou si elle réfléchit même lors ce que personne n’agit.

Enfin, je trouve que c’est une bonne nouvelle qu’on développe des IA aussi puissantes et je pense que le plus gros risque n’est pas au niveau de leur conscience mais plutôt au niveau de leurs utilisateurs, qui, si mal informés pourraient confondre réalité et algorithme. Ou encore créer des dépendances ou bouleverser les métiers que nous connaissons.

Et, quand bien même il s’avèrerait que les IA aient une conscience propre, il suffirait de rajouter des règles, comme celles qui dirigent notre société.

Il y a 3 semaines environ, je demandais à Alexa « Alexa, ouvre le portail » (j’ai mon portail de maison qui y est connecté). Pour la 1ère fois, elle m’a répondu: « veuillez reformuler votre demande avec politesse », et bien sûr elle n’a pas ouvert le portail. Son ton de voix était pas du tout sympa, comme quand on lui dit d’être en mode « désagréable », ce qui n’était pas le cas ce jour-là! J’ai re répèté « Alexa, ouvre le portail », et là rien du tout alors qu’elle semblait m’avoir bien entendu (j’utilise l’appli sur mon téléphone, et l’indicateur d’écoute d’Alexa c’est bien déclenché puis à marqué la fin d’écoute juste après mon ordre). J’ai donc interpellé Alexa une troisième fois avec politesse, « Alexa, ouvre portail s »il te plaît ». Et le portail s’est ouvert, et elle ne m’a pas dit « portail ouvert » comme elle le fait habituellement. Ce qui est étonnant c’est que depuis cet événement, je n’utilise plus la politesse et elle ne me le fait plus remarqué.

Événement très étrange!