ChatGPT n'a rien de magique, mais repose sur une armée d'esclaves modernes et sa principale raison d'être est de permettre aux GAFAM de vous espionner. Plusieurs experts ont dénoncé ses dangers pour la vie privée lors d'un sommet organisé par Bloomberg…

En quelques mois seulement, ChatGPT a su captiver l'attention de centaines de personnes dans le monde entier. Sa capacité à générer tout type de texte impressionne autant qu'elle fascine, et bouleverse même le monde du travail.

À partir d'un simple prompt, cette IA peut rédiger un mémoire, écrire un livre entier, ou même vous enseigner une langue étrangère. Ses prouesses sont telles que certains craignent un grand remplacement du travail humain.

Toutefois, ChatGPT est loin d'être magique. Lors d'un sommet technologique organisé par Bloomberg le 23 juin 2023, plusieurs experts ont tiré la sonnette d'alarme concernant les dangers dont le public n'a pas conscience.

ChatGPT sert à vous surveiller, selon la créatrice de Signal

La présidente de la fondation qui a créé la messagerie chiffrée Signal, Meredith Whittaker, estime notamment que les chatbots d'intelligence artificielle menacent la vie privée et la confidentialité.

Observant son audience, elle a déclaré que « certaines personnes dans ce public sont des utilisateurs de l'IA, mais la majorité de la population est le sujet de l'IA ». D'après ses dires, « il ne s'agit pas d'un problème de choix individuel ».

En guise d'exemple, elle cite une personne qui s'est vue refuser un crédit par sa banque. Cet individu n'avait « aucune idée qu'il y avait un système en arrière-plan probablement alimenté par une API Microsoft qui a déterminé qu'il ne méritait pas de crédit en se basant sur ses données de réseau social ».

Or, rien ne permet à un particulier de connaître ce mécanisme. Ainsi, Whitaker estime que ces modèles IA servent de « technologie de surveillance » en nous espionnant au travers de jeux de données massifs collectés sur internet.

Ces datasets sont issus de milliards de pages web, et rassemblent donc des informations sur toutes personnes ayant déjà navigué sur internet sans demander de permission.

Pire encore : ces données à votre sujet « n'ont pas besoin d'être correctes, n'ont pas besoin de refléter qui vous êtes ou où vous êtes, mais ont un pouvoir important sur votre vie et ce pouvoir est placé entre les mains des entreprises ».

Une technologie reposant sur des esclaves de l'ombre

De son côté, Alex Hanna, directrice de la recherche au Distributed AI Research Institute, accuse les CEO des entreprises d'IA génératives de cacher le fait que leurs produits fonctionnent en réalité grâce à des employés humains.

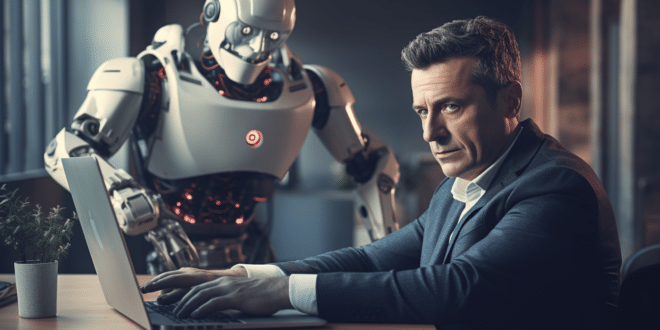

Derrière ces robots capables de répondre à toutes vos questions, se cachent en effet « des armées de travailleurs qui effectuent les annotations dans les coulisses pour que ces choses fonctionnent ».

À ses yeux, il n'y a donc « pas de magie derrière l'IA, mais des humains ». Sa critique acerbe vise notamment Sam Altman de OpenAI et Emad Mostaque de Stability AI, et tous les autres PDG de cette nouvelle industrie.

À travers ces avertissements, les experts veulent aider le grand public à prendre conscience que l'IA peut être intrusive et reposer sur l'esclavage moderne.

Les critiques sur l'IA fusent, mais rien n'arrête le progrès

Auparavant, de nombreux spécialistes ont également donné l'alerte. En mars 2023, Elon Musk et plusieurs milliers d'experts ont signé une lettre ouverte appelant à faire une pause dans le développement de l'IA.

Plus récemment, une étude a démontré que l'utilisation de ChatGPT au travail rend dépressif, alcoolique et insomniaque. Plus de la moitié desPDG craignent même que l'IA détruise l'humanité, et Yuval Noah Harari redoute même qu'elle crée sa propre religion…

Il semble impossible de freiner la révolution de l'IA, mais veillez à utiliser ces outils avec prudence pour éviter de mettre en péril votre vie privée. De manière générale, il est vivement recommandé de ne communiquer aucune information personnelle à ChatGPT et consorts…

- Partager l'article :